Nginx服务

1、Nginx基础Http协议

1. Http协议介绍

1.1 什么是URL

通常我们在访问一个网站页面时,请求到的内容通称为"资源"。而”资源“这一概念非常宽泛,它可以是一份文档,一张图片,或所有其他你能够想到的格式。每个资源都由一个 URI 来进行标识;

比如: http://file.ops.com/public/tt.jpg 这样的资源,我们会将该其称为URL地址;

百度百科解释:URL简称统一资源定位符,用来唯一地标识万维网中的某一个资源。URL由协议、主机名称、端口以及文件名几部分构成。

1.2 什么是HTML

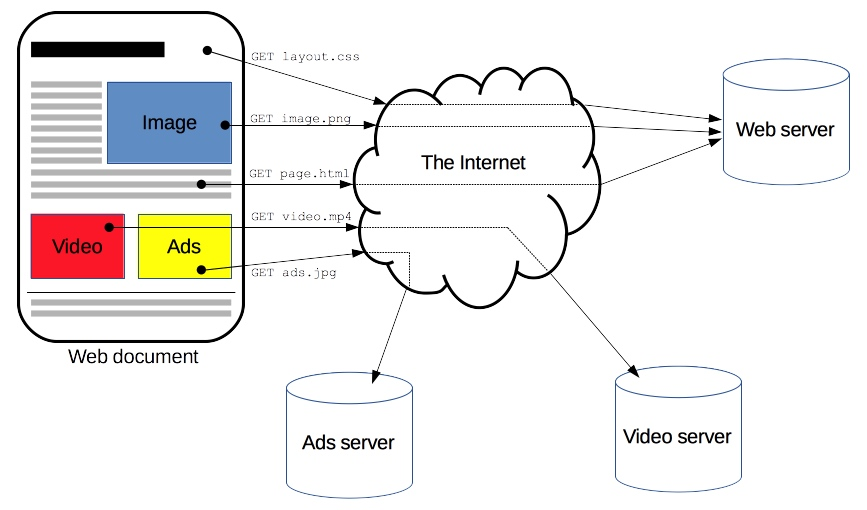

Html简称Web Page,一个完整的Html页面可能会包含很多个URL的资源。(反之: 我们也可以理解一个HTML文件是由多个不同的URL资源拼接而成的。)

1.3 什么是HTTP

HTTP (Hyper Text Transfer Protocol) 中文名为超文本传输协议。

是一种能够获取如 HTML 这样网络资源的通讯协议。它是在 Web 上进行数据交换的基础。HTTP的概述参考URL 简单理解:HTTP协议就是将用户请求的HTML页面从一台Web服务器传输到客户端浏览器的一种协议。

1.4 URL、HTML、HTTP之间关系

一个完整的

HTML页面是由多个不同的Url资源组成的;而HTTP协议主要是用来传输这种HTML页面的;http://web.ops.com:80/image

https://web.ops.com:80/video SSL

2. Http工作原理

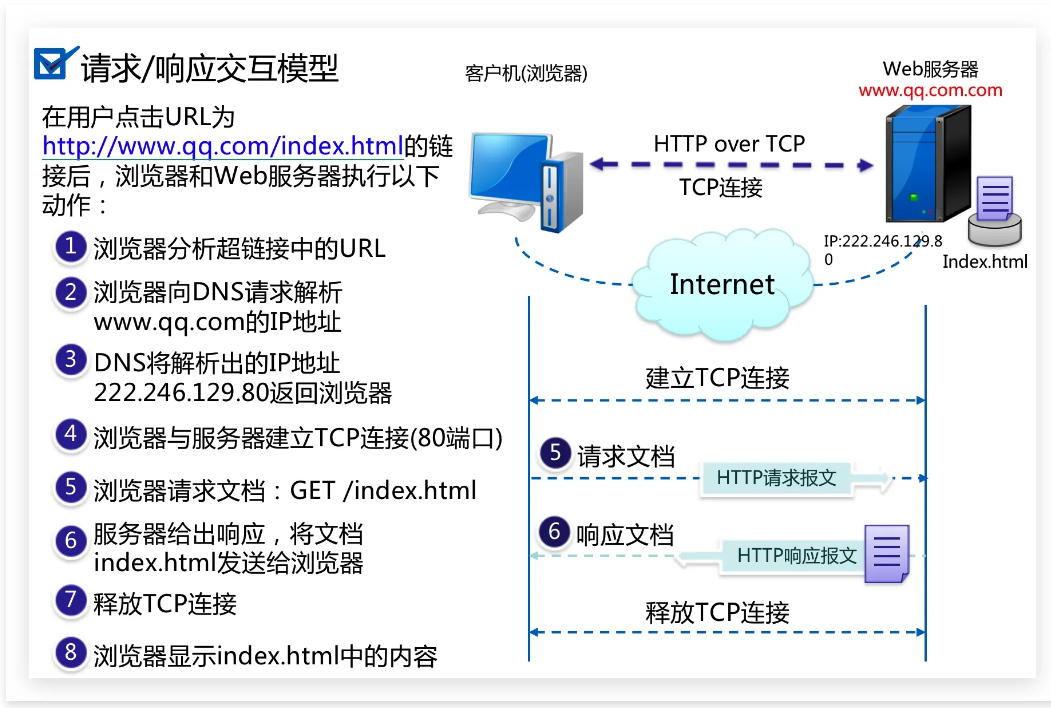

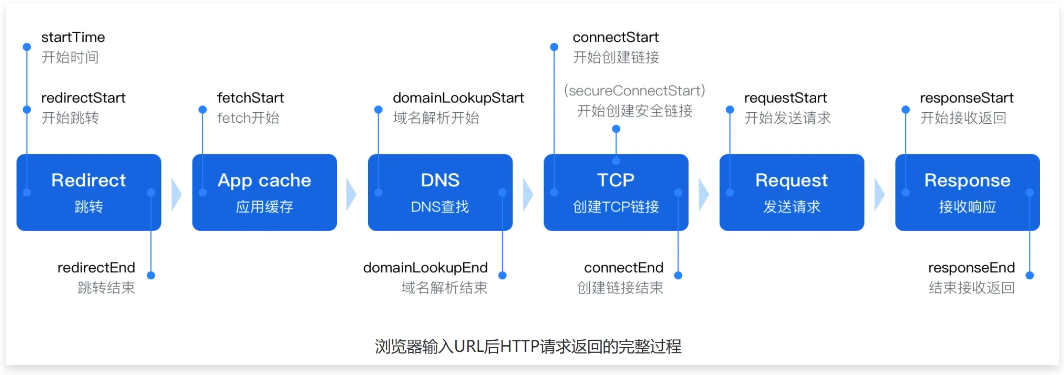

2.1 图解HTTP工作原理

我们详细的了解下HTTP的工作原理,我们到底是如何获取到服务器上的页面。

2.2 抓包分析HTTP原理

第一步:浏览器分析超链接中的URL

DNS

第二步:DNS请求

[root@ubuntu2204 ~]#ping baidu.comPC向DNS服务器223.5.5.5发出DNS QUERY请求,请求baidu.com的A记录

第三步:DNS回复

DNS服务器223.5.5.5回复DNS response,解析出baidu.com域名对应的一条A记录39.104.16.126

HTTP

第五步:Http请求

[root@ubuntu2204 ~]#curl www.baidu.comPC向 baidu.com 服务器发出GET请求,请求主页

第六步:Http响应

baidu.com 服务器回应HTTP/1.1 200 OK,返回主页数据包

第七步:连接断开

完成数据交互过程,四次挥手断开连接

2.3 HTTP工作原理总结

整个用户访问网站过程就是 DNS-TCP-HTTP (面试必须的协议)

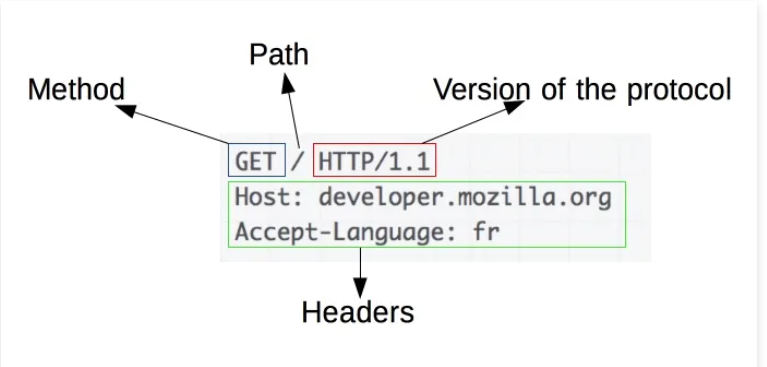

3. Http请求Request

HTTP 请求的一个例子:

3.1 请求Method

客户端向服务端发送请求时,会根据不同的资源发送不同的请求方法Method:

GET:用于获取URI对应的资源;(比如看朋友圈) 99 100

POST:用于提交请求,可以更新或者创建资源,是非幂等的;(发布朋友圈)

PUT:用于向指定的URI传送更新资源,是幂等的;(更新朋友圈)

DELETE:用于向指定的URI删除资源;(比如删朋友圈)

HEAD:用于检查(仅获取Header部分的内容;)

一般创建对象时用POST,更新对象时用PUT;

PUT是幂等的,POST是非幂等的;

幂等:对于相同的输入,每次得到的结果都是相等的;

3.2 请求Header

:authority: www.baidu.com

:method: GET

:path: /

:scheme: https

Accept: text/html # 请求的类型

Accept-Encoding: gzip, deflate # 是否进行压缩

Accept-Language: zh-CN,zh;q=0.9 # 请求的语言

Cache-Control: max-age=0 # 缓存

Connection: keep-alive # TCP长连接

Host: www.baidu.com # 请求的域名

If-Modified-Since: Fri, 04 May 2024 08:13:44 GMT# 修改的时间

User-Agent: Mozilla/5.0 # 请求浏览器的工具

"=== 请求一个空行 ==="

"=== 请求内容主体 ==="3.3 请求Connection

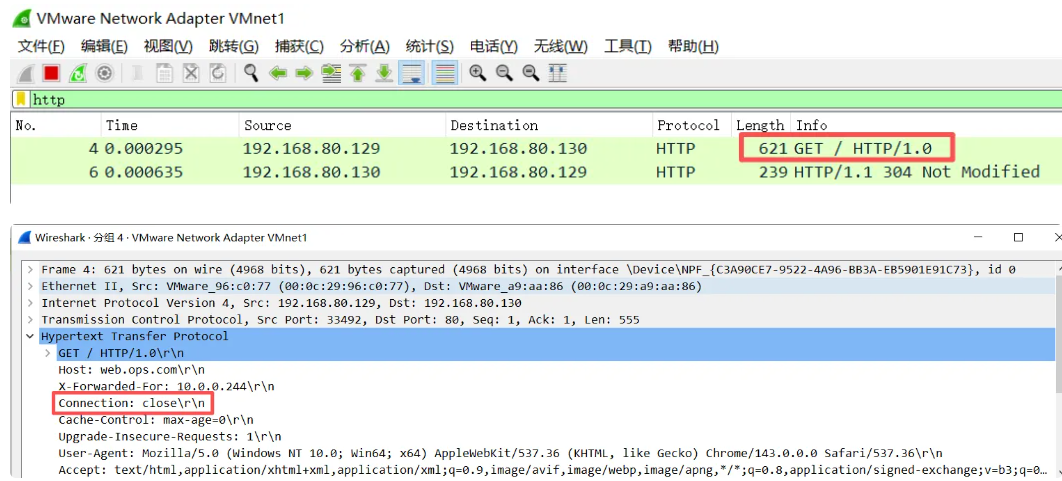

Http请求中的长连接与短连接是什么:

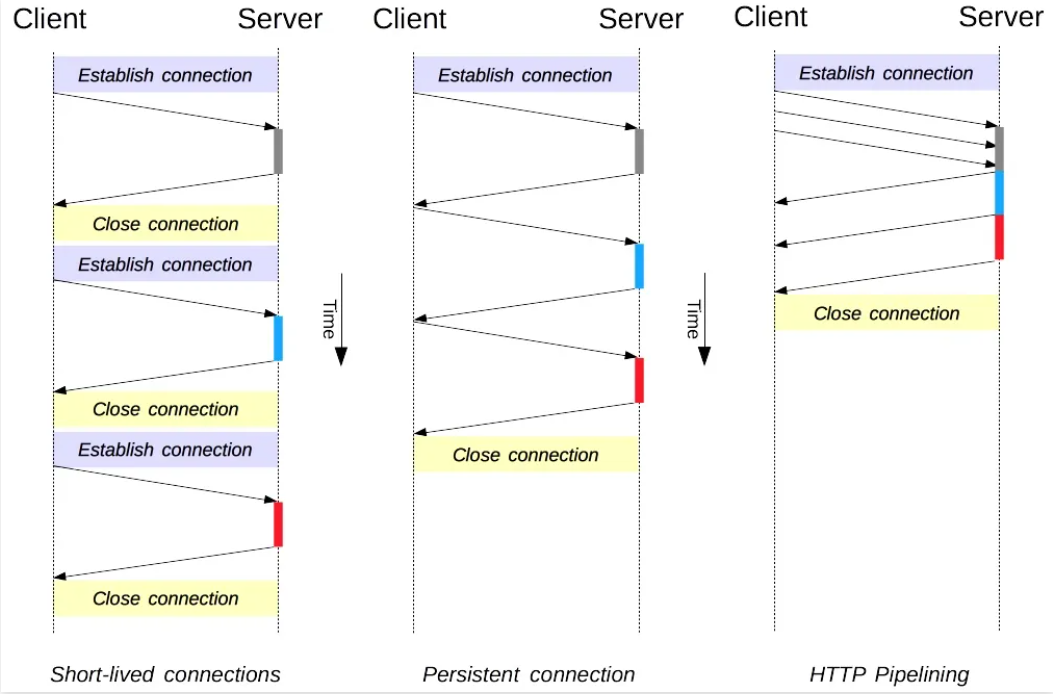

http1.0 协议使用的是短连接:建立一次tcp的连接,发起一次http的请求,结束,tcp断开。

http1.1 协议使用的是长连接:建立一次tcp的连接,发起多次http的请求,结束,tcp断开。

HTTP协议版本参考URL、HTTP1.1与HTTP2.0速度对比

4. Http响应Response

4.1 响应Header

#服务端响应的头部信息

HTTP/1.1 200 OK # 返回服务器的http协议,状态码

Date: Fri, 14 Sep 2018 09:14:28 GMT # 返回服务器的时间

Server: Apache/2.4.6 # 返回服务器使用的软件Apache

Connection: Keep-Alive # TCP长连接

Keep-Alive: timeout=5, max=100 # 长连接的超时时间

"=== 返回一个空行 ==="

"=== 返回内容主体 ==="4.2 响应Status

http 响应状态码 Status-Code 以3位数字组成,用来标识该请求是否成功,比如是正常还是错误等,HTTP/1.1 中状态码可以分为五大类。

4.3 响应Code

以下是常见状态码

5. Http相关术语

5.1 什么是PV

PV即页面浏览量:比如用户访问一个网站算1个pv,刷新一次页面则累计pv+1,如果多次打开或刷新同一页面则浏览量累计。假设我们对一个网站的A页面和B页面分别刷新了10次,请问该用户总共产生了多少PV?

5.2 什么是UV

UV即独立访客,访问网站的一台电脑客户端为一个访客。可以理解成访问某网站的电脑的数量。比如电脑、手机算2个UV,无论访问多少次网站,最终UV数量就是2。

5.3 什么是IP

IP即独立公网IP数,是指1天内多少个独立的IP浏览了页面,比如你在家通过拨号上网访问某个网站,此时网站会记录你的公网IP地址。那如果你在公司和很多同事同时访问一个网站,那该网站会记录多少个公网IP呢? (看公司有多少个出口公网地址)

5.4 什么是并发

并发:指的是同时,我们可以理解为一段时间内(比如10秒),网站支持同时访问的人数,假设10s并发值如果为500时,一天能达到多少PV? 500 * 6 * 60 * 24 =4320000

5.5 扩展延伸

1.请计算如下题的 IP、PV、UV、并发

假设公司有一座大厦,大厦有100人,每个人有一台电脑和一部手机,上网都是通过NAT转换,每个人刷新网站10次,请问对应的 pv,uv,ip,并发分别是多少。PV:页面浏览量 100人 * 2设备 * 10次刷新 = 2000pvUV:独立的客户 100人 * 2设备 = 200UVIP:独立公网IP 100人--> NAT = 1个独立IP并发:单位时间内100人同时请求网站,200

2.面试题:上家公司的IP、PV,UV是多少?(运营)

小说网站 1分钟并发 50006024=720w (屌丝、通常一看一天)

教育网站 1分钟并发 100006024=1440w (努力青年、通常周末量大)

金融网站 1分钟并发 500*1440= 72w (有钱人、所以量不大、但交易额度高)

电商网站 1分钟并发 游戏网站 ------在线用户、日活跃数、月活跃数

需要注意的是: 这仅仅是参考值,因为不同的业务他们的pv都不一样。

3.面试题: 上家公司的IP、PV、UV是如何统计的?

方式一:使用awk提取IP,sort排序、uniq统计去重统计IP

方式二:第三方统计工具进行pv统计,比如:piwik、腾讯分析、百度统计、开发自研统计平台。

2、Nginx基础网络IO模型

1. IO基本概述

1.1 什么是IO

所谓

IO,无非就是输入输出,其实大家更多关注的是磁盘IO,事实上当我们在网络中传送一些数据时,他本质上也是一种IO。

1.2 什么是网络IO

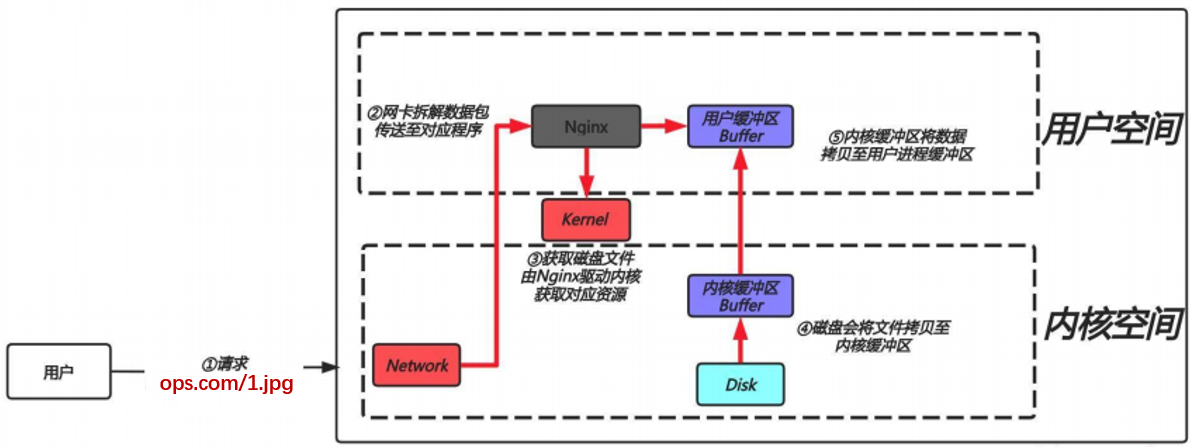

那用户请求

Nginx这样的web服务器获取磁盘中的文件时,系统是如何处理的?

通过上面的例子,用户每一次请求都会发生一次IO操作:而每次IO,都要经由两个阶段:

第一步:将数据从磁盘加载至内核的内存空间(缓存区),等待数据准备完成,时间较长。

第二步:将数据从内核缓冲区复制到用户空间的进程内存(缓存区),时间较短。

第三步:Nginx封装数据为响应报文发送。

nginx下发指令给内核后,nginx是等待,还是不等待继续处理新的请求;

数据拷贝到内核缓存中了,通知nginx应用程序,阻塞;

2. IO网络模型

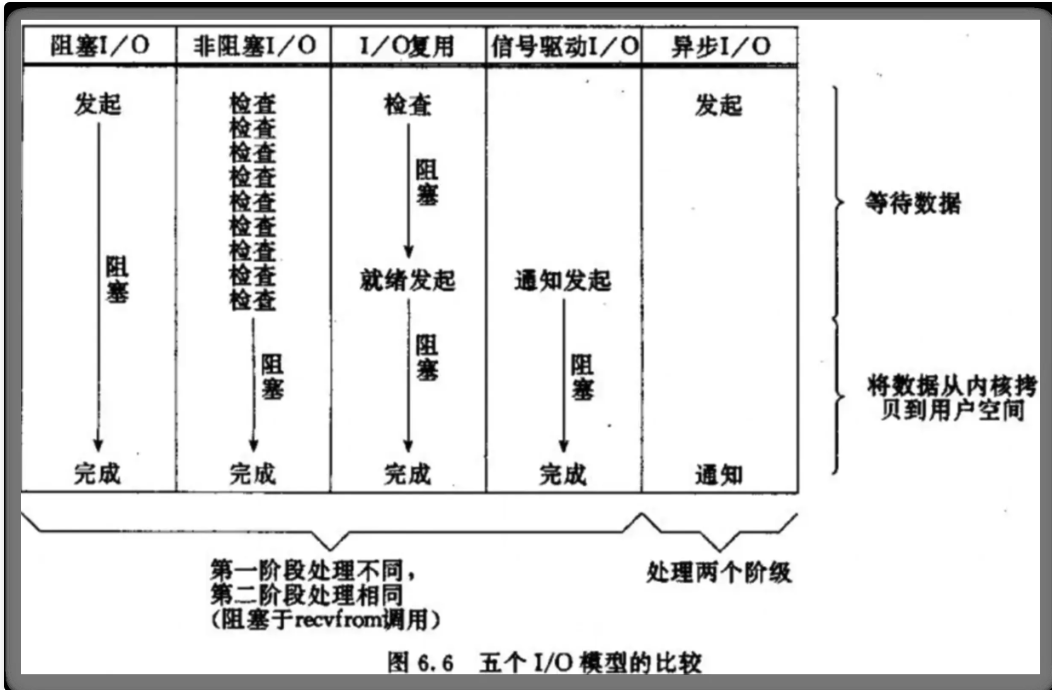

IO模型分为、同步、异步、阻塞、非阻塞

2.1 同步/异步

同步/异步( 关注的是消息通知机制 ) leader(等待)-->小弟-->任务-->漫长

同步:调用者发指令给被调用者,被调用者需要获取资源后在返回给调用者,那么此时调用者需要等待被调用者返回消息,也就意味着调用者啥也干不了。(举例:当我们将衣服扔进洗衣服,那么衣服洗完没洗完也不知道,那就需要过一段时间去看一下,对于调用者来说很繁忙。)

异步:调用者发指令给被调用者,被调用者需要获取资源后在返回给调用者,此时”被调用者“会主动将当前的运行状态通知给调用者。(举例:当我们将衣服扔进洗衣机,当洗衣机完成洗衣服之前我们可以做点别的事情,等洗完后洗衣机会通知,此时我在去晾衣服。)

2.2 阻塞/非阻塞

阻塞/非阻塞( 关注的是“调用者”在等待”被调用者“返回结果之前所处的状态 )

阻塞:指

IO操作需要彻底完成后才返回到用户空间,调用结果返回之前 ,调用者被挂起。(举例:将衣服仍给洗衣机,然后人一直在旁边等着,什么时候洗完什么时候执行下一步动作。)非阻塞:指

IO操作被调用后立即返回给用户进程一个状态值,无需等待IO操作彻底完成,在最终的调用结果返回之前,调用者不会被挂起。(举例:将衣服仍给洗衣机,然后可以去干其他的事情,等洗完后,在去处理。)

2.3 IO组合模型

同步阻塞:将衣服仍到洗衣机,然后守在洗衣机旁边,等待他什么时候洗完什么时候处理。

同步非阻塞:将衣服仍到洗衣机,然后可以去干别的事情,那是否洗完不知道,就需要时不时看一下。

异步阻塞:将衣服仍给洗衣机,还是会在旁边等着(阻塞),洗衣机洗完了会通知。

异步非阻塞:将衣服仍给洗衣机,可以去干其他事情,等待洗衣机洗完了会通知,然后在去取衣服。

3. 五种常见IO模型

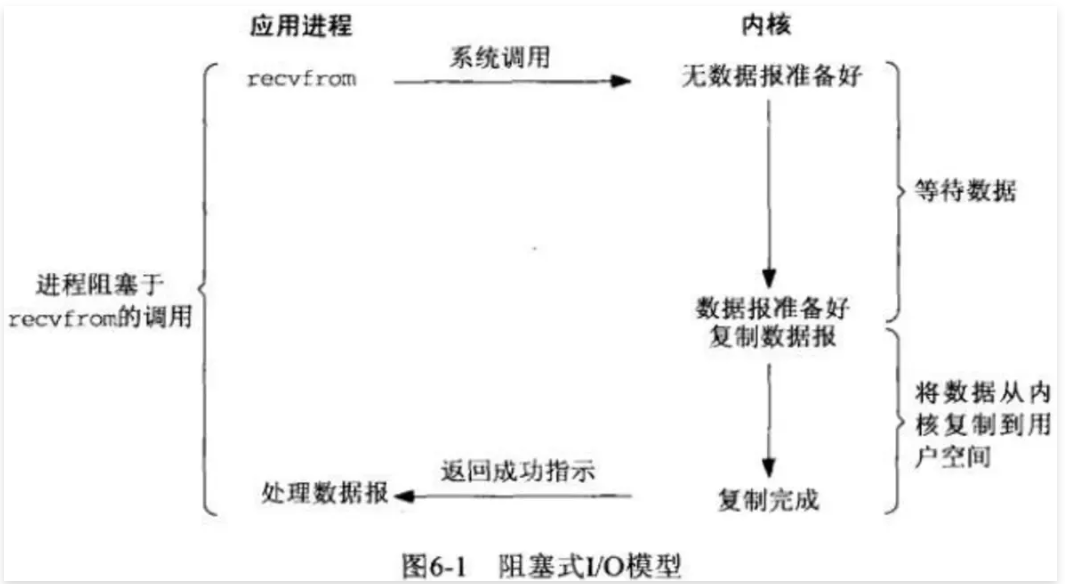

3.1同步阻塞IO

1.当用户进程调用了recvfrom()这个系统调用,希望从磁盘获取数据。

2.kernel就开始了IO的第一个阶段,准备数据,如果数据需要很长时间 ,那么就需要一直等待。

3.当kernel数据准备好了,会将数据从kernel中拷贝到用户进程内存,然后kernel返回数据结果,用户进程才解除阻塞状态,可以做其他事情。

总结,同步阻塞IO的特点就是在IO执行的两个阶段都被阻塞了。那么也就意味着一个进程只能响应一个用户请求,剩下请求会被挂起,会造成每次只能响应一个请求。

举例:我和女友点在饭店完餐后,不知道什么时候能做好,只好坐在餐厅里面等,直到做好,然后吃完才离开。女友本来还想和我一起逛街,但是不知道饭能什么时候做好,只好和我一起在餐厅等,而不能去逛街,直到吃完饭才能去逛街,中间等待做饭的时间浪费掉了。这就是阻塞IO。

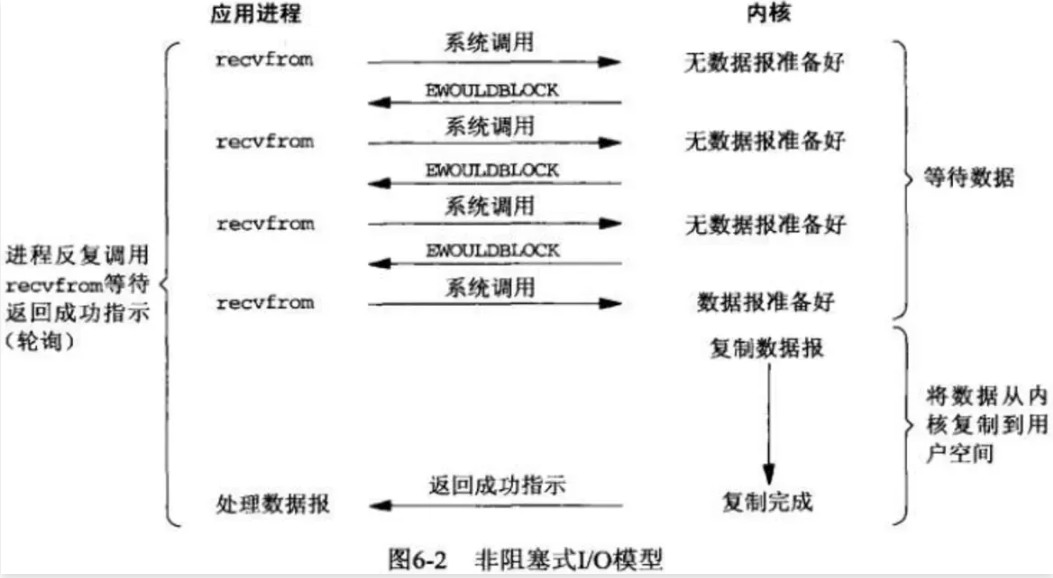

3.2 同步非阻塞IO

1.当用户进程调用了recvfrom()这个系统调用,希望从磁盘获取数据。

2.那么是否完成并不知道,需要一次一次的去问。

3.当kernel中的数据准备好了,此时用户进程再次发起系统调用,那么它马上将数据拷贝到了用户进程内存所以,非阻塞IO的特点是用户进程需要不断的主动询问kernel数据好了没有。

好处:用户进程可以处理其他任务;

坏处:任务完成的响应延迟增大了,因为每过一段时间才去轮询一次read操作;

举例:我女友不甘心傻等,又想去逛商场,又担心饭好了。所以我们逛一会,回来询问服务员饭好了没有,来来回回好多次,饭都还没吃都快累死了。这就是非阻塞。需要不断的询问,是否准备好了。

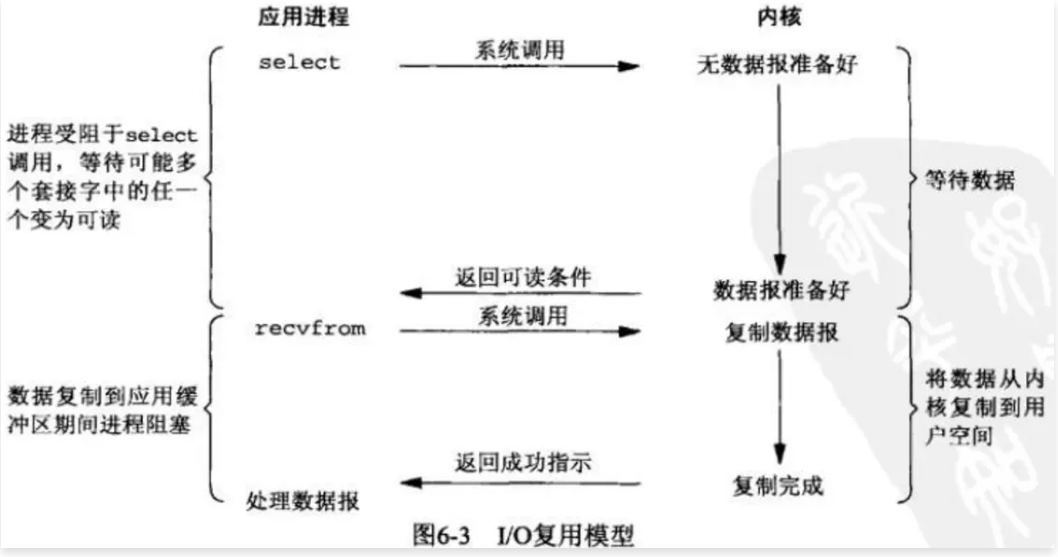

3.3 IO多路复用

1.当用户进程发起调用请求,不用直接与内核交互,而是找一个代理进程select,当用户进程调用select,那么整个进程会阻塞在select上(因为是由select与内核进行交互,需要等待select返回结果)

2.kernel会“监视”select负责的数据,当任何一个进程的数据准备好了,select就会返回。

3.当 select 用户进程返回结果后,用户程序会再次进行系统调用,将 kernel 数据拷贝到用户进程。总结,select代理进程,它这一个进程可以接收多个用户进程的请求。(类似于用户-->飞猪-->办理签证)

举例:与第二个方案差不多,餐厅安装了电子屏幕用来显示点餐的状态,这样我和女友逛街一会,回来就不用去询问服务员了,直接看电子屏幕就可以了。这样每个人的餐是否好了,都直接看电子屏幕就可以了,这就是IO多路复用。

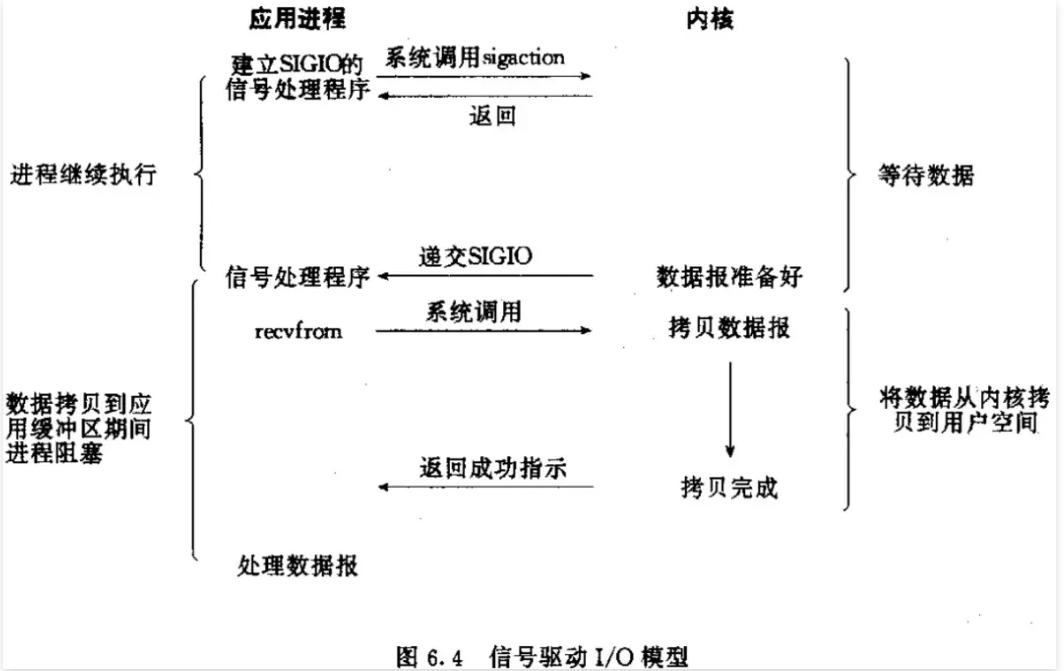

3.4 信号驱动IO

1.当用户进程调用了 recvfrom() 这个系统调用,希望从磁盘获取数据。

2.磁盘文件中的数据如果还没有读取到内核缓冲区时,没关系,进程还可以继续运行并不阻塞。

3.当磁盘数据复制到内核中后,会通知用户进程数据准备就绪。

4.用户进程在发指定将内核中数据复制到用户进程中,此时进程会进入阻塞状态。

举例:我和女友通过手机点完餐后,系统会返回下单成功。此时我和女友就可以出去逛街一会,直到手机通知你的餐已经做好,我和女友在回来吃饭,但吃饭过程会被阻塞。

通知机制:

水平触发:多次通知;

边缘触发:只通知一次;

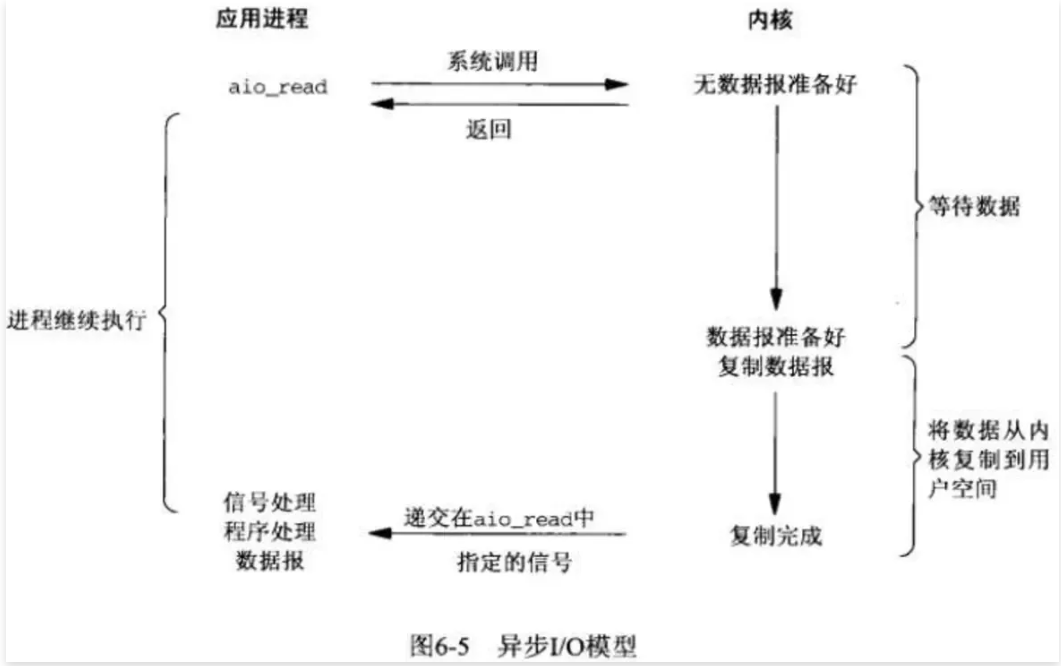

3.5 异步非阻塞IO

1.当用户进程调用了recvfrom()这个系统调用,希望从磁盘获取数据。

2.kernel收到后,会立刻返回,所以不会对用户进程产生任何阻塞。

3.kernel等待数据准备完成,并将内核数据拷贝到用户进程内存,当这一切都完成之后,kernel会给用户进程发送一个回调函数通知用户进程本次IO完成。

举例:女友不想逛街,餐厅又太吵了,准备回家好好休息一下。于是我们叫外卖,打个电话点餐,然后我和女友在家好好休息一下,饭好了,外卖会送到家里来。这就是异步非阻塞

举例:女友不想逛街,餐厅又太吵了,准备回家好好休息一下。于是我们叫外卖,打个电话点餐,然后我和女友在家好好休息一下,饭好了,外卖会送到家里来。这就是异步非阻塞IO

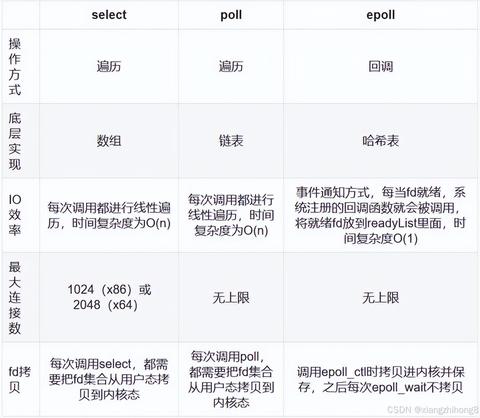

3.6 IO模型对比

4. IO模型实现

4.1 几种网络IO模型实现

Select:对应,I/O复用模型,遍历,(1000 --O(500))

Poll:对应,I/O复用模型

Epoll:对应,IO复用模型,具有信号驱动I/O模型某些特性(O(1))

4.2

无论是 select、poll、epoll 都可以面对多个用户进程的请求,它相当于一个代理人,收集很多用户进程的请求,收集完成后,它帮你从磁盘上获取数据,复制到内核中,那么这个数据准备没准备好,它的实现机制是不一样的。

通知方式:假设有一个用户数据准备好了,那么还有很多用户数据没准备好,那么如何通知呢?

1、select和poll是遍历扫描,效率低下。2、epoll采用回调机制,epoll会主动通知,效率会更高。

IO效率:假设100个用户发请求和1000个用户发请求,在遍历的时候的性能一样吗?

1、select和 poll用户的请求越多,所需要遍历的就越多,需要耗时就越长。2、epool采用的是回调方式,无论有多少用户,它发送的时间是一样的。

总结:1、nginx从最初设计时,就是使用的 epoll IO 模型,使用边缘触发机制。2、同时 nginx 还支持异步IO,用了近几年最新的服务端编程技术,来支持较好的并发。

3、Nginx Web快速入门

1. Nginx基本简述

1.1 什么是Nginx

Nginx是一个开源且高性能、可靠的Http Web服务、代理服务。

开源,体现在直接获取

Nginx的源代码(F5公司收购);高性能,体现在支持海量的并发;

高可靠,体现在服务稳定;

1.2 为什么选择Nginx

1.2.1 高性能、高并发

通常正常情况下,单次请求会得到更快的响应。另一方面在高峰期(如有数以万计的并发请求),Nginx可以比其他Web服务器更快地响应请求。

select:O(n)

epool:O(1)

1.2.2 高扩展性

Nginx官方、第三方,提供了非常多优秀的模块提供使用,这些模块都可以实现快速增加和减少。

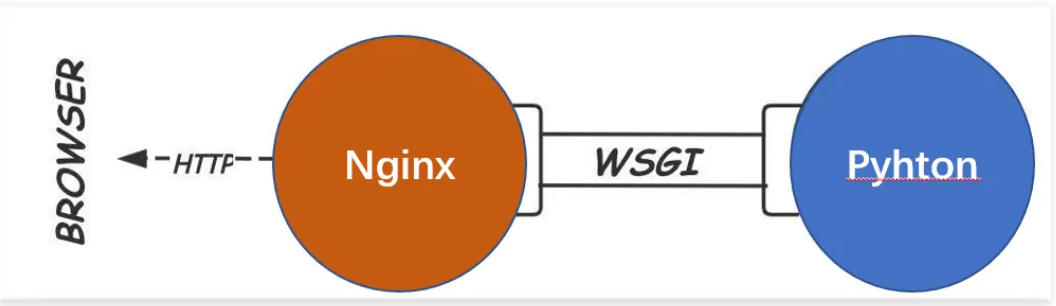

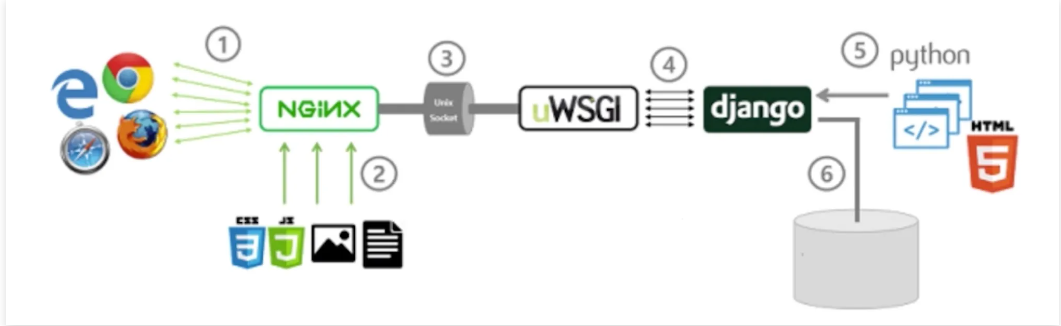

nginx ---> uwsgi ---> python--> py脚本文件

1.2.3 高可靠性

所谓高可靠性,是指Nginx可以在服务器上持续不间断的运行,而很多web服务器往往运行几周或几个月就需要进行一次重启。windows的 IIS对于nginx这样的一个高并发、高性能的反向代理服务器而言,他往往运行网站架构的最前端,那么此时如果我们企业如果想提供9999、99999,对于nginx持续运行能够宕机的时间,一年可能只能以秒来计算,所以在这样的一个角色中,nginx的高可靠性为我们提供了非常好的保证。

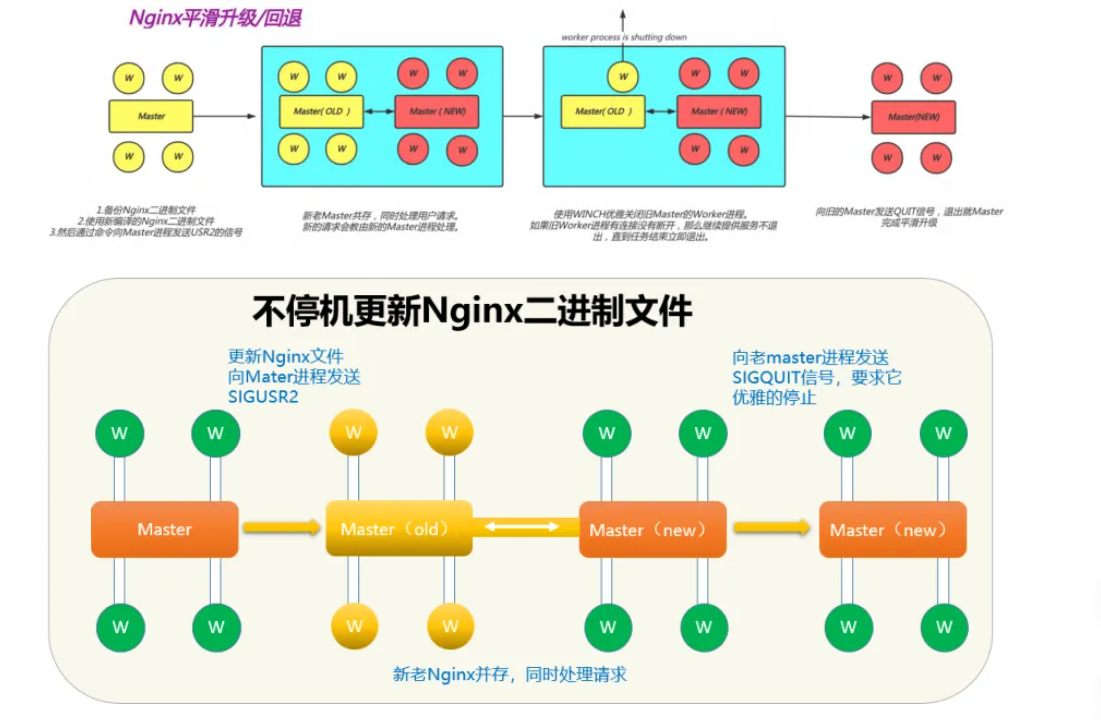

1.2.4 热部署

热部署是指在不停服务的情况下升级nginx,这个功能非常的重要。

对于普通的服务,只需要kill掉进程在启动,但对于Nginx而言,如果Nginx有很多的客户端连接,那么kill掉Nginx。Nginx会像客户端发送tcp reset复位包,但很多客户端无法很好的理解reset包,就会造成异常。

由于Nginx的master管理进程与worker工作进程的分离设计,使得Nginx能够在7×24小时不间断服务的前提下,升级Nginx的可执行文件。当然,也支持不停止服务更新配置、更换日志文件等功能。

1.2.5 应用广泛

首先Nginx技术成熟,具备企业最常使用的功能,如代理、代理缓存、负载均衡、静态资源、动静分离、Https、lnmp、lnmt等等其次使用Nginx统一技术栈,降低维护成本,同时降低技术更新成本。

tengine\OpenResty 都是基于Nginx进行的二次开发;

1.2.6 网络模型

Nginx使用Epool网络模型,而常听到Apache采用的是Select网络模型。

Select:当用户发起一次请求,select模型就会进行一次遍历扫描,从而导致性能低下。

Epoll:当用户发起请求,epoll模型会直接进行处理,效率高效。

1.3 Nginx应用场景

Nginx的主要使用场景我归纳为三个,分为是静态资源服务、代理资源服务、安全服务,场景详细介绍如下

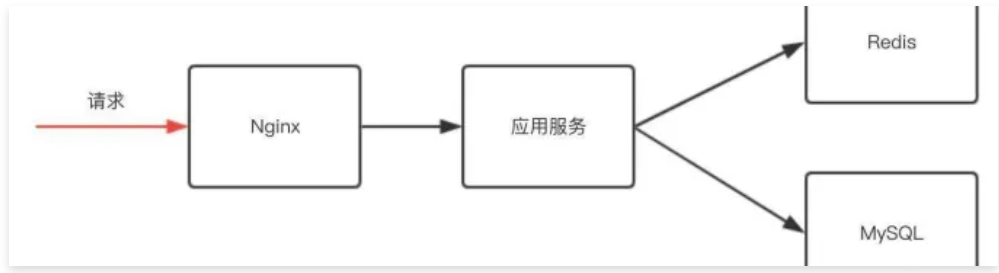

如下图是一个网站的基本架构,首先用户请求先到达nginx,然后在到 tomcat或php这样的应用服务器,然后应用服务器在去访问 redis、mysql这样的数据库,提供基本的数据功能。

1.3.1 负载均衡场景

那么这里有一个问题,我们的程序代码要求开发效率高,所以他的运行效率是很低的,或者说它并发是受限,所以我们需要很多应用服务组成一个集群,为更多用户提供访问。

而应用服务一但构成集群,则需要我们的nginx具有反向代理功能,这样可以将动态请求传倒给集群服务。

但很多应用构成集群,那么一定会带来两个需求。

1、应用服务器需要动态扩展。(手动扩展|自动扩展)

2、有些服务出问题需要做容灾。那么我们的反向代理必须具备负载均衡功能。

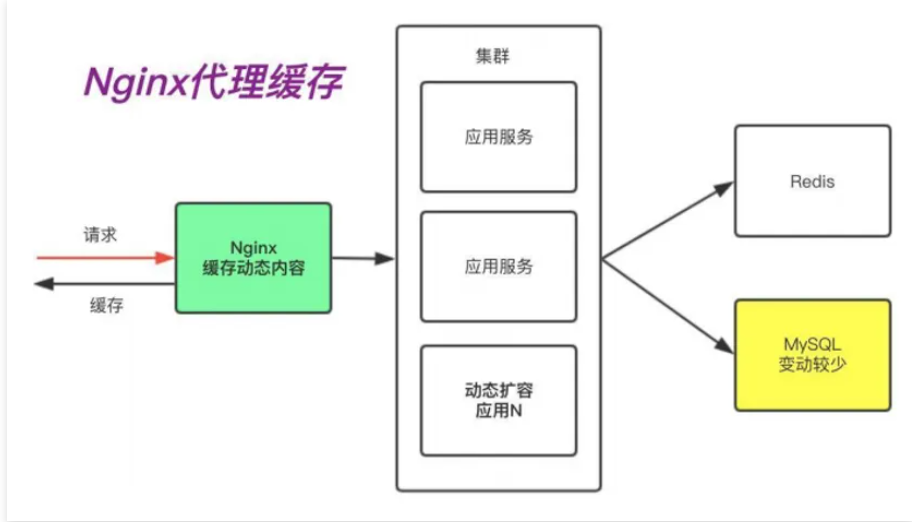

1.3.2 代理缓存场景

其次,随着我们网络链路的增长,用户体验到的时延则会增加。如果我们能把一段时间内不会发生变化的"动态"内容,缓存在Nginx,由Nginx直接向用户提供访问,那么这样用户请求的时延就会减少很多,所以在这里反向代理会演生出另外一个功能 "缓存",因为它能加速我们的访问。

1.3.3 静态资源场景

在很多时候我们访问docs、pdf、mp4、png等这样的静态资源时,是没有必要将这些请求通过Nginx交给后端的应用服务,我们只需要通过Nginx直接处理“静态资源”即可。这是Nginx的静态资源功能。

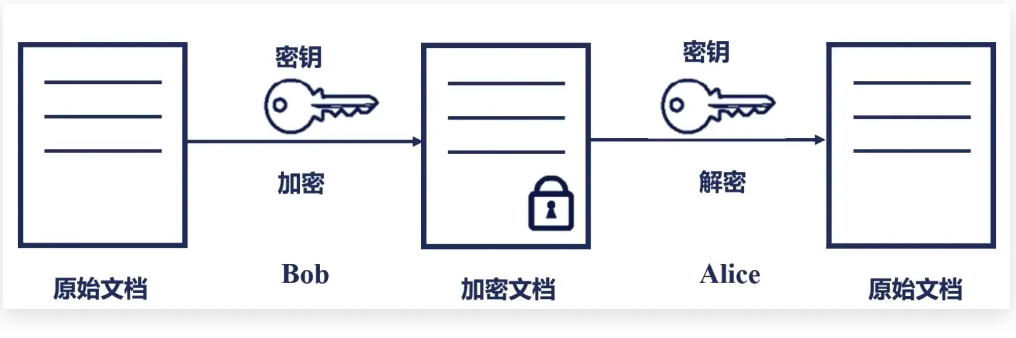

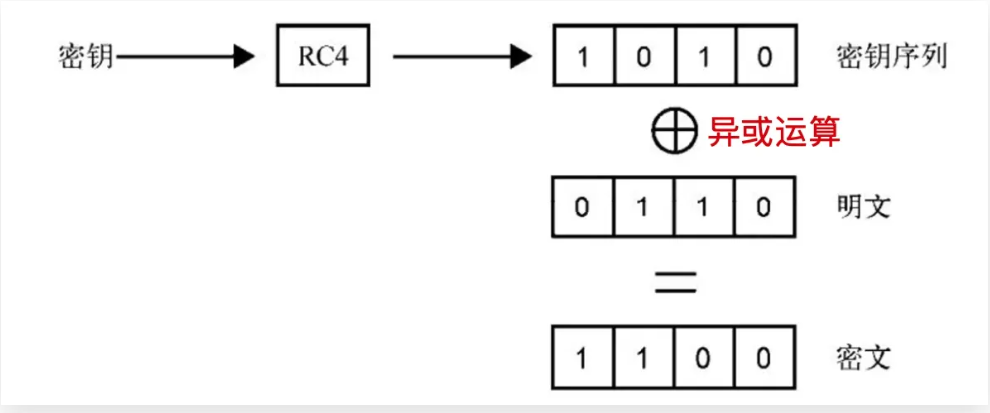

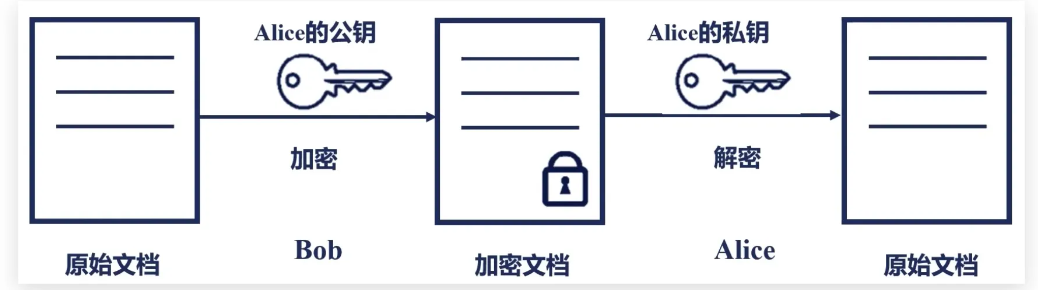

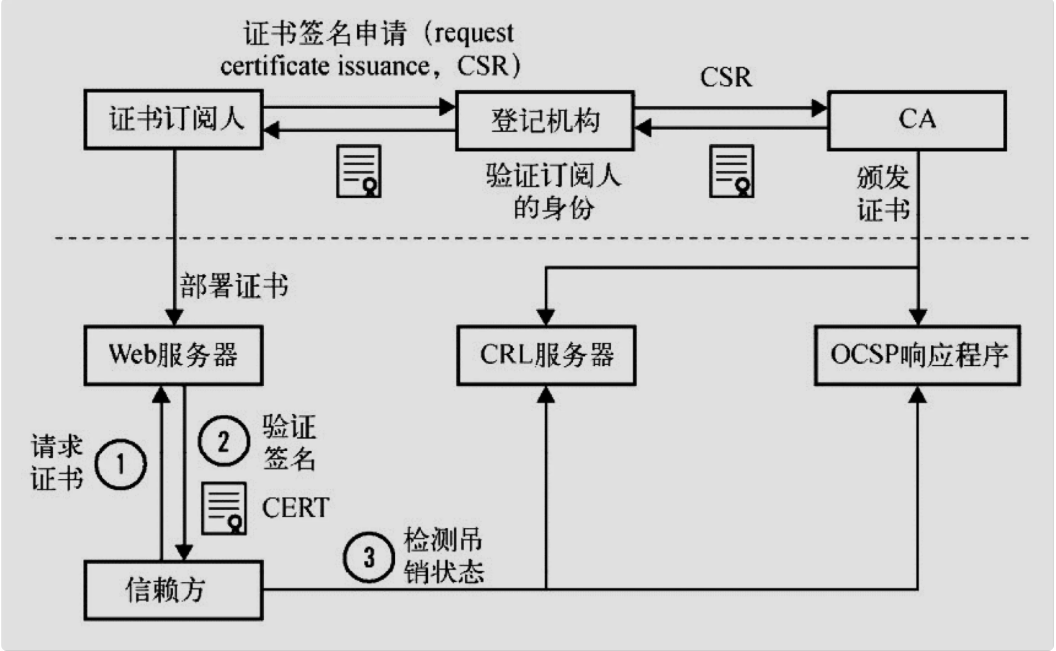

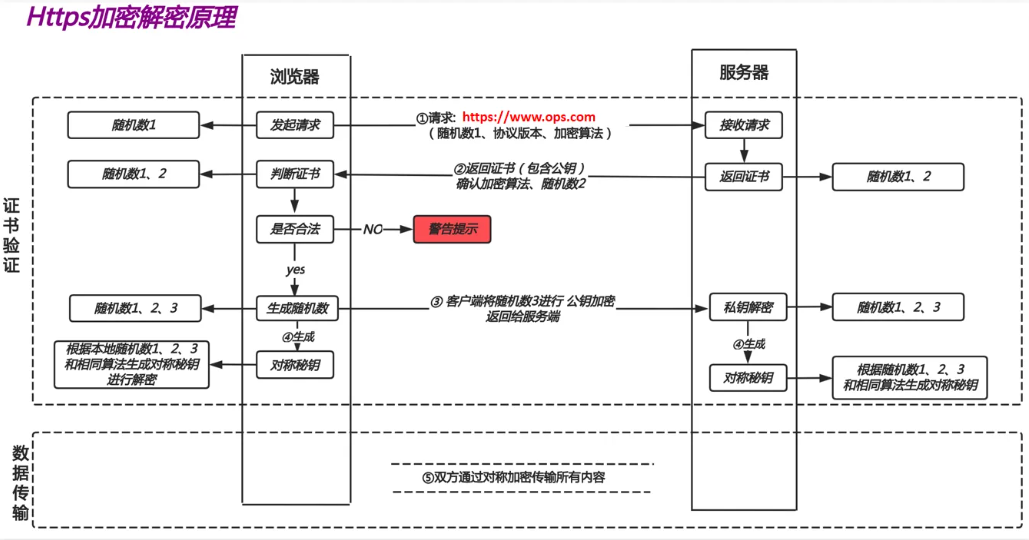

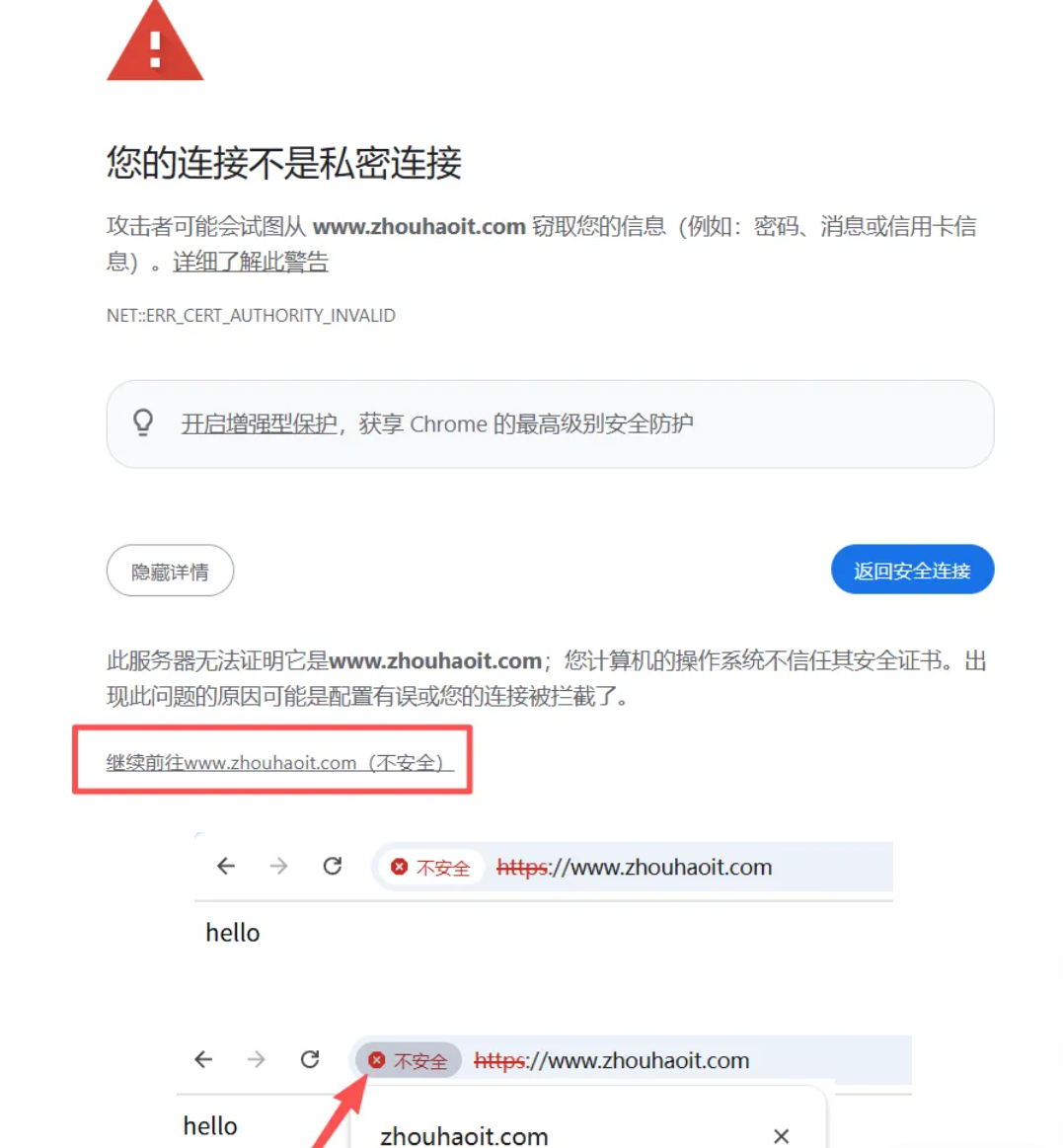

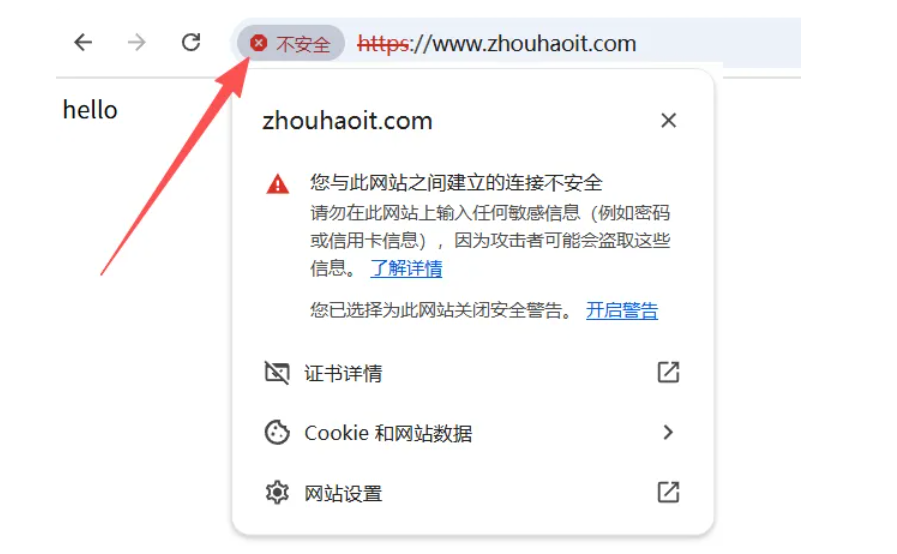

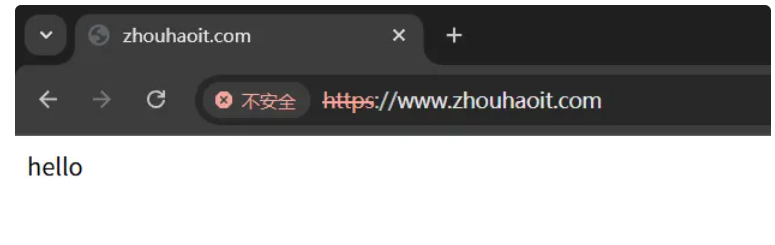

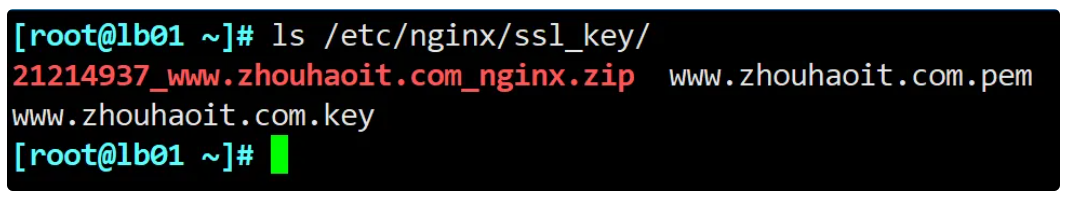

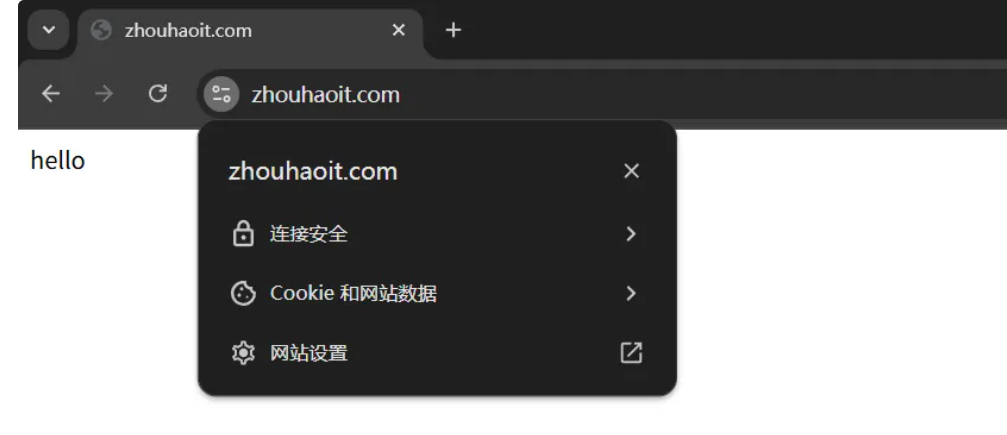

1.3.4 安全应用场景

当我们使用http网站时,可能会遭遇到篡改,如果使用https安全通讯协议,那么数据在传输过程中是加密的,从而能有效的避免黑客窃取或者篡改数据信息,同时也能避免网站在传输过程中的信息泄露。大大的提升我们网站安全。

1.4 Nginx组成部分

在这里我们将Nginx的组成架构比喻为一辆汽车:

这个汽车提供了基本的驾驶功能,但是还需要一个驾驶员控制这辆汽车开往哪个方向,同时该汽车行驶过的地方还会形成GPS轨迹,如果汽车在行驶的过程中出现了任何问题,我们需要一个黑匣子,分析是汽车本身的问题,还是驾驶人员的操作出现了问题。

第一个组成部分

Nginx二进制可执行文件:它是Nginx本身框架以及相关模块等构建的一个二进制文件,这个文件就相当于汽车本身,所有的功能都由它提供。第二个组成部分

Nginx.conf文件:它相当于驾驶人员,虽然二进制可执行文件已经提供了许多的功能,但是这些功能究竟有没有开启,或者开启后定义怎样的行为去处理请求,都是由nginx.conf这个文件决定的,所以他就相当于这个汽车的驾驶员,控制这个汽车的行为。第三个组成部分

access.log:它相当于这辆汽车经过所有地方形成的GPS轨迹,access.log会记录Nginx处理过的每一条HTTP的请求信息、响应信息。第四个组成部分

error.log:它相当于黑匣子,当出现了一些不可预期的问题时,可以通过error.log将问题定位出来。

Nginx组成部分小结:

Nginx的组成部分是相辅相成,Nginx二进制文件和Nginx.conf文件,它定义了Nginx处理请求的方式。

而如果我们想对Nginx服务做一些web的运营和运维,需要对access.log做进一步分析。

而如果出现了任何未知的错误,或者预期的行为不一致时,应该通过error.log去定位根本性的问题。

2. Nginx安装部署

2.1 安装Nginx方式

安装Nginx软件的方式有很多种,分为如下几种

1.源码编译=>Nginx (1.版本随意 2.安装复杂 3.升级繁琐)

2.epel仓库=>Nginx (1.版本较低 2.安装简单 3.配置不易读)

3.官方仓库=>Nginx (1.版本较新 2.安装简单 3.配置易读,强烈推荐)

2.2 安装Nginx依赖

[root@ops ~]# yum install -y gcc gcc-c++ autoconf pcre pcre-devel make automake httpd-tools vim2.3 配置Nginx源

[root@ops ~]# cat > /etc/yum.repos.d/nginx.repo <<'EOF'

[nginx-stable]

name=nginx stable repo

baseurl=http://nginx.org/packages/centos/$releasever/$basearch/

gpgcheck=1

enabled=1

gpgkey=https://nginx.org/keys/nginx_signing.key

EOF2.4 安装Nginx服务

[root@ops ~]# yum install nginx -y

[root@ops ~]# systemctl enable --now nginx2.5 访问Nginx服务

2.6 检查Nginx版本

# 检查版本

[root@ops ~]# nginx -v

nginx version: nginx/1.20.1

# 检查编译参数

[root@ops ~]# nginx -V

[root@centos7 ~]# nginx -V

nginx version: nginx/1.26.1

built by gcc 4.8.5 20150623 (Red Hat 4.8.5-44) (GCC)

built with OpenSSL 1.0.2k-fips 26 Jan 2017

TLS SNI support enabled

configure arguments: --prefix=/etc/nginx --sbin-path=/usr/sbin/nginx --modules-path=/usr/lib64/nginx/modules --conf-path=/etc/nginx/nginx.conf --error-log-path=/var/log/nginx/error.log --http-log-path=/var/log/nginx/access.log --pid-path=/var/run/nginx.pid --lock-path=/var/run/nginx.lock --http-client-body-temp-path=/var/cache/nginx/client_temp --http-proxy-temp-path=/var/cache/nginx/proxy_temp --http-fastcgi-temp-path=/var/cache/nginx/fastcgi_temp --http-uwsgi-temp-path=/var/cache/nginx/uwsgi_temp --http-scgi-temp-path=/var/cache/nginx/scgi_temp --user=nginx --group=nginx --with-compat --with-file-aio --with-threads --with-http_addition_module --with-http_auth_request_module --with-http_dav_module --with-http_flv_module --with-http_gunzip_module --with-http_gzip_static_module --with-http_mp4_module --with-http_random_index_module --with-http_realip_module --with-http_secure_link_module --with-http_slice_module --with-http_ssl_module --with-http_stub_status_module --with-http_sub_module --with-http_v2_module --with-mail --with-mail_ssl_module --with-stream --with-stream_realip_module --with-stream_ssl_module --with-stream_ssl_preread_module --with-cc-opt='-O2 -g -pipe -Wall -Wp,-D_FORTIFY_SOURCE=2 -fexceptions -fstack-protector-strong --param=ssp-buffer-size=4 -grecord-gcc-switches -m64 -mtune=generic -fPIC' --with-ld-opt='-Wl,-z,relro -Wl,-z,now -pie'3.Nginx目录结构

为了让大家更清晰的了解

Nginx软件的全貌,可使用rpm -ql nginx查看软件整体目录结构如下表格整理了

Nginx比较重要的配置文件

3.1 Nginx主配置文件

3.2 Nginx代理配置文件

3.3 Nginx编码配置文件

3.4 Nginx管理命令文件

3.5 Nginx日志相关文件

4.Nginx基本配置

Nginx主配置文件/etc/nginx/nginx.conf是一个纯文本类型的文件;Nginx整个配置文件是以区块的形式组织的。一般每个区块以一对大括号{}来表示开始与结束。

[root@ops ~]# cat /etc/nginx/nginx.conf

# 全局

user nginx; # nginx的运行身份为nginx用户;

worker_processes 2; # 启动的worker进程数量;

error_log /var/log/nginx/error.log warn;

# 错误日志的路径;从warning;

pid /var/run/nginx.pid;

# 存储进程的pid Number

# 4c * 16GB

events {

# 一个worker最大连接数

worker_connections 1024;

# worker_connections * worker_processes = 最大连接数

use epoll; # 默认是采用epoll网络IO模型;

}

# 主要负责接受与响应http请求

http {

include /etc/nginx/mime.types;

# 支持的类型;

default_type application/octet-stream;

# 默认类型(下载的方式)

# 1.提供下载包 zip

# 2.后端并没有将代码解析成功,所以直接成了下载;

# 定义日志的格式

log_format main '$remote_addr -$remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

# 访问日志

access_log /var/log/nginx/access.log main;

sendfile on;

#tcp_nopush on;

keepalive_timeout 65;

#长连接超时时间;

#gzip on;

include /etc/nginx/conf.d/*.conf;

# 包含的子文件;

}

######

# 一个server就是一个站点

server {

listen 80; # 监听的端口

server_name www.ops.net; # 站点的域名

location / { #uri路径匹配的

root /usr/share/nginx/html; #root:定义网站的路径;

index index.html index.htm; #index:定义默认返回的页面;

# root+index =/usr/share/nginx/html/index.html;

}

}

# 一个server就是一个站点

server {

listen 80; # 监听的端口

server_name db.ops.net; # 站点的域名

location / { #uri路径匹配的

root /usr/share/nginx/html; #root:定义网站的路径;

index index.html index.htm; #index:定义默认返回的页面;

# root+index =/usr/share/nginx/html/index.html;

}

}4.1 Global全局模块

user www; #Nginx进程所使用的用户

worker_processes 1; #Nginx运行的work进程数量(建议与CPU数量一致或auto)

error_log /log/nginx/error.log #Nginx错误日志存放路径

pid /var/run/nginx.pid #Nginx服务运行后产生的pid进程号4.2 Events事件模块

events {

worker_connections 25535; #每个worker进程支持的最大连接数

use epoll; #事件驱动模型, epoll默认

}4.3 HTTP核心模块

http { #http层开始

...

#使用Server配置网站, 每个Server{}代表一个网站(简称虚拟主机)

'server' {

listen 80; #监听端口, 默认80

server_name ops.com; #提供的域名

access_log access.log; #该网站的访问日志

#控制网站访问的路径

'location' / {

root /usr/share/nginx/html;

#存放网站源代码的位置

index index.html index.htm;

#默认返回网站的文件

}

}

...

#第二个虚拟主机配置

'server' {

...

}

include /etc/nginx/conf.d/*.conf; #包含/etc/nginx/conf.d/目录下所有以.conf结尾的文件

#include作用是:简化主配置文件写太多造成臃肿,这样会让整体的配置文件更加的清晰。

} #http层结束4.4 核心模块总结

Nginx中的http、server、location之间的关系

http标签主要用来解决用户的请求与响应;server标签主要用来响应具体的某一个网站;location标签主要用于匹配网站具体URI路径;

http{}下允许有多个Server{},一个Server{}下又允许有多个location{}

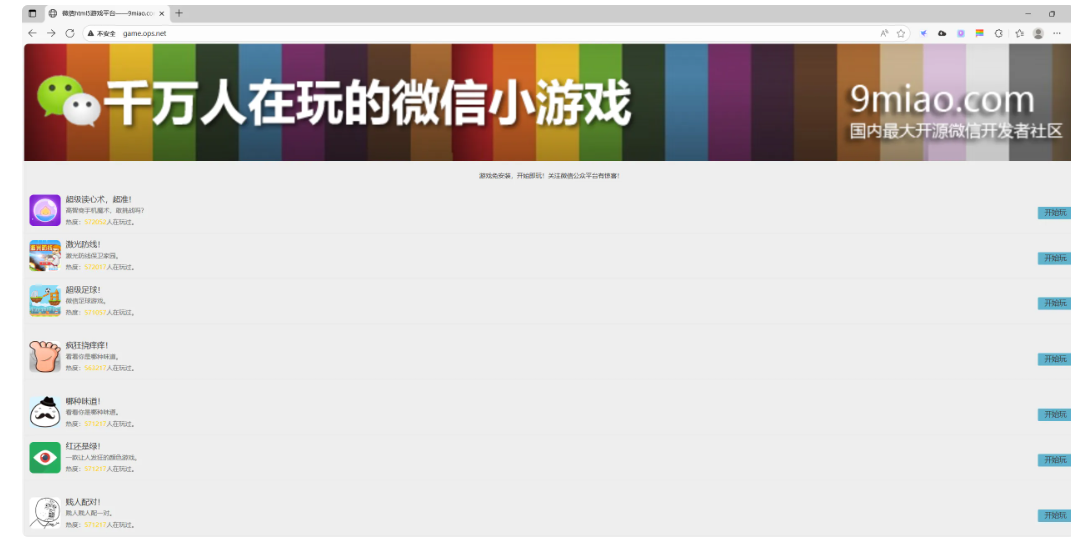

5.Nginx构建游戏网站

5.1 增加Nginx配置

[root@ops ~]# cat /etc/nginx/conf.d/game.ops.net.conf

server {

listen 80;

server_name game.ops.net;

location / {

root /code;

index index.html;

}

}5.2 上传游戏代码

[root@ops conf.d]# mkdir /code && cd /code

[root@ops code]# unzip html5.zip

[root@ops code]# ls

ceshi game html5.zip img index.html readme.txt5.3 检查配置语法

[root@ops /code]# nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful5.4 重启服务生效

[root@ops code]# systemctl reload nginx5.5 浏览器访问

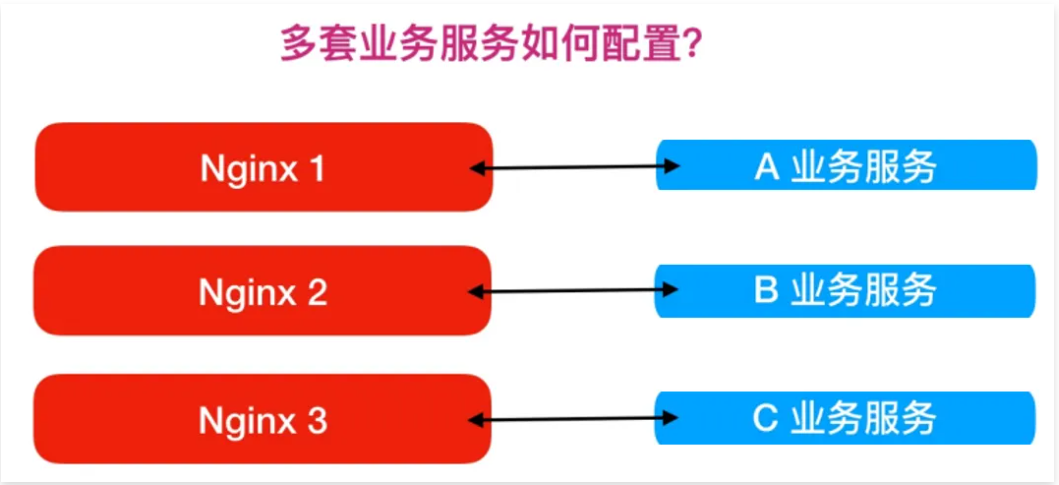

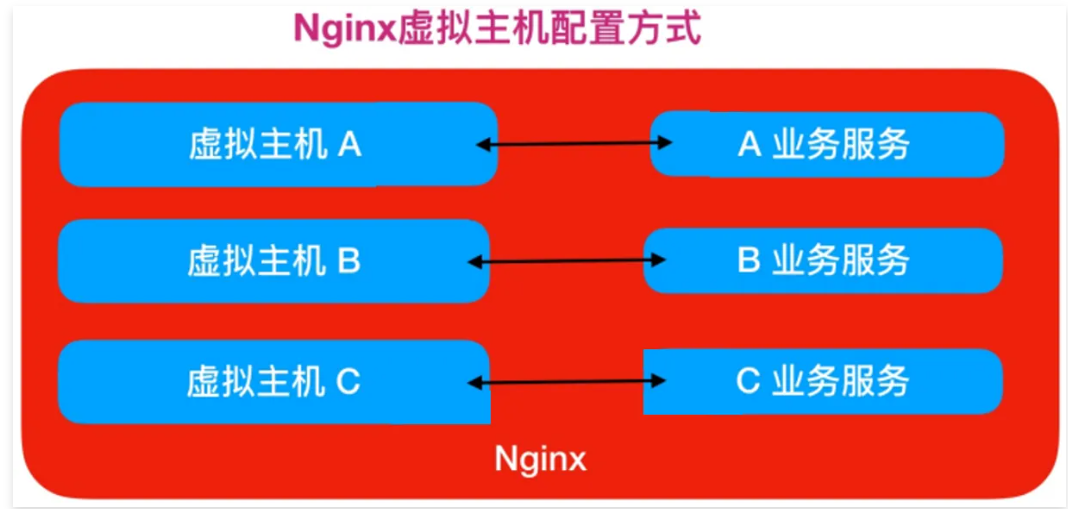

6.Nginx虚拟主机

6.1 Nginx虚拟主机概念

通常在企业中可能会有很多业务系统,那么多套业务服务如何使用Nginx配置?

如果使用如上方式部署,则需要多台服务器配置Nginx,但如果使用虚拟主机方式,则在同一个Nginx上运行多套单独服务,这些服务是相互独立的。

简单来说,看似多套业务系统,实则可以运行在一台Nginx服务上

6.2 Nginx配置虚拟主机方式

Nginx配置虚拟主机有如下三种方式

1、基于主机多

IP方式2、基于端口的配置方式

3、基于多个

hosts名称方式(多域名方式)

6.3 基于多IP虚拟主机实践

Nginx基于多IP虚拟主机具体配置如下

[root@ops ~]# cat /etc/nginx/conf.d/address.conf

server {

...

listen 10.0.0.10:80;

...

}

server {

...

listen 172.16.1.10:80;

...

}范例

[root@ops /etc/nginx/conf.d]# cat address.conf

server {

listen 192.168.10.137:80;

server_name game.ops.net;

location / {

root /code;

index index.html;

}

}

server {

listen 10.0.0.7:80;

server_name game.ops.net;

location / {

root /code;

index index.html;

}

}6.4 基于多端口虚拟主机实践

Nginx基于多端口虚拟主机具体配置如下

#仅修改listen监听端口即可, 但不能和系统端口出现冲突

[root@ops ~]# cat /etc/nginx/conf.d/port1.conf

server {

...

listen 80;

...

}

[root@ops ~]# cat /etc/nginx/conf.d/port2.conf

server {

...

listen 81;

...

}

[root@ops ~]# cat /etc/nginx/conf.d/port3.conf

server {

...

listen 82;

...

}范例

[root@ops /etc/nginx/conf.d]# cat port.conf

server {

listen 81;

server_name game.ops.net;

location / {

root /code;

index index.html;

}

}

server {

listen 82;

server_name game.ops.net;

location / {

root /code;

index index.html;

}

}6.5 基于多域名虚拟主机实践

Nginx基于多Host虚拟主机具体配置如下

[root@ops /etc/nginx/conf.d]# mkdir /code/server{1,2}

[root@ops /etc/nginx/conf.d]# echo "server1" > /code/server1/index.html

[root@ops /etc/nginx/conf.d]# echo "server2" > /code/server2/index.html

[root@ops /etc/nginx/conf.d]# cat server1.conf

server {

listen 80;

server_name server1.ops.net;

location / {

root /opt/server1/;

index index.html;

}

}

[root@ops /etc/nginx/conf.d]# cat server1.conf

server {

listen 80;

server_name server2.ops.net;

location / {

root /opt/server2/;

index index.html;

}

}4、Nginx 常用模块

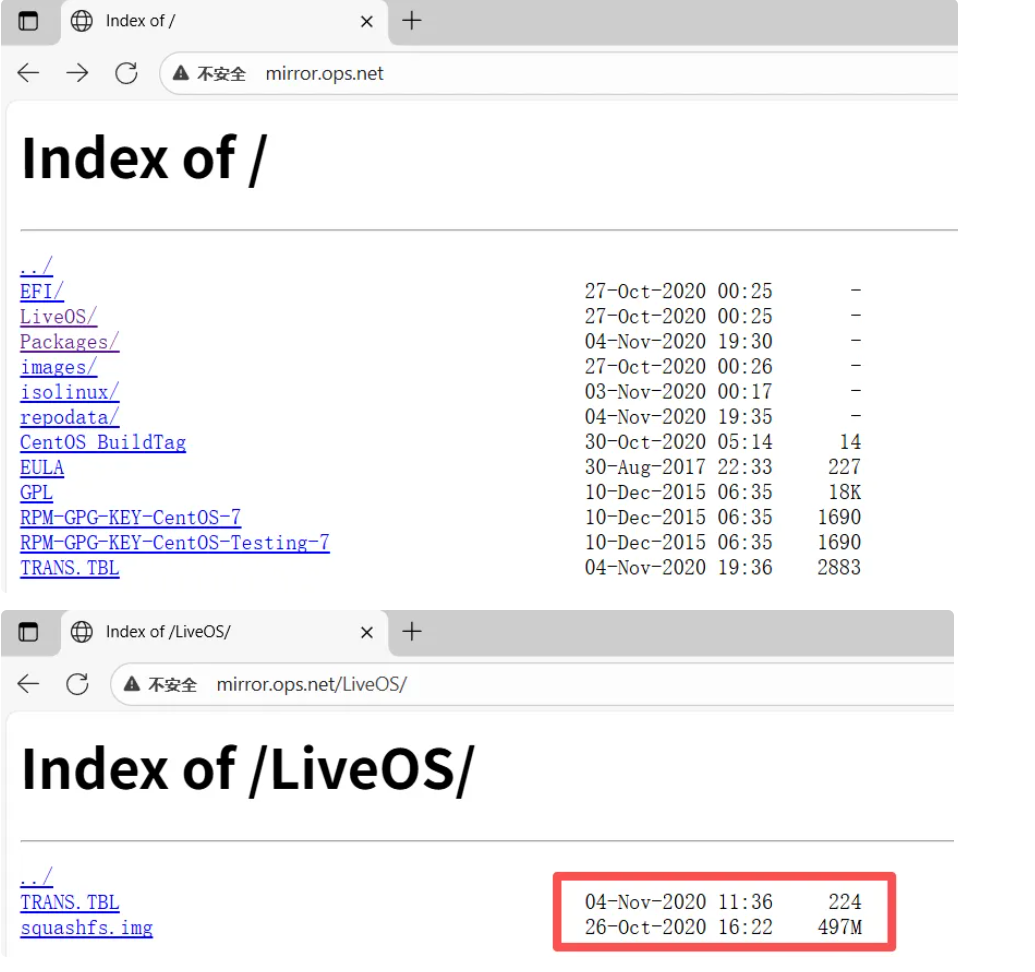

1 Nginx目录索引

当ngx_http_index_module模块找不到索引文件时,通常会将请求传递给ngx_http_autoindex_module模块。

ngx_http_autoindex_module模块处理以斜杠字符('/')结尾的请求,并生成目录列表。

由于Nginx是通过静态编译构建的(没有使用--add-dynamic-module),所以模块都是静态链接的。

可以通过查看Nginx的二进制文件来确认:

[root@ops ~]# strings /usr/sbin/nginx | grep ngx_http_autoindex_module

ngx_http_autoindex_module

ngx_http_autoindex_modulengx_http_autoindex_module是 Nginx 的核心模块,用于在客户端请求目录时自动生成并返回该目录的文件列表页面。

1.1 配置语法

#启用或禁用目录列表输出,on开启,off关闭

Syntax: autoindex on | off;

Default: autoindex off;

Context: http, server, location

#指定是否应在目录列表中输出确切的文件大小,on显示字节,off显示大概单位

Syntax: autoindex_exact_size on | off;

Default: autoindex_exact_size on;

Context: http, server, location

#指定目录列表中的时间是应以本地时区还是UTC输出,on本地时区,off UTC时间

Syntax: autoindex_localtime on | off;

Default: autoindex_localtime off;

Context: http, server, location

1.2 配置示例

[root@ops ~]# mount /dev/sr0 /code/

mount: /dev/sr0 写保护,将以只读方式挂载

[root@ops ~]# cat /etc/nginx/conf.d/mirror.ops.net.conf

server {

listen 80;

server_name mirror.ops.net;

charset utf-8; #设定字符集,防止中文字符乱码显示

autoindex on;

autoindex_exact_size off;

autoindex_localtime on;

location / {

root /code/;

}

}

1.3 模拟企业内网仓库

[root@ops mirror]# cat /etc/nginx/conf.d/mirror.ops.net.conf

server {

listen 80;

server_name mirror.ops.net;

charset utf-8;

root /mirror;

location / {

index index.html;

}

#提供yum仓库目录

location /repo {

autoindex on;

autoindex_exact_size off;

autoindex_localtime on;

}

}

#使用rsync同步

[root@ops ~]# yum -y install rsync createrepo

[root@ops ~]# mkdir /repo/

[root@ops mirror]# rsync -avz rsync://rsync.mirrors.ustc.edu.cn/centos-vault/7.9.2009/os/x86_64/Packages /repo/

[root@ops ~]# ls /repo

389-ds-base-1.3.10.2-6.el7.x86_64.rpm NetworkManager-ppp-1.18.8-1.el7.x86_64.rpm

389-ds-base-devel-1.3.10.2-6.el7.x86_64.rpm NetworkManager-team-1.18.8-1.el7.x86_64.rpm

# 将该目录创建为仓库目录

[root@ops ~]# createrepo /repo

[root@ops ~]# createrepo /repo

Saving Primary metadata

Saving file lists metadata

Saving other metadata

Generating sqlite DBs

Sqlite DBs complete2 Nginx访问控制

ngx_http_access_module 模块允许限制对某些客户端地址的访问。

2.1 配置语法

#允许配置语法

Syntax: allow address | CIDR | unix: | all;

Default: -

Context: http, server, location,limit_except

#拒绝配置语法

Syntax: deny address | CIDR | unix: | all;

Default: -

Context: http, server, location,limit_except2.2 配置示例

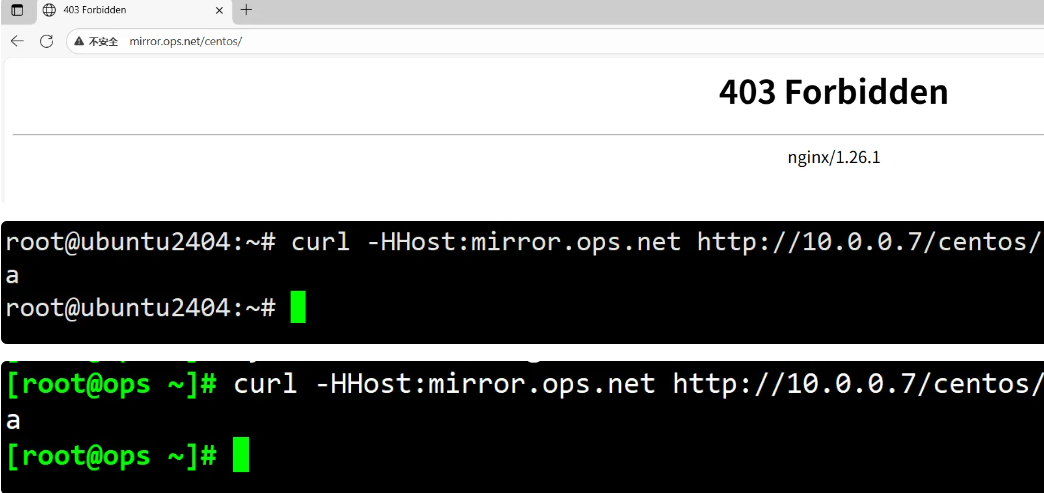

只允许指定的来源IP能访问/centos, 其它网段全部拒绝。

[root@ops ~]# cat /etc/nginx/conf.d/mirror.ops.net.conf

server {

listen 80;

server_name mirror.ops.net;

charset utf-8;

autoindex on;

autoindex_exact_size off;

autoindex_localtime on;

root /mirror;

location / {

index index.html;

}

location /centos {

allow 127.0.0.1;

allow 10.0.0.128/32; #允许地址或地址段

deny all; #拒绝所有人

}

}

#说明:10.0.0.128/32中的 /32表示子网掩码为32位全1(255.255.255.255),该地址只能分配给一台主机,无法作为子网使用,这种表示法常用于精确指定单台设备的IP地址

[root@ops ~]# mkdir -p /mirror/centos

[root@ops ~]# cat /mirror/centos/index.html

a

[root@ops ~]# curl -HHost:mirror.ops.net http://127.0.0.1/centos/

[root@ops ~]# tail -1 /etc/hosts

10.0.0.9 mirror.ops.net

拒绝指定的IP访问该网站的/centos,其他IP全部允许访问。

[root@ops ~]# cat /etc/nginx/conf.d/mirror.ops.net.conf

server {

listen 80;

server_name mirror.ops.net;

charset utf-8; #设定字符集,防止中文字符乱码显示

autoindex on;

autoindex_exact_size off;

autoindex_localtime on;

root /mirror;

location / {

index index.html;

}

location /centos {

deny 10.0.0.128/32; #拒绝指定的地址或地址段

allow all; #允许所有的地址

}

}

注意: deny和allow的顺序是有影响的

默认情况下,从第一条规则进行匹配。

如果匹配成功,则不继续匹配下面的内容。

如果匹配不成功,则继续往下寻找能匹配成功的内容。

3 Nginx基础认证

ngx_http_auth_basic_module模块允许使用HTTP基本身份验证,验证用户名和密码来限制对资源的访问。

3.1 配置语法

#使用HTTP基本身份验证协议启用用户名和密码验证

Syntax: auth_basic string| off;

Default: auth_basic off;

Context: http, server, location,limit_except

#指定保存用户名和密码的文件

Syntax: auth_basic_user_file file;

Default: -

Context: http, server, location,limit_except指定保存用户名和密码的文件,格式如下:

#可以使用htpasswd程序或"openssl passwd"命令生成对应的密码;

name1:passwd1

name2:passwd2

#使用htpaaswd创建新的密码文件, -c创建新文件 -b允许命令行输入密码

[root@ops ~]# yum install httpd-tools -y

[root@ops ~]# htpasswd -b -c /etc/nginx/auth_conf demo 1234563.2 配置示例

[root@ops ~]# cat /etc/nginx/conf.d/mirror.ops.net.conf

server {

listen 80;

server_name mirror.ops.net;

charset utf-8; #设定字符集,防止中文字符乱码显示。

autoindex on;

autoindex_exact_size off;

autoindex_localtime on;

root /mirror;

location / {

index index.html;

}

location /centos {

auth_basic "Auth access Blog Input your Passwd!";

auth_basic_user_file /etc/nginx/auth_conf;

}

}

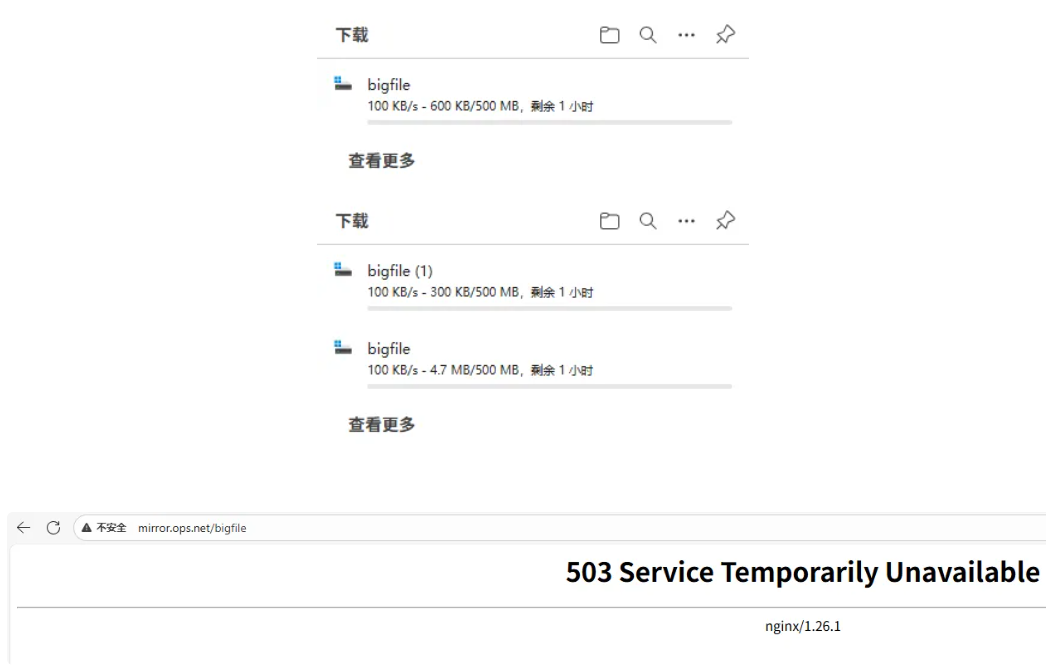

4 Nginx限流限速

4.1 为什么要限速

限制某个用户在一定时间内能够产生的Http请求,或者说限制某个用户的下载速度。

503: 过载保护

4.2 限速应用场景

下载限速:限制用户下载资源的速度ngx_http_core_module

请求限制:限制用户单位时间内所产生的Http请求数ngx_http_limit_req_module

连接限制:限制同一时间的连接数,及并发数限制ngx_http_limit_conn_module

4.3 请求频率限速原理

水(请求)从上方倒入水桶,从水桶下方流出(被处理)。

如果说水(请求)流入的过快,水桶流出(被处理)的过慢,来不及流出的水存在水桶中(缓存),然后以固定速率流出,水桶满后则水溢出(丢弃)。

简单来说就是:当处理速度,达不到请求的速度,则会将请求放置缓存,然后持续处理。当缓存被占满,如果还有大量的请求,则会被丢弃。

4.4 限制请求并发数

指令

Syntax: limit_req_zone key zone=name:size rate=rate;

Default: -

Context: http

Syntax: limit_req zone number [burst=number] [nodelay];

Default: -

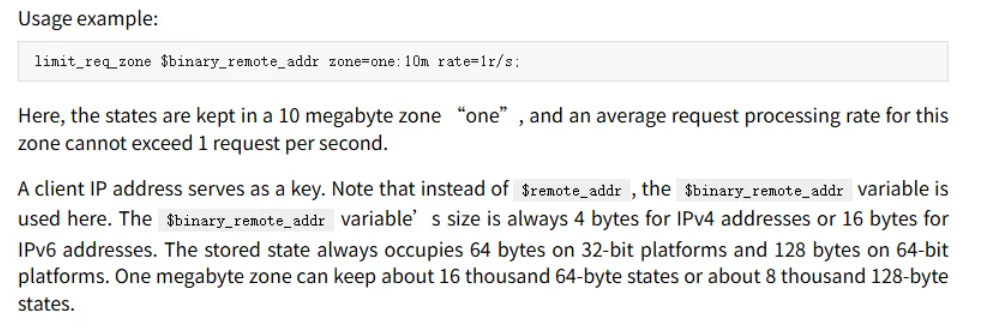

Context: http, server, location基于来源IP对下载速率限制,限制每秒处理1次请求,但可以突发超过5个请求放入缓存区

# http标签段定义请求限制, rate限制速率,限制一秒钟最多一个IP请求

$remote_addr; $binary_remote_addr

[root@ops ~]# cat /etc/nginx/conf.d/mirror.ops.net.conf

limit_req_zone $binary_remote_addr zone=req_one:10m rate=1r/s;

server {

listen 80;

server_name mirror.ops.net;

# 请求超过1r/s,剩下的将被延迟处理,请求数超过burst定义的数量,则返回503

limit_req zone=req_one burst=3 nodelay;

location / {

root /code;

index index.html;

}

}

limit_req_zone $binary_remote_addr zone=req_one:10m rate=1r/s;

#第一个参数:$binary_remote_addr表示通过这个标识来做限制,限制同一客户端ip地址。

#第二个参数:zone=req_one:10m表示生成一个大小为10M,名为req_one的内存区域,用来存储访问的频次信息。

#第三个参数:rate=1r/s表示允许相同标识的客户端的访问频次,这里限制的是每秒1次。

limit_req zone=req_one burst=3 nodelay;

#第一个参数:zone=req_one 设置使用哪个配置区域来做限制,与上面limit_req_zone 里的name对应。

#第二个参数:burst=3,设置一个大小为3的缓冲区,当有大量请求过来时,超过了访问频次限制的请求可以先放到这个缓冲区内。

#第三个参数:nodelay,超过访问频次并且缓冲区也满了的时候,则会返回503,如果没有设置,则所有请求会等待排队。

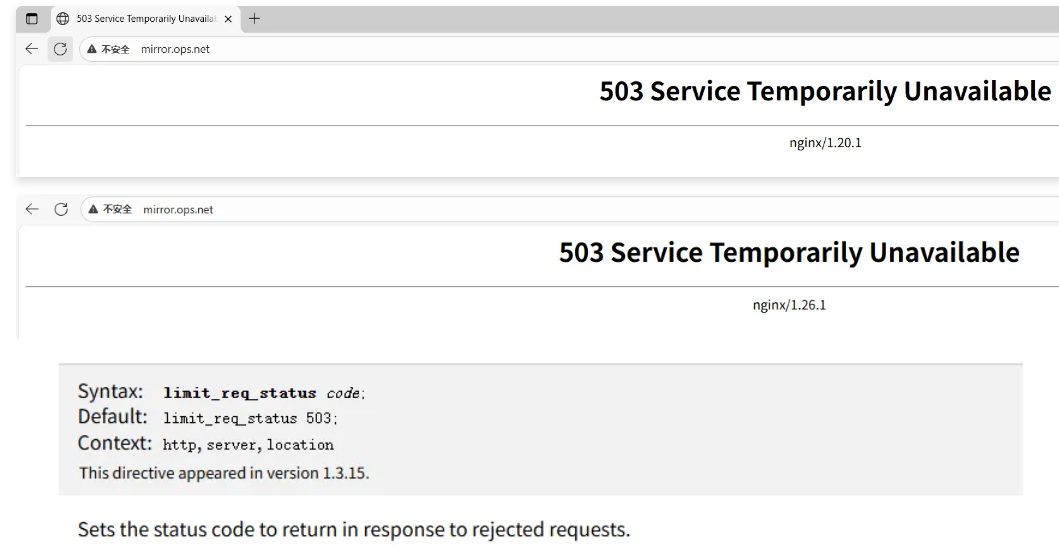

浏览器刷新的频率快一些,报错如下:

limit_req_zone $binary_remote_addr zone=req_one:10m rate=1r/s;

server {

listen 80;

server_name mirror.ops.net;

# 请求超过1r/s,剩下的将被延迟处理,请求数超过burst定义的数量,则返回503

limit_req zone=req_one burst=3 nodelay;

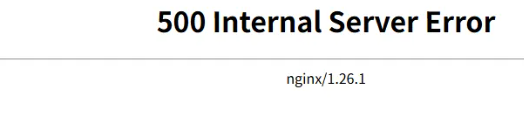

limit_req_status 500;

location / {

root /code;

index index.html;

}

}

[root@ops conf.d]# nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

[root@ops conf.d]# systemctl reload nginx

4.5 限制并发连接数

指令

Syntax: limit_conn_zone key zone=name:size;

Default: -

Context: http

Syntax: limit_conn zone number;

Default: -

Context: http, server, location设置共享内存区域和给定键值的最大允许的连接数。超过此限制时,服务器将返回503错误以回复请求

[root@ops ~]# cat /etc/nginx/conf.d/mirror.ops.net.conf

limit_conn_zone $binary_remote_addr zone=conn_od:10m;

server {

listen 80;

server_name mirror.ops.net;

root /code;

charset utf8;

autoindex on;

autoindex_exact_size off;

autoindex_localtime on;

limit_rate 100k;

limit_conn conn_od 2;

location / {

index index.html;

}

}

[root@ops ~]# dd if=/dev/zero of=/code/bigfile bs=100M count=5

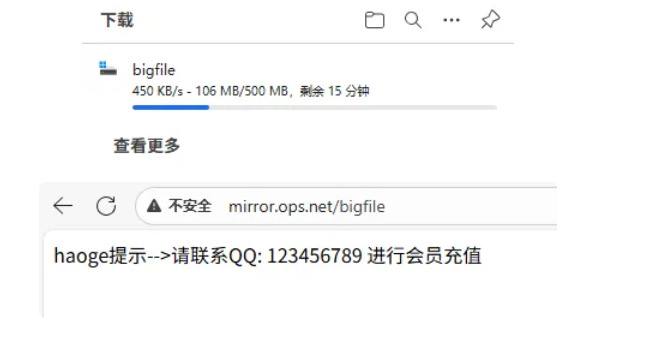

报错自定义提示信息:

[root@ops conf.d]# cat ops.conf

limit_req_zone $binary_remote_addr zone=req_one:10m rate=1r/s;

limit_conn_zone $binary_remote_addr zone=conn_od:10m;

server {

listen 80;

charset utf-8;

server_name mirror.ops.net;

# 请求超过1r/s,剩下的将被延迟处理,请求数超过burst定义的数量,则返回503

# limit_req zone=req_one burst=3 nodelay;

# limit_req_status 500;

limit_rate 100k;

limit_conn conn_od 2;

# 拦截503错误重新定向到@temp,@内部跳转

error_page 503 @temp;

location @temp {

default_type text/html;

return 200 '请联系haoge,充值VIP服务...';

}

location / {

root /code;

index index.html;

}

}

4.6 限制下载速度

[root@ops ~]# cat /etc/nginx/conf.d/mirror.ops.net.conf

server {

listen 80;

server_name mirror.ops.net;

root /code;

charset utf8;

autoindex on;

autoindex_exact_size off;

autoindex_localtime on;

limit_rate_after 100m; #达到100m开始限速

limit_rate 100k;

location / {

index index.html;

}

}

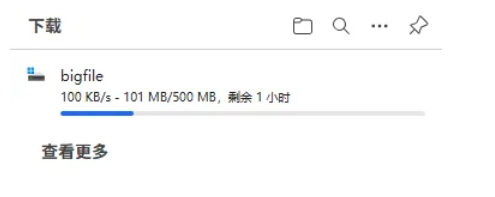

4.7 综合场景实践

限制

web服务器请求数处理为1秒一个,触发值为5、限制用户仅可同时下载一个文件当下载超过

100M则限制下载速度为500k如果同时下载超过2个视频,则返回提示 "请联系

haoge进行会员充值" | 跳转到其他页面;

[root@ops conf.d]# cat mirror.ops.net.conf

limit_req_zone $binary_remote_addr zone=req_od:10m rate=1r/s;

limit_conn_zone $binary_remote_addr zone=conn_od:10m;

server {

listen 80;

server_name mirror.ops.net;

root /code;

charset utf8;

autoindex on;

autoindex_exact_size off;

autoindex_localtime on;

limit_req zone=req_od burst=5 nodelay;

limit_conn conn_od 1;

limit_rate_after 100m;

limit_rate 500k;

error_page 503 @errpage;

location @errpage {

default_type text/html;

return 200 'haoge提示-->请联系QQ: 123456789 进行会员充值';

}

location / {

index index.html;

}

}

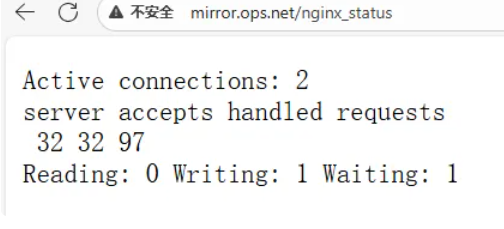

5 Nginx状态监控

ngx_http_stub_status_module模块提供对基本状态信息的访问。

默认情况下不集成该模块,需要使用 --with-http_stub_status_module 集成。

5.1 配置语法

Syntax: stub_status;

Default: -

Context: server, location5.2 配置示例

[root@ops ~]# # nginx -V

[root@ops ~]# cat /etc/nginx/conf.d/mirror.ops.net.conf

server {

listen 80;

server_name mirror.ops.net;

access_log off;

location /nginx_status {

stub_status;

}

}

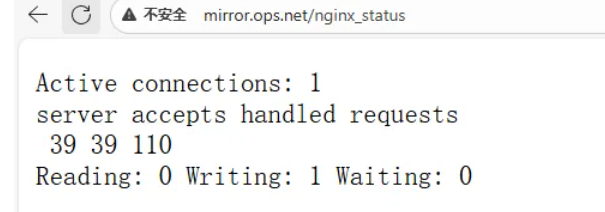

#浏览器访问:http://mirror.ops.net/nginx_status

目前状态是一次连接多次请求:

# keep-alive 是为了复用TCP连接,避免每次请求都重新建立连接的开销,提高性能

# 允许客户端复用同一个 TCP 连接发送多个 HTTP 请求(减少建立新连接的开销,提高性能)

[root@ops ~]# cat /etc/nginx/nginx.conf | grep kee -n

27: keepalive_timeout 65;[root@ops ~]# vim +27 /etc/nginx/nginx.conf

keepalive_timeout 0;

[root@ops ~]# systemctl reload nginx 目前状态是一次连接一个请求:

[root@ops ~]# cat /etc/nginx/conf.d/module.conf

server {

listen 80;

server_name mirror.ops.net;

access_log off;

location /nginx_status {

stub_status;

allow 10.0.0.166/32;

deny all;

}

}

[root@ops ~]# curl -s -HHost:mirror.ops.net http://10.0.0.6/nginx_status

<html>

<head><title>403 Forbidden</title></head>

<body>

<center><h1>403 Forbidden</h1></center>

<hr><center>nginx/1.26.1</center>

</body>

</html>

[root@ops conf.d]# cat module.conf

server {

listen 80;

server_name mirror.ops.net;

access_log off;

location /nginx_status {

stub_status;

allow 127.0.0.1;

allow 10.0.0.166/32;

deny all;

}

}

[root@ops conf.d]# curl -HHost:mirror.ops.net http://127.0.0.1/nginx_status

Active connections: 1

server accepts handled requests

5 5 7

Reading: 0 Writing: 1 Waiting: 05.3 页面状态

此配置创建一个简单的网页,其基本状态数据可能如下所示:

[root@ops ~]# curl -HHost:mirror.ops.net http://10.0.0.9/nginx_status

Active connections: 3

server accepts handled requests

65 65 188

Reading: 0 Writing: 1 Waiting: 2

# Active connections:当前活跃连接数,包括Waiting等待连接数。

# accepts: 已接收的总TCP连接数量。

# handled: 已处理的TCP连接数量。

# requests:当前总http请求数量。

# Reading: 当前读取的请求头数量。

# Writing: 当前响应的请求头数量。

# Waiting: 当前等待请求的空闲客户端连接数。如何理解

Reading、Writing、Waiting假设现在有两条船分别为

C 、S。C船需要S船的1个物品,那么此时C船就要给S船发送一个消息。

1、

S船收到这个消息时就是reading2、

S船将物资发送给C船,这个时候就是writing3、如果

C船需要S船很多个物品,那么需要C船和S船建立起一个物资传送管道,不断的传送物资。这个管道建立起来的时候,就是waiting状态了。

[root@ops ~]# curl -s -HHost:mirror.ops.net http://10.0.0.6/nginx_status | awk -F':' 'NR==1 {print $NF}'

3

[root@ops ~]# curl -s -HHost:mirror.ops.net http://10.0.0.6/nginx_status | awk -F':' 'NR==1 {print $NF}' | sed 's# ##g'

1

[root@ops ~]# echo "当前Nginx的活跃连接数:$(curl -s -HHost:mirror.ops.net http://10.0.0.6/nginx_status | awk -F':' 'NR==1 {print $NF}' | sed 's# ##g')"

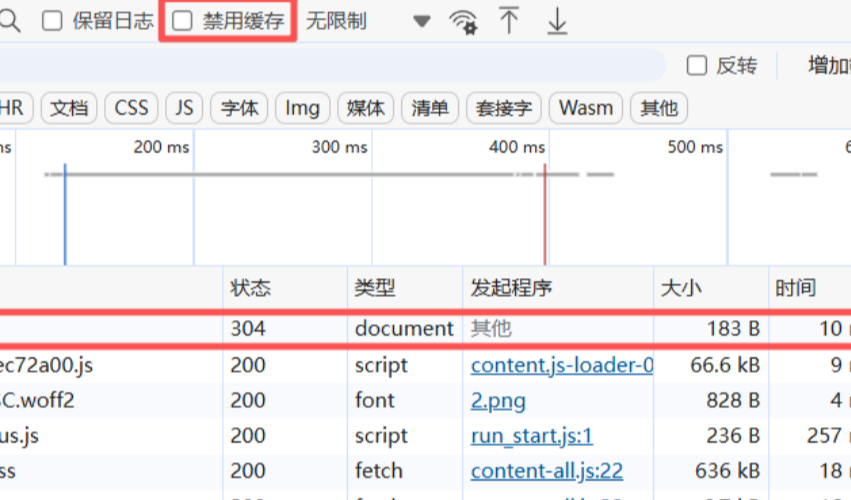

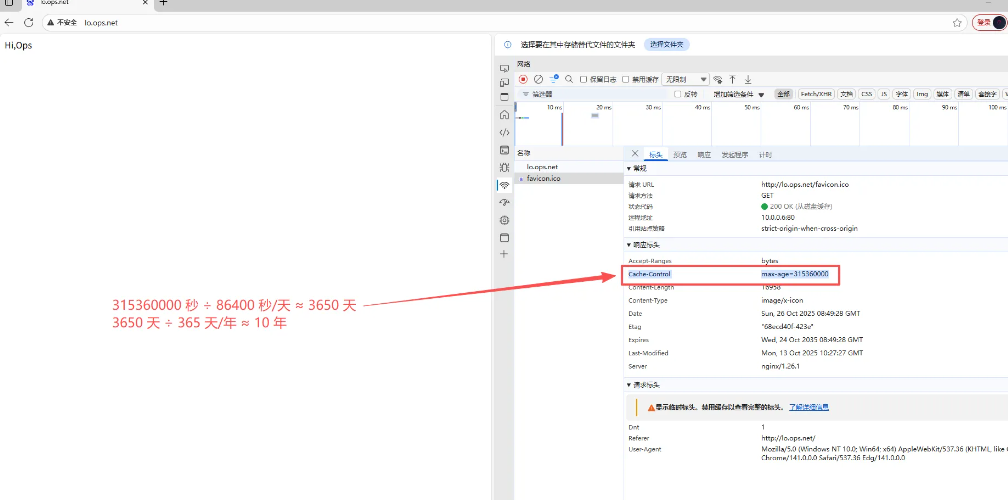

当前Nginx的活跃连接数:16 Nginx资源缓存

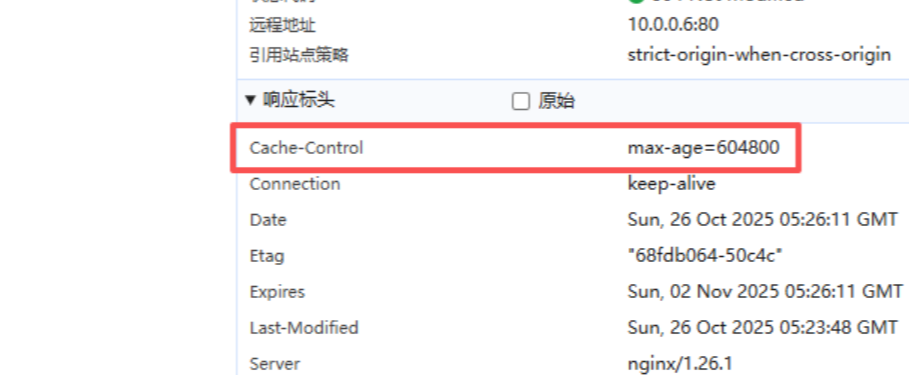

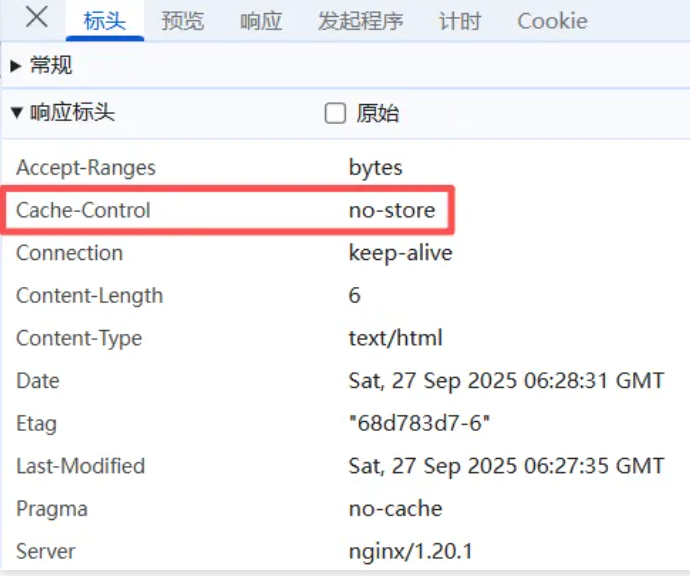

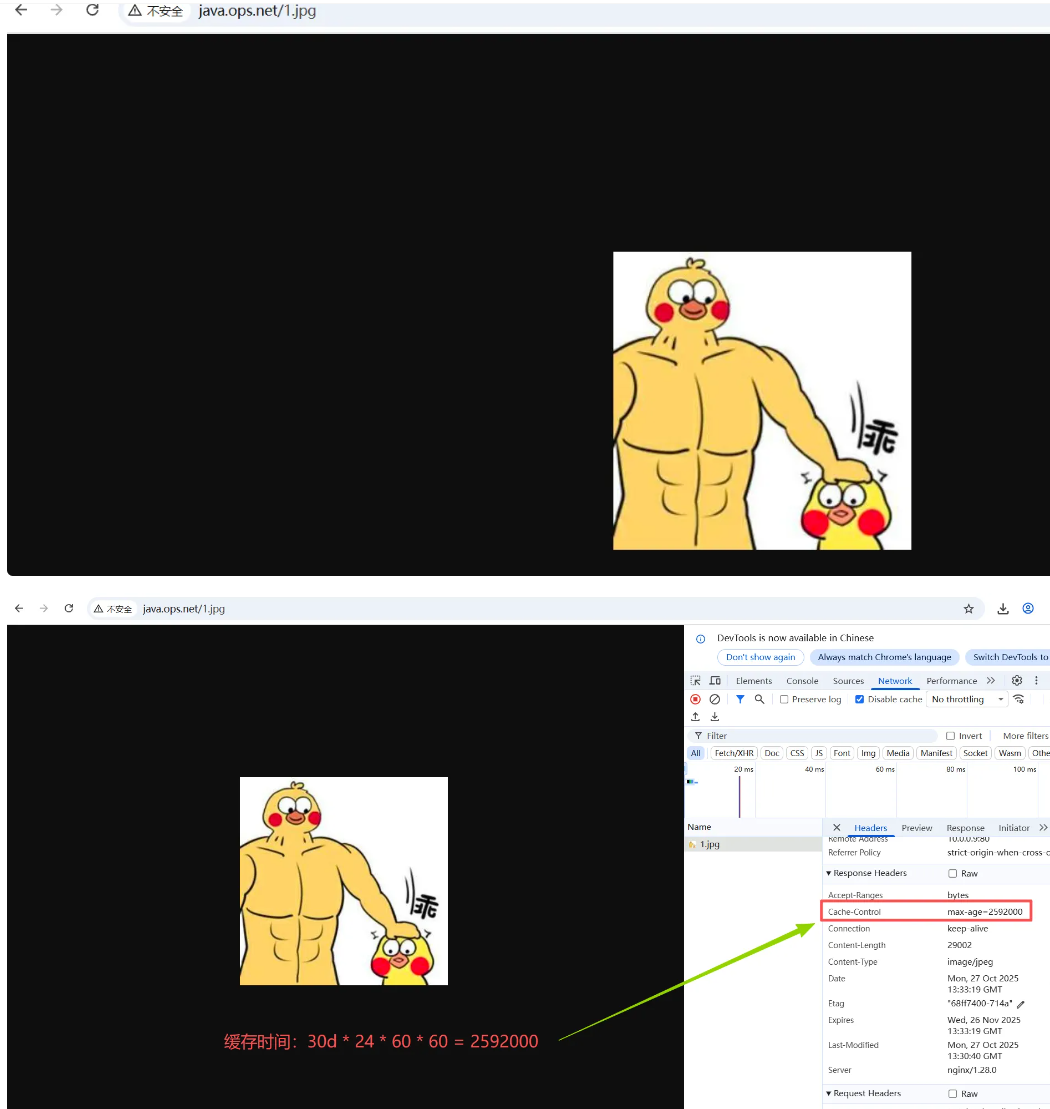

浏览器缓存设置用于提高网站性能,尤其是新闻网站,图片一旦发布,改动的可能是非常小的。所以我们希望能否用户访问一次后,图片缓存在用户的浏览器长时间缓存。

浏览器是有自己的缓存机制,它是基于

HTTP协议缓存机制来实现的,在HTTP协议中有很多头(Headers)信息,那么实现浏览器的缓存就需要依赖特殊的头信息来与服务器进行特殊的验证,如:Expires (http/1.0) ;Cache-control (http/1.1)

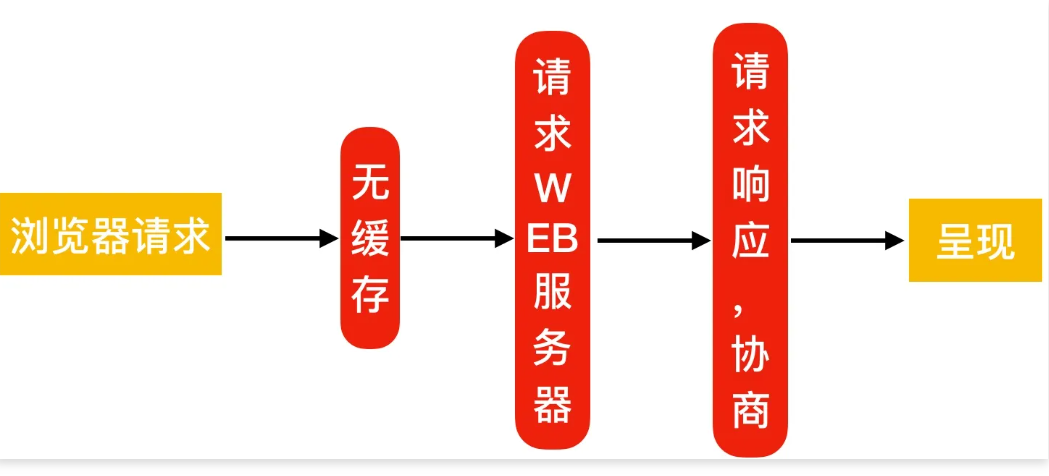

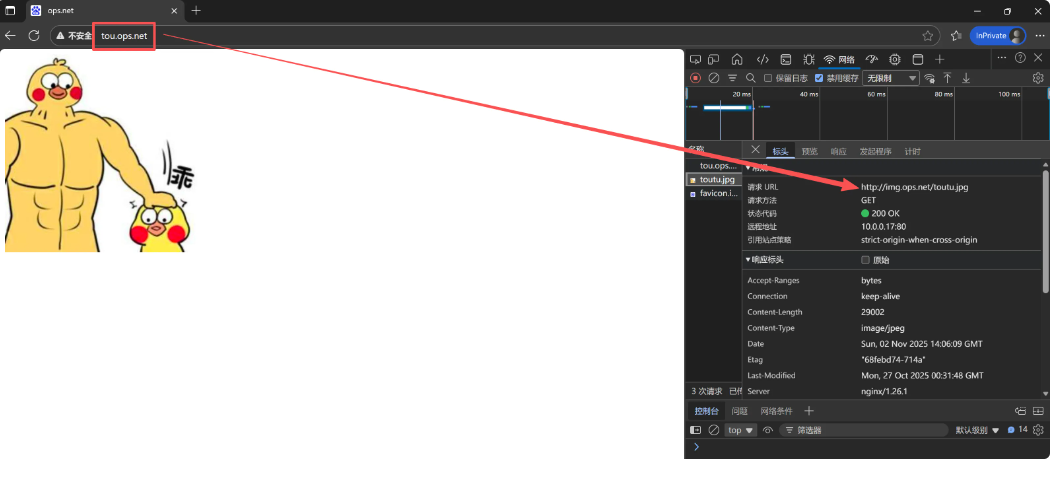

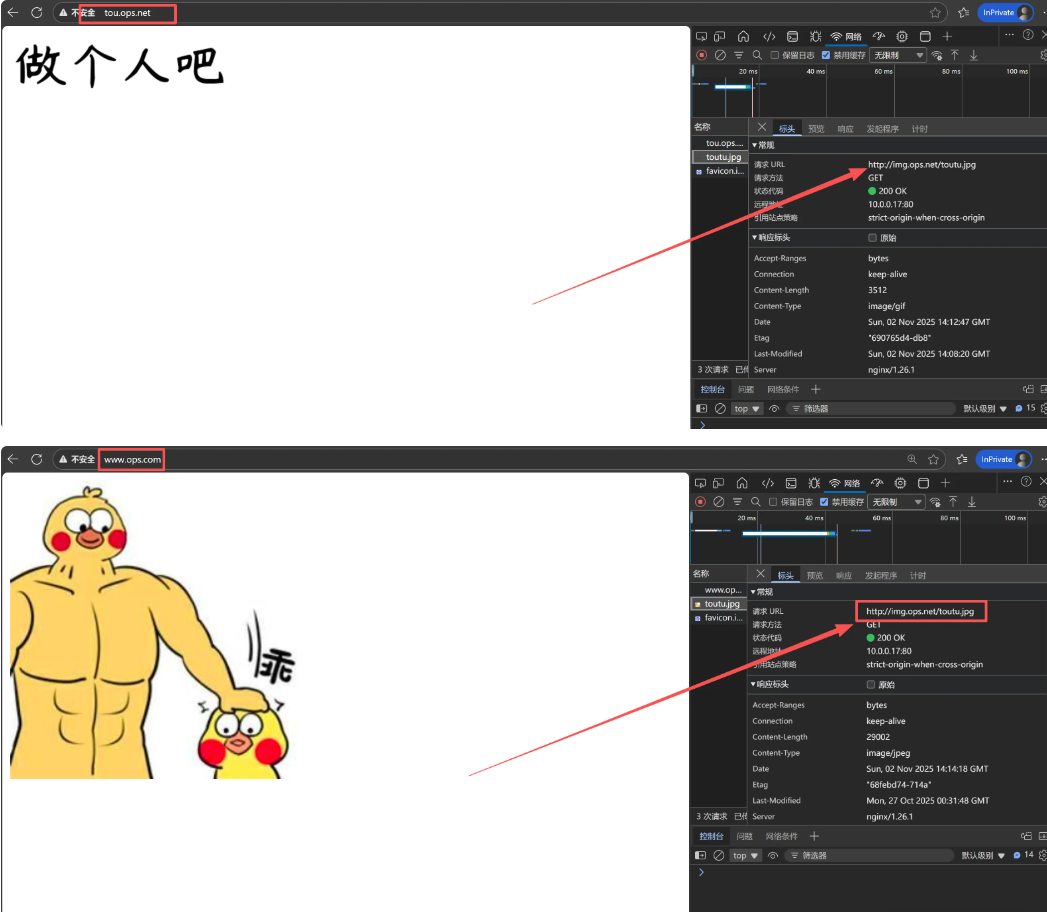

6.1 浏览器无缓存

6.2 浏览器有缓存

6.3 缓存过期校验

浏览器缓存过期校验检查机制,说明如下:

浏览器请求服务器会先进行

Expires、CacheControl的检查,检查缓存是否过期,如果没有过期则直接从缓存文件中读取。如果缓存过期,首先检查是否存在

etag,如果存在则会客户端会向web服务器请求if-None-Match,与etag值进行比对,由服务器决策返回200还是304。如果

etag不存在,则进行last-Modified检查,客户端会向web服务器请求If-Modified-Since,与last-Modified进行比对,由服务器决策返回200还是304。

6.4 缓存配置语法

#作用: 添加Cache-Control Expires头

Syntax: expires [modified] time;

expires epoch | max | off;

Default: expires off;

Context: http, server, location, if in location6.5 资源缓存配置场景

server {

listen 80;

server_name static.ops.net;

root /code;

location ~ .*\.(jpg|gif|png)$ {

#客户端(浏览器/CDN)会缓存这些图片文件7天,期间重复请求时直接从本地缓存读取,减少服务器压力,提升加载速度

expires 7d; # 设置客户端缓存过期时间为7天(604800秒)

}

#如果开发代码没有正式上线时,希望静态文件不被缓存

location ~ .*\.(css|js|swf|json|mp4|htm|html)$ {

add_header Cache-Control no-store; # 禁止客户端缓存

add_header Pragma no-cache; # 兼容旧浏览器,强制每次请求验证

}

}

[root@ops ~]# ls /code/

1.jpg index.html

没缓存如下:

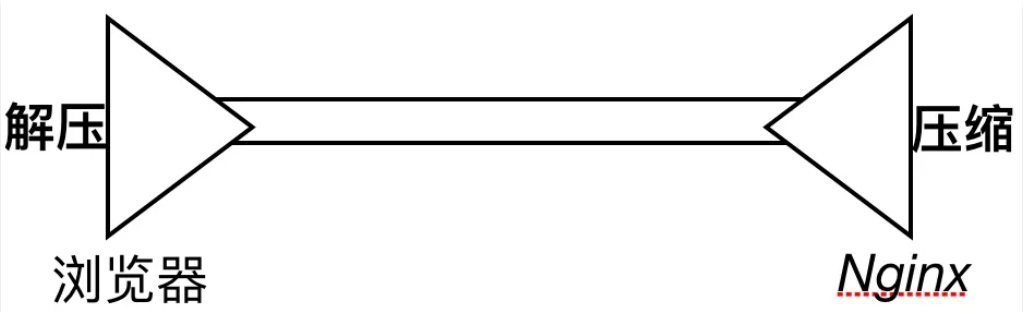

7 Nginx资源压缩

Nginx将发送至客户端之前的数据进行压缩,然后传输,这能够有效地节约带宽,并提高响应速度;

图片:不高;

文本:比较高;

7.1 配置语法

# 1、启用或关闭gzip压缩

Syntax: gzip on | off;

Default: gzip off;

Context: http, server, location, if in location

# 2、gzip支持的压缩类型

Syntax: gzip_types mime-type ...;

Default: gzip_types text/html;

Context: http, server, location

# 3、gzip压缩比率,压缩率越高,CPU消耗越大 9

Syntax: gzip_comp_level level;

Default: gzip_comp_level 1;

Context: http, server, location

# 4、gzip压缩的最小文件,小于设置的值文件将不会被压缩(由"Content-Length"响应头字段确定)

Syntax: gzip_min_length length;

Default: gzip_min_length 20;

Context: http, server, location

# 5、gzip压缩支持的协议版本

Syntax: gzip_http_version 1.0 | 1.1;

Default: gzip_http_version 1.1;

Context: http, server, location

# 6、启用压缩,是否在响应报文首部插入"Vary:

Accept-Encoding"

Syntax: gzip_vary on | off;

Default: gzip_vary off;

Context: http, server, location7.2 图片压缩案例

[root@ops conf.d]# mkdir -p /code/images

[root@ops conf.d]# cat /etc/nginx/mime.types | grep image

image/gif gif;

image/jpeg jpeg jpg;

image/png png;

image/svg+xml svg svgz;

image/tiff tif tiff;

image/vnd.wap.wbmp wbmp;

image/webp webp;

image/x-icon ico;

image/x-jng jng;

image/x-ms-bmp bmp;

[root@ops ~]# vim /etc/nginx/conf.d/static.ops.net.conf

server {

listen 80;

server_name static.ops.net;

root /code/images;

location ~* .*\.(jpg|gif|png)$ {

gzip on;

gzip_http_version 1.1;

gzip_comp_level 2;

gzip_min_length 10k;

gzip_types image/jpeg image/gif image/png;

gzip_vary on;

}

}

--------------------------------------------

gzip on - 开启 Gzip 压缩

gzip_http_version 1.1 - 支持 HTTP 1.1 协议

gzip_comp_level 2 - 压缩级别为 2(中等压缩)

gzip_min_length 10k - 只压缩大于 10KB 的文件

gzip_types - 压缩指定的图片格式:JPEG、GIF、PNG

gzip_vary on - 根据客户端支持情况自动选择是否压缩

--------------------------------------------

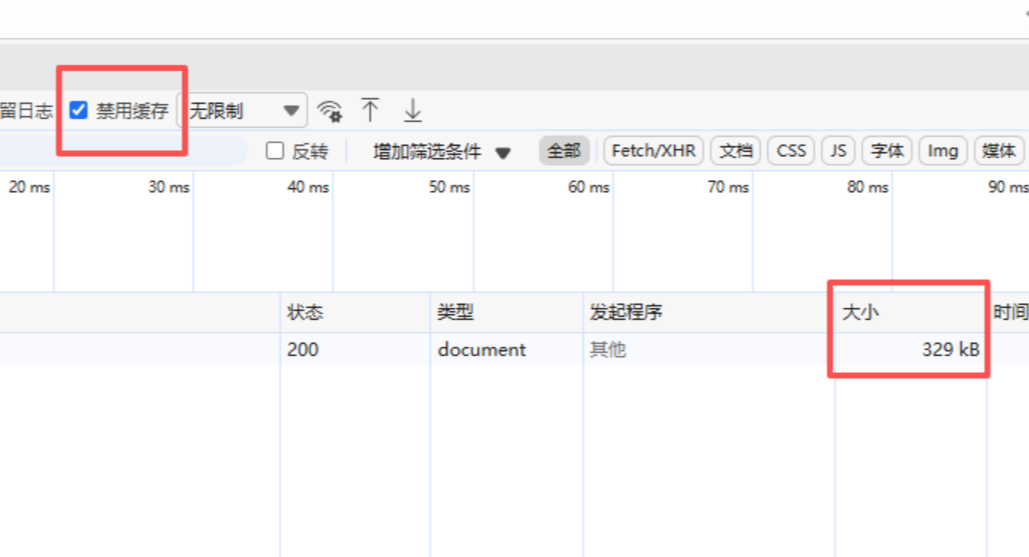

[root@ops ~]# cp /code/1.jpg /code/images/未压缩之前

启用压缩之后

7.3 文件压缩案例

[root@ops ~]# mkdir -p /code/doc

[root@ops ~]# ll -h /code/doc/

总用量 8.7M

-rw-r--r-- 1 root root 8.7M 10月 26 13:35 access.txt

[root@ops conf.d]# cat static_server.conf

server {

listen 80;

server_name static.ops.net;

root /code/doc;

location ~ .*\.(txt|pdf|log)$ {

gzip on;

gzip_http_version 1.1;

gzip_comp_level 2;

gzip_min_length 1k;

gzip_types text/plain application/pdf;

gzip_vary on;

}

}8 Nginx Location

8.1 什么是Location

Location用来控制访问网站的uri路径;

8.2 Location语法示例

location [ = | ~ | ~* | ^~ ] uri { ... }

location @name { ... }

/api/xxx/dadas/dsadsa

/apiv1/dsa/dsaxx/sadsa/

# 匹配符,匹配规则 优先级

# = 精确匹配 1

# ^~ 以某个字符串开头 2

# ~ 区分大小写的正则匹配 3

# ~* 不区分大小写的正则匹配 4

# / 通用匹配,任何请求都会匹配到 5location uri 添加 / 和不添加 / 的区别?

#不添加/,默认去/code/test目录下找index.html文件,如果没有 index.html, 则会查找/code/test文件

location /test {

root /code;

index index.html;

}

#添加/,匹配任何以 /uri/ 开头的请求路径

location /test/ {

root /code;

}

#示例测试代码

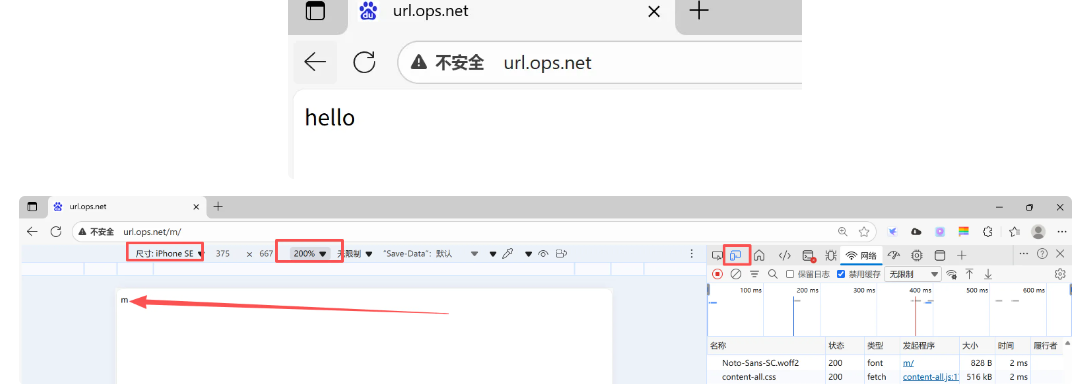

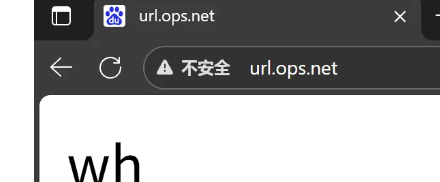

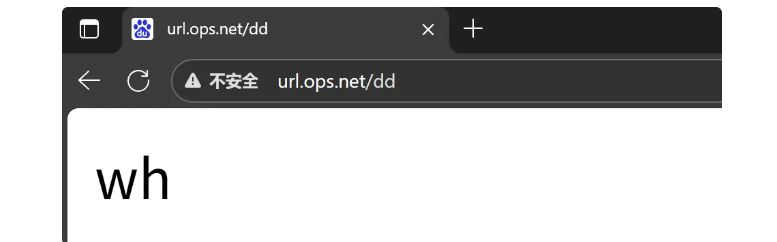

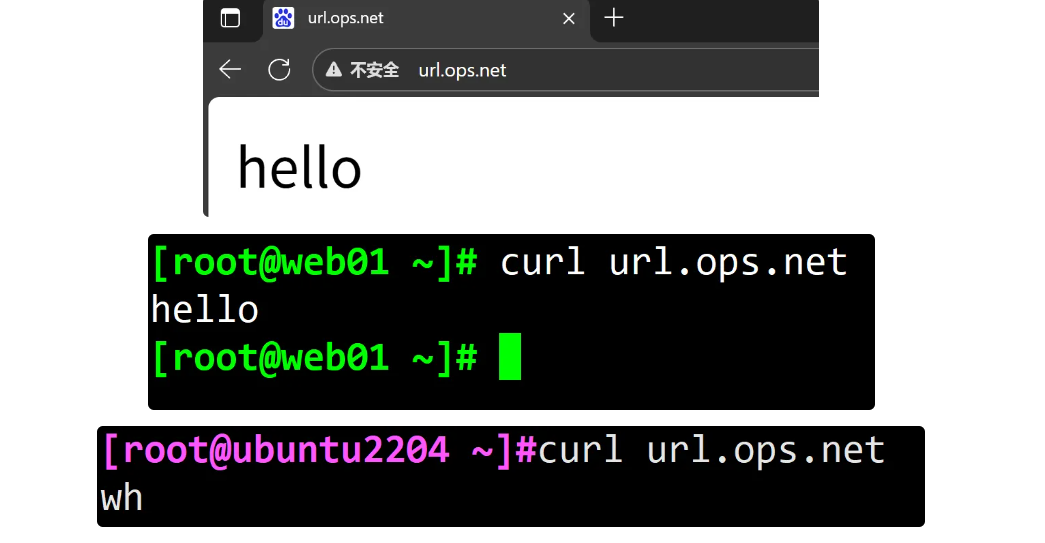

[root@ops code]# cat /etc/nginx/conf.d/uri.ops.net.conf

server {

listen 80;

server_name uri.ops.net;

root /code;

# location /test {

# index index.html;

# }

location /test/ {

index index.html;

}

}8.3 Location优先级示例

[root@ops conf.d]# cat location.ops.net.conf

server {

listen 80;

server_name location.ops.net;

location = / {

default_type text/html;

return 200 'location = /';

}

location / {

default_type text/html;

return 200 'location /';

}

location /documents/ {

default_type text/html;

return 200 'location /documents/';

}

location ^~ /images/ {

default_type text/html;

return 200 'location ^~ /images/';

}

location ~* \.(gif|jpg|jpeg)$ {

default_type text/html;

return 200 'location ~* \. (gif|jpg|jpeg)';

}

}

#测试结果如下(建议是curl测试)

#1.请求 http://location.ops.net/ 会被 location =/ 匹配

[root@rocky9 ~]# curl http://location.ops.net/

location = /

#2.请求 http://location.ops.net/index.html 会被 location / 匹配

[root@rocky9 ~]# curl http://location.ops.net/index.html

location /

#3.请求 http://location.ops.net/documents/1.html 会被 location /documents/ 匹配

[root@rocky9 ~]# curl http://location.ops.net/documents/1.html

location /documents/

#4.请求 http://location.ops.net/images/1.gif 会被 location ^~ /images/ 匹配

[root@rocky9 ~]# curl http://location.ops.net/images/1.gif

location ^~ /images/

#5.请求 http://location.ops.net/documents/1.jpg 会被 location ~* \.(gif|jpg|jpeg)$ 匹配

[root@rocky9 ~]# curl http://location.ops.net/documents/1.jpg

location ~* \. (gif|jpg|jpeg)8.4 Location 应用场景

[root@ops conf.d]# cat location2.ops.net.conf

server {

listen 80;

server_name location2.ops.net;

charset utf-8;

# 通用匹配,任何请求都会匹配到

location / {

root html;

index index.html;

}

# 精准匹配,必须请求的uri是/nginx_status

location = /nginx_status {

stub_status;

}

# 严格区分大小写,匹配以.php结尾的都走这个 location info.php

location ~ \.php$ {

default_type text/html;

return 200 'php访问成功';

}

# 严格区分大小写,匹配以.jsp结尾的都走这个location

location ~ \.jsp$ {

default_type text/html;

return 200 'jsp访问成功';

}

# 不区分大小写匹配,只要用户访问.jpg,gif,png,js,css 都走这条location

location ~* \.(jpg|gif|png|js|css)$ {

# return 403;

expires 3d;

}

# 不区分大小写匹配

location ~* \.(sql|bak|tgz|tar.gz|git)$ {

deny all;

}

}

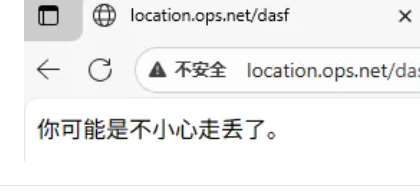

8.5 Location @重定向

location @name这样的location不用于常规请求处理,而是用于请求重定.

[root@ops conf.d]# cat location3.ops.net.conf

server {

listen 80;

server_name location.ops.net;

root /code;

charset utf-8;

location / {

index index.html;

}

#如果出现异常,则重新定向到@error_404这个location上

error_page 404 @error_404;

location @error_404 {

default_type text/html;

return 200 '你可能是不小心走丢了。';

}

}

[root@ops conf.d]# echo Error... > /code/err.html

[root@ops conf.d]# cat /code/err.html

Error...

[root@ops conf.d]# cat location3.ops.net.conf

server {

listen 80;

server_name location.ops.net;

root /code;

charset utf-8;

location / {

index index.html;

}

error_page 400 403 404 /err.html;

##如果出现异常,则重新定向到@error_404这个location上

# error_page 404 @error_404;

# location @error_404 {

# default_type text/html;

# return 200 '你可能是不小心走丢了。';

# }

}

将错误访问重定向到主页:

[root@ops conf.d]# cat location3.ops.net.conf

server {

listen 80;

server_name location.ops.net;

root /code;

charset utf-8;

location / {

index index.html;

}

#如果出现异常,则重新定向到@error_404这个location上

error_page 404 @error_404;

location @error_404 {

default_type text/html;

return 302 http://$server_name;

#return 302 http://location.ops.net;

}

}

浏览器访问:http://qq.com/sfafaafsafsafsafsa

浏览器访问京东:http://jd.com/fsafsasa

9 Nginx 日志模块

Nginx的日志记录非常灵活,可以通过log_format来定义格式。

9.1 Nginx日志格式

log_format定义日志格式语法

# 配置语法: 包括: error.log access.log

Syntax: log_format name [escape=default|json] string ...;

Default: log_format combined "...";

Context: http

# 默认Nginx定义语法格式如下

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

log_format test '$remote_addr -$remote_user [$time_local] "$request" ''$status';

#access_log /var/log/nginx/access.log main;

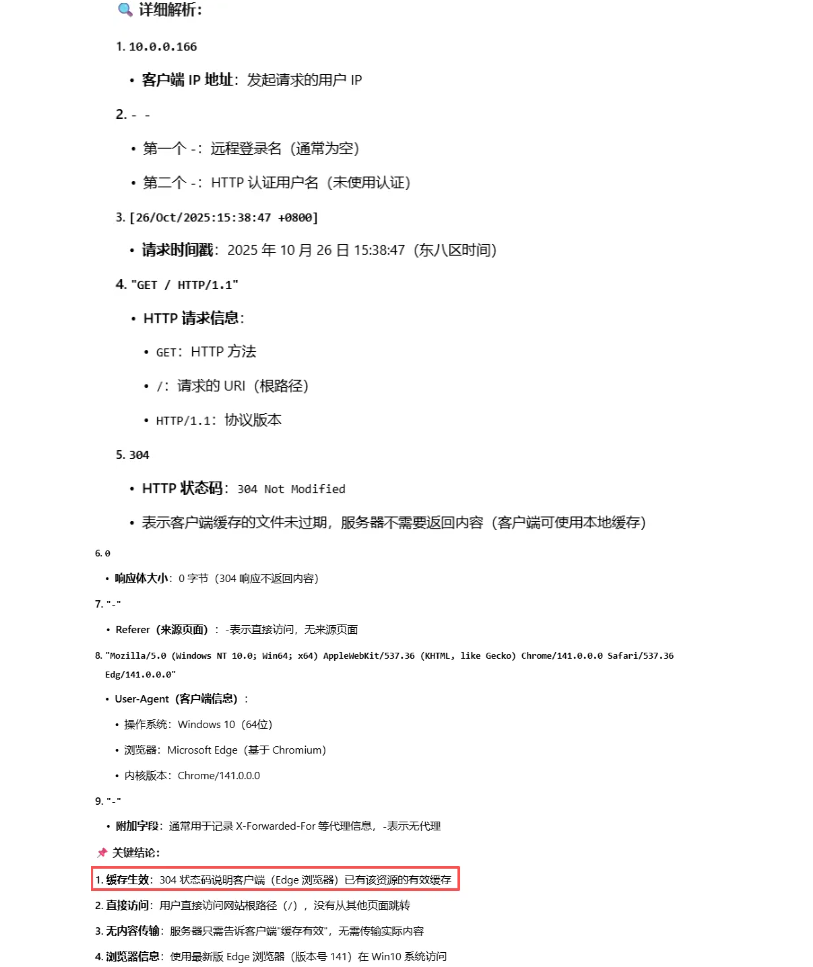

access_log /var/log/nginx/access_test.log test;Nginx日志格式中常用的变量

$remote_addr # 记录客户端IP地址

$remote_user # 记录客户端用户名

$time_local # 记录通用的本地时间

$time_iso8601 # 记录ISO8601标准格式下的本地时间

$request # 记录请求的方法以及请求的http协议

$status # 记录请求状态码(用于定位错误信息)

$body_bytes_sent # 发送给客户端的资源字节数,不包括响应头的大小

$bytes_sent # 发送给客户端的总字节数

$msec # 日志写入时间。单位为秒,精度是毫秒。

$http_referer # 记录从哪个页面链接访问过来的

$http_user_agent # 记录客户端浏览器相关信息

$http_x_forwarded_for #记录客户端IP地址

$request_length # 请求的长度(包括请求行,请求头和请求正文)。

$request_time # 请求花费的时间,单位为秒,精度毫秒

# 注:如果Nginx位于负载均衡器,nginx反向代理之后,web服务器无法直接获取到客户端真实的IP地址。

# $remote_addr获取的是反向代理的IP地址,反向代理服务器在转发请求的http头信息中。

# 增加X-Forwarded-For信息,用来记录客户端IP地址和客户端请求的服务器地址。[root@ops conf.d]# tail -f /var/log/nginx/

10.0.0.166 - - [26/Oct/2025:15:38:47 +0800] "GET / HTTP/1.1" 304 0 "-" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/141.0.0.0 Safari/537.36 Edg/141.0.0.0" "-"

10.0.0.166 - - [26/Oct/2025:15:41:14 +0800] "GET / HTTP/1.1" 200 7 "-" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/141.0.0.0 Safari/537.36 Edg/141.0.0.0" "-"

范例:自定义Nginx服务日志

[root@ops conf.d]# vim /etc/nginx/nginx.conf

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

log_format test '$remote_addr - $remote_user [$time_local] "$request" '

'$status';

#access_log /var/log/nginx/access.log main;

access_log /var/log/nginx/access_test.log test;

[root@ops ~]# nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

[root@ops ~]# systemctl reload nginx

[root@ops conf.d]# tail -f /var/log/nginx/access_test.log

10.0.0.166 - - [26/Oct/2025:15:54:27 +0800] "GET / HTTP/1.1" 304

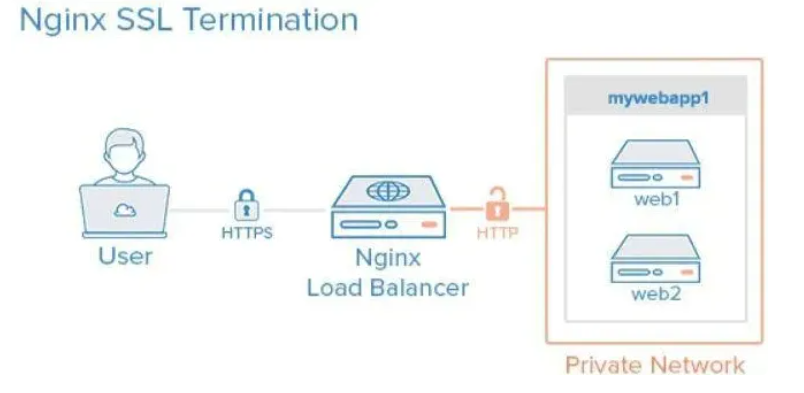

10.0.0.166 - - [26/Oct/2025:15:55:40 +0800] "GET / HTTP/1.1" 2009.2 Nginx访问日志

web服务器的访问日志是非常重要的,我们可以通过访问日志来分析用户的访问情况,也可以通过访问日志发现一些异常访问。access_log日志配置语法。

Syntax: access_log path [format [buffer=size] [gzip[=level]] [flush=time] [if=condition]];

access_log off;

Default: access_log logs/access.log combined;

Context: http, server, location, if in location, limit_except

http {

access_log /var/log/nginx/access.log main;

server {

}

server {

access_log /var/log/nginx/test.ops.net.log main;

location / {

}

location /admin {

}

}

}Nginx 访问日志配置示例

server {

listen 80;

server_name log.ops.net;

# 将当前的server网站的访问日志记录至对应的目录,使用main格式

access_log /var/log/nginx/log.ops.net.log main;

location / {

root /code;

index index.html;

}

}# cat /etc/nginx/nginx.conf | grep err

error_log /var/log/nginx/error.log;

error_page 404 /404.html;

error_page 500 502 503 504 /50x.html;

# error_page 404 /404.html;

# error_page 500 502 503 504 /50x.html;

[root@rocky9 ~]# cat /etc/nginx/nginx.conf | grep acc

access_log /var/log/nginx/access.log main;[root@ops ~]# cat /code/404.html

404报错了

[root@ops ~]# cat /etc/nginx/conf.d/log.ops.net.conf

server {

listen 80;

charset utf-8;

server_name log.ops.net;

# 将当前的server网站的访问日志记录至对应的目录,使用main格式

access_log /var/log/nginx/log.ops.net.log main;

location / {

root /code;

index index.html;

error_page 404 /404.html;

}

}

9.3 Nginx错误日志

Nginx常见的错误日志级别有debug | info | notice| warn | error | crit | alert | emerg级别越高记录的信息越少,如果不定义,默认级别为warn,它可以配置在main、http、server、location段里

Nginx错误日志示例

error_log /var/log/nginx/error.log warn;

# 关闭错误日志

error_log /dev/null;9.4 Nginx日志过滤

一个网站会包含很多元素,尤其是有大量的images、js、css等静态资源,这样的请求可以不用记录日志

# wget https://www.jd.com/favicon.ico

# wget https://www.baidu.com/favicon.ico

#请求favicon.ico时,不记录日志

location /favicon.ico {

access_log off;

return 200;

}

#或,当有人访问gif、png等资源时,将日志丢入空

location ~* .*\.(gif|jpg|png|css|js)$

{

access_log /dev/null;

}[root@ops ~]# cd /code/

[root@ops code]# wget https://www.jd.com/favicon.ico

[root@ops code]# cat location.ops.net.conf

server {

listen 80;

server_name lo.ops.net;

root /code;

access_log /var/log/nginx/access.log main;

location / {

index index.html;

}

location /favicon.ico {

access_log off;

expires 3650d;

}

}

#若访问无法看到图标,注意缓存问题,按Ctrl+F5进行强刷

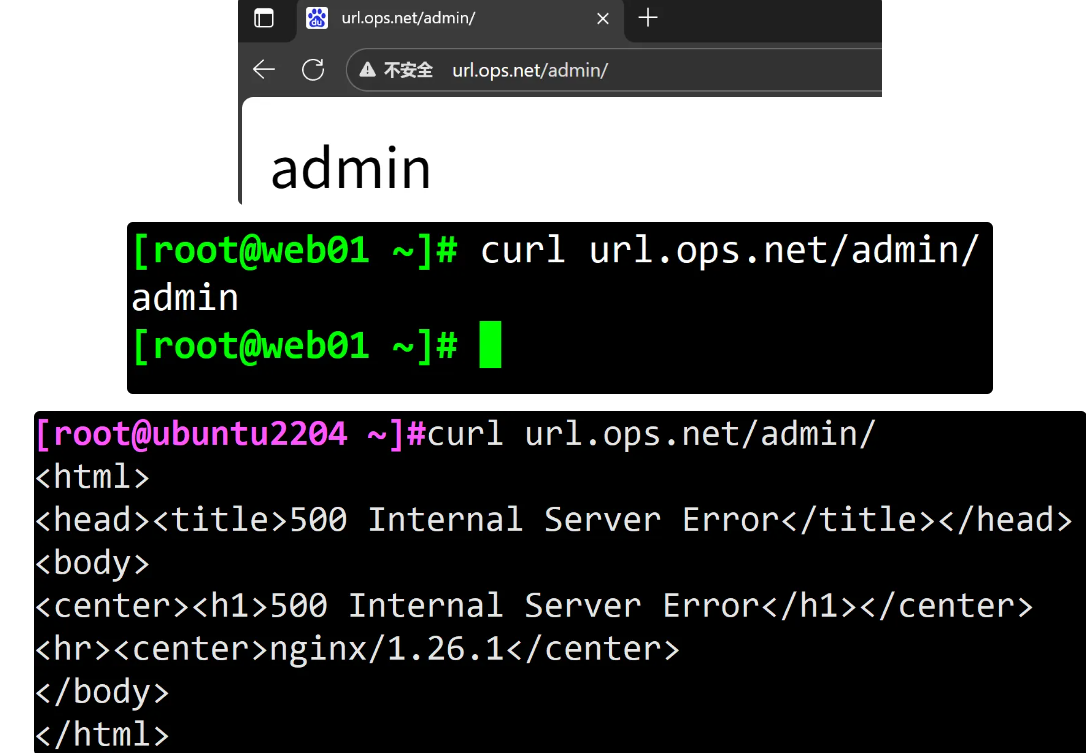

5、Nginx 反向代理服务

1. Nginx代理概述

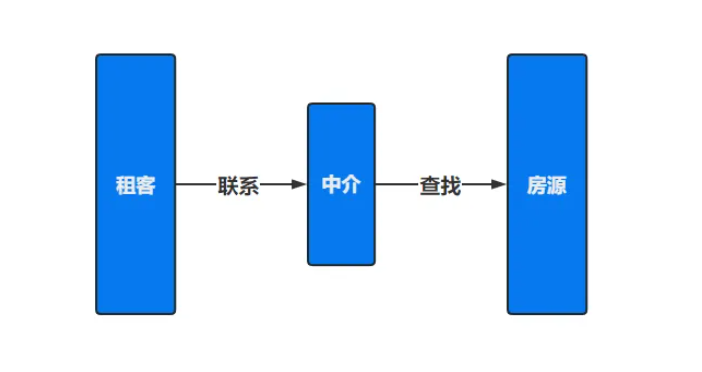

1.1 什么是代理

代理代理,代为办理,对于代理一词而言,我们并不陌生,在我们日常生活中常常用到

比如代理理财、代理租房、代理收货等等

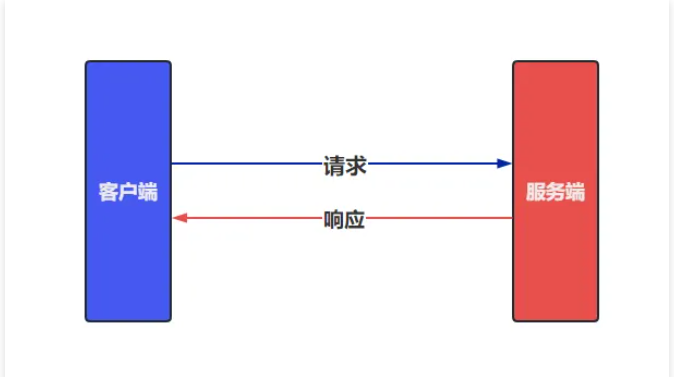

1.2 无代理场景

在没有使用代理的场景下,客户端都是直接请求服务端,服务端直接响应客户端。

比如:抖音在初创阶段时没太多人关注,单台服务器足以支撑业务运行。但随着事件推移,xx门事件的发生,引得抖音迅速蹿红,那么此时单台服务器难以支撑海量的用户请求,甚至一度造成服务瘫痪。

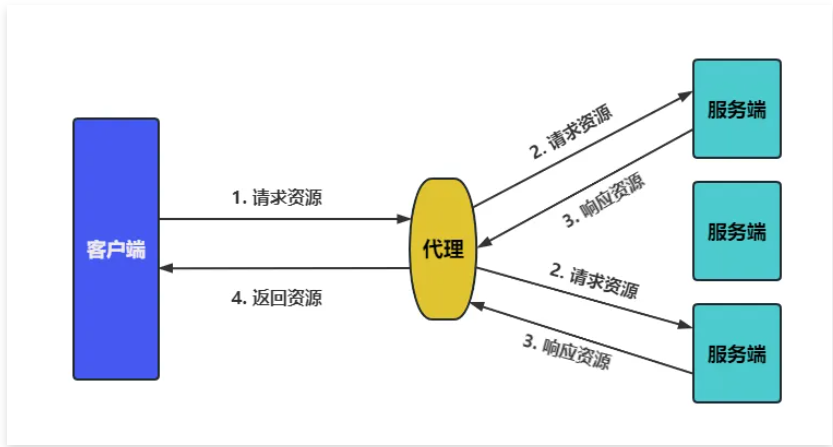

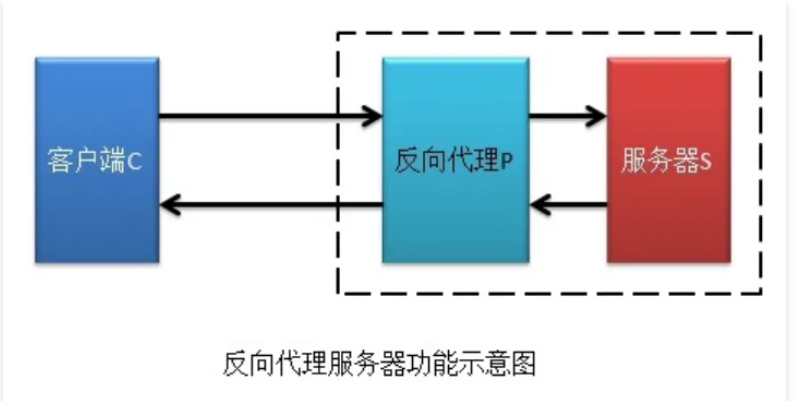

4.1.3 有代理场景

在使用代理的场景下,客户端无法直接向服务端发起请求,需要先请求代理服务,由代理服务代为请求后端节点,以实现客户端与后端通信。

使用代理会增加网络延迟,但能提高系统整体的响应,以此承担海量的并发请求。

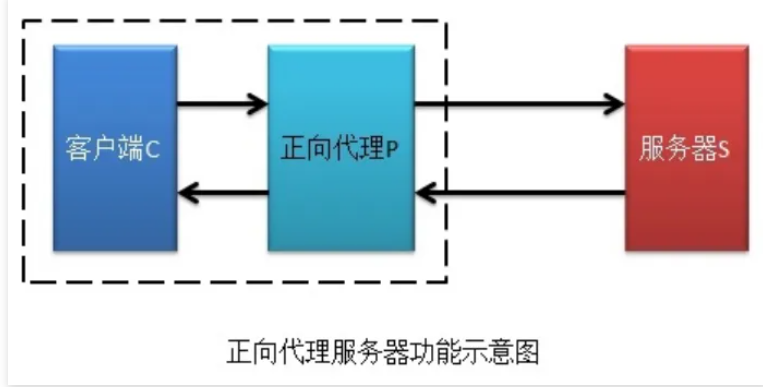

2. Nginx正向代理(个人)

正向代理,(内部上网) 客户端<-->代理->服务端.

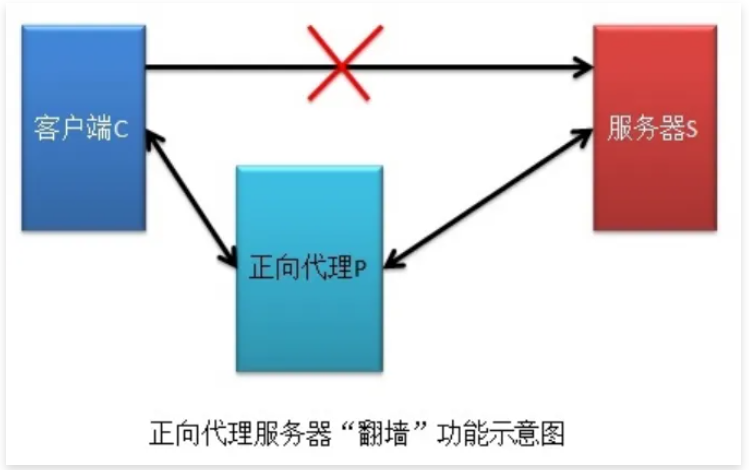

2.1 客户端科学上网

比如:科学的方式访问 Google.

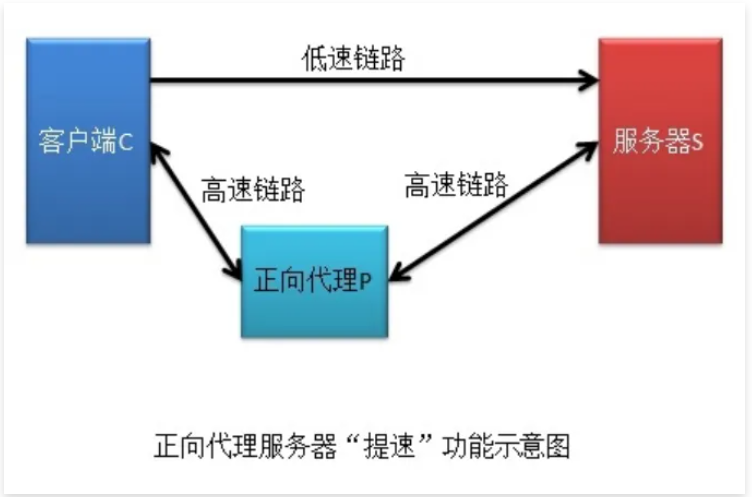

2.2 客户端提速

比如:游戏加速器.

2.3 客户端缓存

比如:下载资源,可以先查看代理服务是否有,如果有直接通过代理获取.

2.4 客户端授权

很多公司为了安全,连接外网需要通过防火墙,防火墙可以配置规则,允许谁可以上外网,谁不可以上外网.

3. Nginx反向代理(企业)

反向代理,用于公司集群架构中,客户端->代理<-->服务端.

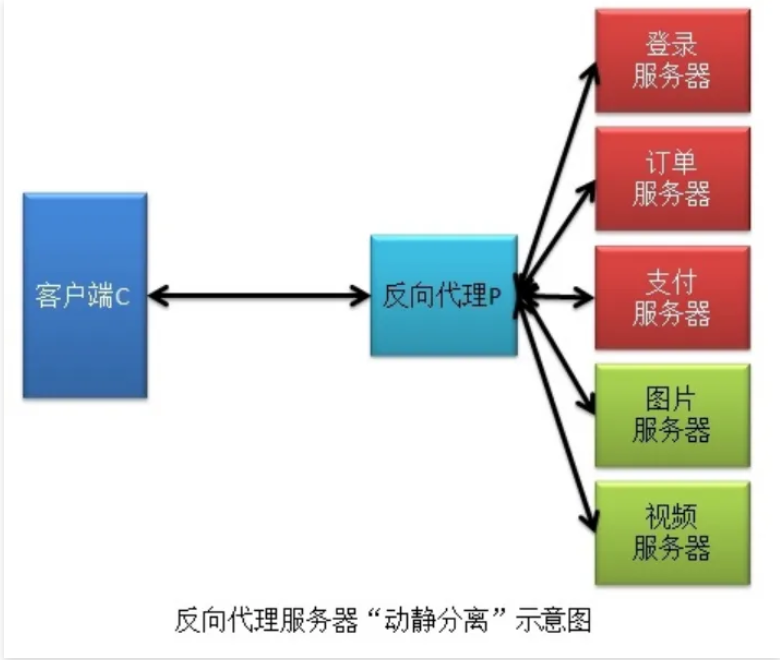

3.1 路由功能

根据用户请求的 URI 调度到【不同的功能的集群服务器】进行处理.

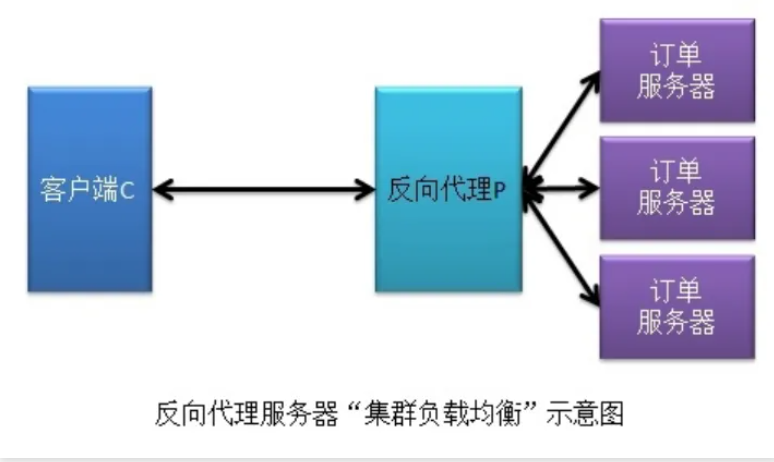

3.2 负载均衡

将用户发送的请求,通过负载均衡调度算法挑选一台合适的节点进行请求处理.

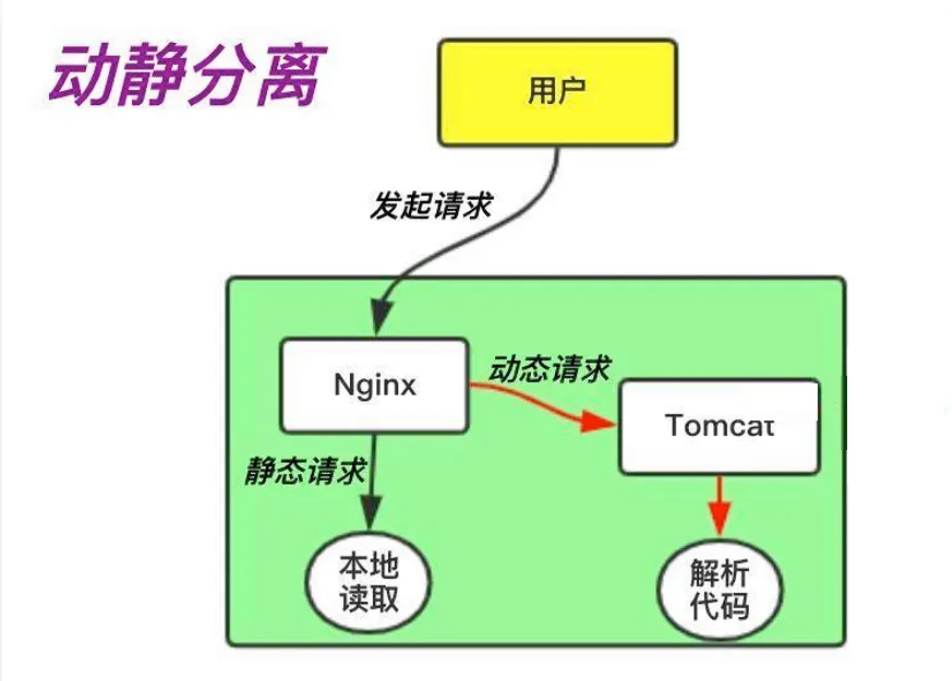

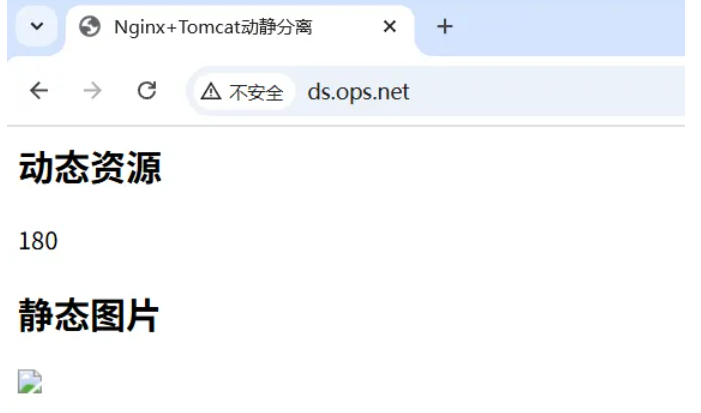

3.3 动静分离

根据用户请求的 URI 进行区分,将动态资源调度至应用服务器处理,将静态资源调度至静态资源服务器处理.

3.4 数据缓存

将后端查询的数据存储至反向代理上缓存,可以加速用户获取资源.

4. 正向与反向代理区别

区别在于形式上服务的"对象"不一样、其次架设的位置点不一样.

正向代理代理的对象是【客户端】,为客户端服务.反向代理代理的对象是【服务端】,为服务端服务.

user-->正向代理(路由器)--> 反向代理(缓存)--> 服务器.

5. Nginx可代理的协议

5.1 Nginx支持代理的协议

Nginx作为代理服务,支持的代理协议非常的多,如下图所示

5.2 Nginx常用的代理协议

通常情况下,我们将Nginx作为反向代理,常常会用到如下几种代理协议,如下图所示

6. Nginx反向代理实践

6.1 配置语法指令

Syntax: proxy_pass URL;

Default: —

Context: location, if in location,

limit_except

proxy_pass http://localhost:8000/uri/

http://10.0.0.7:8000/uri/6.2 代理配置场景

6.2.1 环境准备

6.2.2 web节点配置

# web01服务配置一个网站,监听在8080,此时网站仅172网段的用户能访问

[root@web01 ~]#cat /etc/yum.repos.d/nginx.repo

[nginx-stable]

name=nginx stable repo

baseurl=http://nginx.org/packages/centos/$releasever/$basearch/

gpgcheck=1

enabled=1

gpgkey=https://nginx.org/keys/nginx_signing.key

module_hotfixes=true

[nginx-mainline]

name=nginx mainline repo

baseurl=http://nginx.org/packages/mainline/centos/$releasever/$basearch/

gpgcheck=1

enabled=0

gpgkey=https://nginx.org/keys/nginx_signing.key

module_hotfixes=true

[root@web01 ~]#yum install nginx -y

[root@lb01 ~]# vim /etc/nginx/conf.d/web.ops.com.conf

server {

listen 8080;

server_name web.ops.com;

location / {

root /code_8080;

index index.html;

}

}

[root@lb01 ~]# mkdir /code_8080

[root@web01 /etc/nginx/conf.d]#echo "web01-site..." > /code_8080/index.html

[root@web01 /etc/nginx/conf.d]#systemctl restart nginx

[root@lb01 ~]# ss -ntl

State Recv-Q Send-Q Local Address:Port Peer Address:Port Process

LISTEN 0 511 0.0.0.0:80 0.0.0.0:*

LISTEN 0 128 0.0.0.0:22 0.0.0.0:*

LISTEN 0 511 0.0.0.0:8080 0.0.0.0:*

LISTEN 0 128 [::]:22 [::]:* 6.2.3 proxy节点配置

# proxy代理服务配置,让外网用户能够通过代理服务访问到后端的172.16.1.7的8080端口站点内容

[nginx-stable]

name=nginx stable repo

baseurl=http://nginx.org/packages/centos/$releasever/$basearch/

gpgcheck=1

enabled=1

gpgkey=https://nginx.org/keys/nginx_signing.key

module_hotfixes=true

[nginx-mainline]

name=nginx mainline repo

baseurl=http://nginx.org/packages/mainline/centos/$releasever/$basearch/

gpgcheck=1

enabled=0

gpgkey=https://nginx.org/keys/nginx_signing.key

module_hotfixes=true

[root@lb01 ~]#mv /etc/nginx/conf.d/default.conf /opt/

[root@lb01 ~]#vim /etc/nginx/conf.d/proxy_web.ops.com.conf

server {

listen 80;

server_name web.ops.com;

location / {

proxy_pass http://172.16.1.7:8080;

}

}

[root@lb01 ~]#systemctl restart nginx

[root@lb01 ~]#ss -ntl

State Recv-Q Send-Q Local Address:Port Peer Address:Port

LISTEN 0 128 *:22 *:*

LISTEN 0 100 127.0.0.1:25 *:*

LISTEN 0 128 *:80 *:*

LISTEN 0 128 [::]:22 [::]:*

LISTEN 0 100 [::1]:25 [::]:*

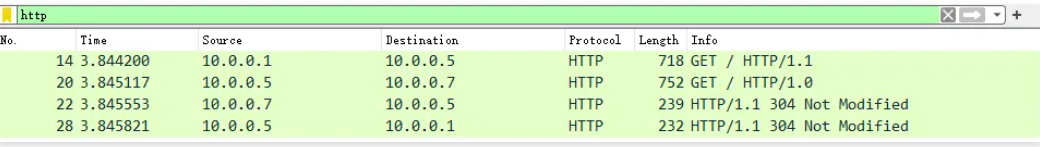

浏览器访问:10.0.0.56.2.4 抓包分析访问过程

抓包分析Nginx代理处理整个请求的过程

6.3 代理相关配置参数

6.3.1 proxy_set_header

# 添加发往后端服务器的请求头信息,

Syntax: proxy_set_header field value;

Default: proxy_set_header Host $proxy_host;

proxy_set_header Connection close;

Context: http, server, location

# 客户端请求Host的值是www.ops.net, 那么代理服务会向后端请求时携带Host变量为www.ops.net

proxy_set_header Host $http_host;

# 将$remote_addr的值放进变量X-Real-IP中,$remote_addr的值为客户端的ip

proxy_set_header X-Real-IP $remote_addr;

#配置Nginx记录该头部到访问日志

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for" "$http_x_real_ip"';

# 客户端通过代理服务访问后端服务,后端服务会通过该变量会记录真实客户端地址

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;X-Real-IP和X-Forwarded-For,它们都用于传递客户端的真实IP地址,但使用方式和目的有所不同

X-Real-IP:

• 这是一个非标准头部,通常由反向代理服务器设置,用于传递客户端的真实IP地址。

• 它只包含一个IP地址,即直接与反向代理服务器连接的客户端的IP地址。

• 使用简单,但只能记录一个IP地址。如果请求经过多个代理,则无法记录完整的代理链。

X-Forwarded-For:

• 这是一个标准头部,被广泛支持。

• 它包含一个IP地址列表,每个代理服务器都会将自己的客户端IP添加到这个列表中。

• 格式为:X-Forwarded-For: client, proxy1, proxy2

• 第一个IP是原始客户端IP,后续是经过的代理服务器IP。6.3.2 proxy_http_version

[root@lb01 ~]# cat /etc/nginx/conf.d/proxy_web.ops.com.conf

server {

listen 80;

server_name web.ops.com;

location / {

proxy_pass http://192.168.80.130:80;

proxy_http_version 1.1;

proxy_set_header Host $http_host;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

[root@lb01 ~]# vim /etc/nginx/conf.d/proxy_web.ops.com.conf

server {

listen 80;

server_name web.ops.com;

location / {

proxy_pass http://192.168.80.130:80;

proxy_http_version 1.1;

proxy_set_header Connection ""; #代理到后端时,不需要通过Connection这个字段来控制是否为长连接,只需要看协议版本即可

proxy_set_header Host $http_host;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

6.3.3 proxy_connect_timeout

#nginx代理与后端服务器 "连接超时" 时间(代理连接超时)

Syntax: proxy_connect_timeout time;

Default: proxy_connect_timeout 60s;

Context: http, server, location6.3.4 proxy_read_timeout

#nginx代理等待后端服务器 "响应(Header)超时" 时间

Syntax: proxy_read_timeout time;

Default: proxy_read_timeout 60s;

Context: http, server, location6.3.5 proxy_send_timeout

#后端服务器 "数据(Data)回传给nginx代理超时" 时间

Syntax: proxy_send_timeout time;

Default: proxy_send_timeout 60s;

Context: http, server, location[root@lb01 ~]# cat /etc/nginx/conf.d/proxy_web.ops.com.conf

server {

listen 80;

server_name web.ops.com;

location / {

proxy_pass http://192.168.80.130:80;

proxy_http_version 1.1;

proxy_set_header Connection "";

proxy_connect_timeout 120s;

proxy_read_timeout 120s;

proxy_send_timeout 120s;

proxy_set_header Host $http_host;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

[root@lb01 ~]# nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

[root@lb01 ~]# systemctl reload nginx6.3.6 proxy_buffer(缓冲区)

1)启用缓冲时,nginx代理服务器将尽快的接收响应Header以及响应报文,并将其保存到proxy_buffer_size(Headers) 和proxy_buffers(data) 设置的缓冲区中。

# proxy_buffer代理缓冲区

Syntax: proxy_buffering on | off;

Default: proxy_buffering on;

Context: http, server, location如果响应报文过大无法存储至内存,则会将其中部分保存到磁盘上的临时文件中。写入临时文件由proxy_temp_path(控制临时存储目录)proxy_max_temp_file_size(控制临时存储目录大

小) 和 proxy_temp_file_write_size(控制一次写入临时文件的数据大小),临时文件最大大小由proxy_buffer_size 和 proxy_buffers 限制。但当禁用缓冲时,nginx代理服务器会在接收到响应时立即同步传递给客户端。nginx代理服务器不会读取整个响应。

2)proxy_buffer_size用于控制代理服务读取后端第一部分响应Header的缓冲区大小。

Syntax: proxy_buffer_size size;

Default: proxy_buffer_size 4k|8k;

Context: http, server, location

# proxy_buffer_size 64k;3)proxy_buffers是代理服务器为单个连接设置响应缓冲区 “数量” 和 “大小” 。

如果一个后端服务所返回的页面大小为256KB,那么会为其分配4个64KB的缓冲区来缓存,如果页面大小大于256KB,那么大于256KB的部分会缓存到proxy_temp_path 指定的路径中。但是这并不是好方法,因为内存中的数据处理速度要快于硬盘。所以这个值一般建议设置为站点响应所产生的页面大小中间值,如果站点大部分脚本所产生的页面大小为256KB,那么可以把这个值设置为 “16 16k”、“4 64k” 等。

Syntax: proxy_buffers number size;

Default: proxy_buffers 8 4k|8k;

Context: http, server, location

#proxy_buffers 4 64k;[root@lb01 ~]# cat /etc/nginx/conf.d/proxy_web.ops.com.conf

server {

listen 80;

server_name web.ops.com;

location / {

proxy_pass http://192.168.80.130:80;

proxy_http_version 1.1;

proxy_set_header Connection "";

proxy_connect_timeout 120s;

proxy_read_timeout 120s;

proxy_send_timeout 120s;

proxy_buffering on;

proxy_buffer_size 64k;

proxy_buffers 4 64k;

proxy_set_header Host $http_host;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}6.3.7 代理参数总结

# 代理网站常用优化配置如下,将配置写入一个新文件,调用时使用include即可

[root@lb01 ~]# vim /etc/nginx/proxy_params

proxy_http_version 1.1;

proxy_set_header Host $http_host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 30;

proxy_send_timeout 60;

proxy_read_timeout 60;

proxy_buffering on;

proxy_buffer_size 64k;

proxy_buffers 4 64k;

# 使用include方式,便于后续Location的重复使用。

location / {

proxy_pass http://127.0.0.1:8080;

include proxy_params;

}7. 实现 FastCGI

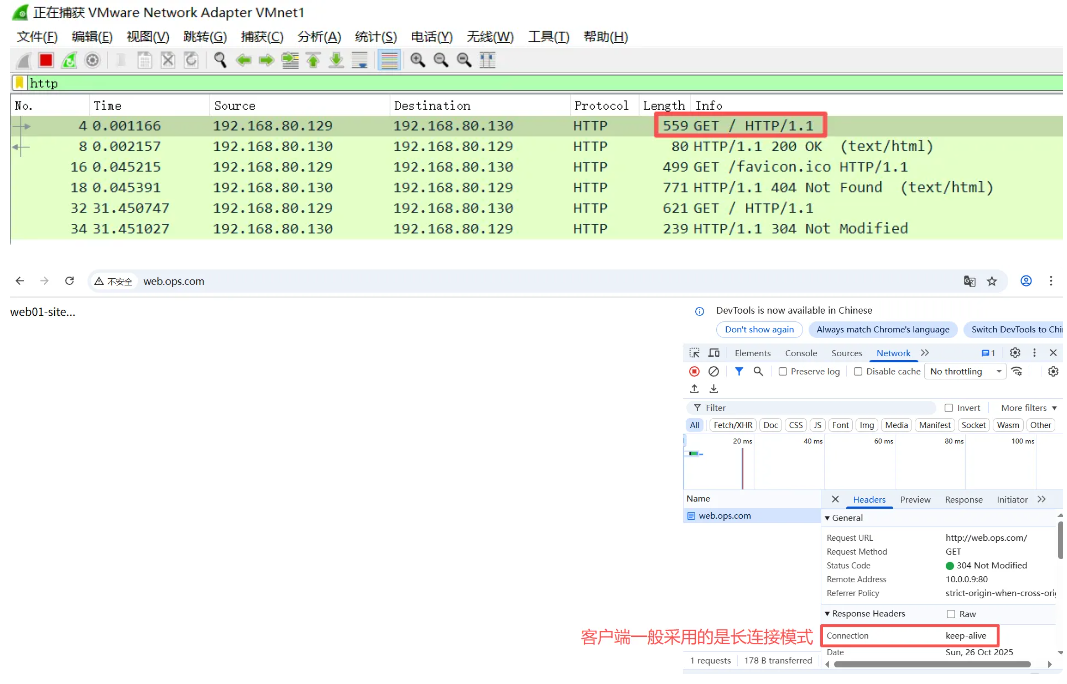

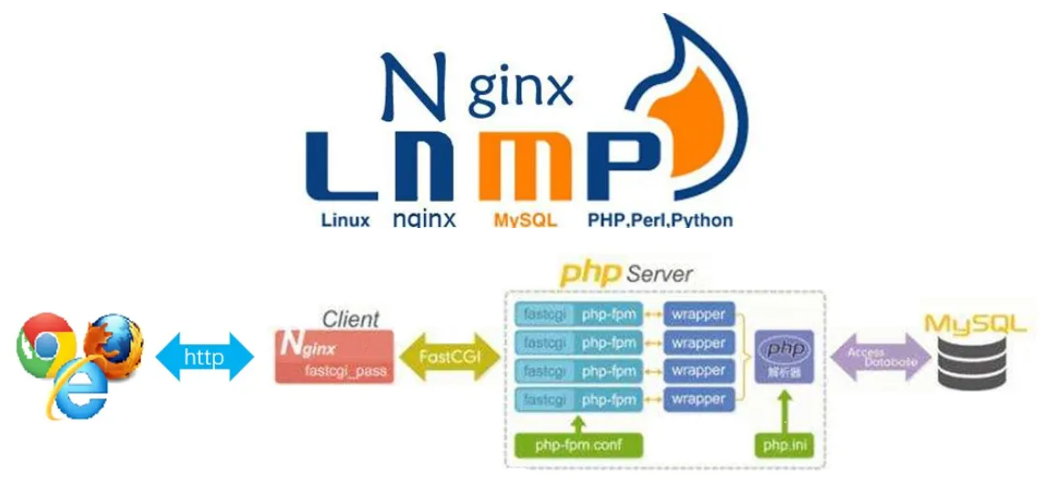

CGI的由来:

最早的Web服务器只能简单地响应浏览器发来的HTTP请求,并将存储在服务器上的HTML文件返回给浏览器,也就是静态html文件,但是后期随着网站功能增多网站开发也越来越复杂,以至于出现动态技术,比如像php(1995年)、java(1995)、python(1991)语言开发的网站,但是nginx/apache服务器并不能直接运行 php、java这样的文件,apache实现的方式是打补丁,但是nginx缺通过与第三方基于协议实现,即通过某种特定协议将客户端请求转发给第三方服务处理,第三方服务器会新建新的进程处理用户的请求,处理完成后返回数据给Nginx并回收进程,最后nginx在返回给客户端,那这个约定就是通用网关接口(common gateway interface,简称CGI),CGI(协议) 是web服务器和外部应用程序之间的接口标准,是cgi程序和web服务器之间传递信息的标准化接口。

7.1 为什么会有FastCGI?

CGI协议虽然解决了语言解析器和 Web Server 之间通讯的问题,但是它的效率很低,因为 Web Server每收到一个请求都会创建一个CGI进程,PHP解析器都会解析php.ini文件,初始化环境,请求结束的时候再关闭进程,对于每一个创建的CGI进程都会执行这些操作,所以效率很低,而FastCGI是用来提高CGI性能的,FastCGI每次处理完请求之后不会关闭掉进程,而是保留这个进程,使这个进程可以处理多个请求。这样的话每个请求都不用再重新创建一个进程了,大大提升了处理效率。

7.2 什么是PHP-FPM?

PHP-FPM(FastCGI Process Manager:FastCGI进程管理器)是一个实现了Fastcgi的程序,并且提供进程管理的功能。进程包括master进程和worker进程。master进程只有一个,负责监听端口,接受来自web server的请求。worker进程一般会有多个,每个进程中会嵌入一个PHP解析器,进行PHP代码的处理。

7.3 FastCGI配置指令

http://nginx.org/en/docs/http/ngx_http_fastcgi_module.html

Nginx基于模块ngx_http_fastcgi_module实现通过fastcgi协议将指定的客户端请求转发至php-fpm处理,其配置指令如下:

fastcgi_pass address;

#转发请求到后端服务器,address为后端的fastcgi server的地址,可用位置:location, if in location

#示例

fastcgi_pass localhost:9000;

fastcgi_pass unix:/tmp/fastcgi.socket; #注意:文件权限

fastcgi_index name;

#fastcgi默认的主页资源,示例:fastcgi_index index.php;

fastcgi_param parameter value [if_not_empty];

#设置传递给FastCGI服务器的参数值,可以是文本,变量或组合,可用于将Nginx的内置变量赋值给自定义key

fastcgi_param REMOTE_ADDR $remote_addr; #客户端源IP

fastcgi_param REMOTE_PORT $remote_port; #客户端源端口

fastcgi_param SERVER_ADDR $server_addr; #请求的服务器IP地址

fastcgi_param SERVER_PORT $server_port; #请求的服务器端口

fastcgi_param SERVER_NAME $server_name; #请求的server name

Nginx默认配置示例:

location ~ \.php$ {

root /scripts;

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name; #默认脚本路径

#fastcgi_param SCRIPT_FILENAME /scripts$fastcgi_script_name; #此行写法不再需要上面的 root 指令

fastcgi_param HTTPS on; #如果是前端代理采用https,当前后端http服务器需要加此项,否则可能会造成页面显示不正常

include fastcgi_params; #此文件默认系统已提供,存放的相对路径为prefix/conf

}fastcgi 缓存定义指令:注意使用fastcgi缓存, 可能会导致源代码更新失败,生产慎用

fastcgi_cache_path path [levels=levels] [use_temp_path=on|off] keys_zone=name:size [inactive=time] [max_size=size] [manager_files=number] [manager_sleep=time] [manager_threshold=time] [loader_files=number] [loader_sleep=time] [loader_threshold=time] [purger=on|off] [purger_files=number] [purger_sleep=time] [purger_threshold=time];

#定义fastcgi的缓存;

path #缓存位置为磁盘上的文件系统路径

max_size=size #磁盘path路径中用于缓存数据的缓存空间上限

levels=levels: #缓存目录的层级数量,以及每一级的目录数量,levels=ONE:TWO:THREE,示例:leves=1:2:2

keys_zone=name:size #设置缓存名称及k/v映射的内存空间的名称及大小

inactive=time #缓存有效时间,默认10分钟,需要在指定时间满足fastcgi_cache_min_uses 次数被视为活动缓存缓存调用指令:

fastcgi_cache zone | off;

#调用指定的缓存空间来缓存数据,可用位置:http, server, location

fastcgi_cache_key string;

#定义用作缓存项的key的字符串,示例:fastcgi_cache_key $request_uri;

fastcgi_cache_methods GET | HEAD | POST ...;

#为哪些请求方法使用缓存

fastcgi_cache_min_uses number;

#缓存空间中的缓存项在inactive定义的非活动时间内至少要被访问到此处所指定的次数方可被认作活动项

fastcgi_keep_conn on | off;

#收到后端服务器响应后,fastcgi服务器是否关闭连接,建议启用长连接

fastcgi_cache_valid [code ...] time;

#不同的响应码各自的缓存时长

fastcgi_hide_header field; #隐藏响应头指定信息

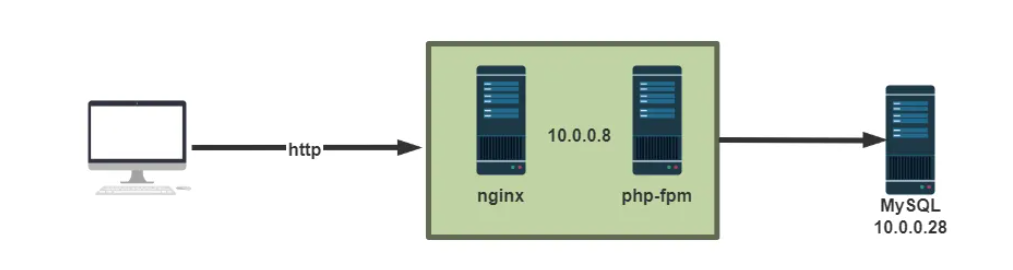

fastcgi_pass_header field; #返回响应头指定信息,默认不会将Status、X-Accel-...返回7.4 FastCGI实战案例 : Nginx与 Php-fpm在同一服务器

php安装可以通过yum或者编译安装,使用yum安装相对比较简单,编译安装更方便自定义参数或选项。

7.4.1 php 环境准备

范例: Ubuntu 安装 PHP-FPM

#Ubuntu2204安装php-fpm

[root@ubuntu2204 ~]#apt update

[root@ubuntu2204 ~]#apt -y install php-fpm

[root@ubuntu2204 ~]#php-fpm8.1 -v

PHP 8.1.2-1ubuntu2.22 (fpm-fcgi) (built: Jul 15 2025 12:11:22)

Copyright (c) The PHP Group

Zend Engine v4.1.2, Copyright (c) Zend Technologies

with Zend OPcache v8.1.2-1ubuntu2.22, Copyright (c), by Zend Technologies

[root@ubuntu2204 ~]#systemctl status php8.1-fpm

● php8.1-fpm.service - The PHP 8.1 FastCGI Process Manager

Loaded: loaded (/lib/systemd/system/php8.1-fpm.service; enabled; vendor preset: enabled)

Active: active (running) since Mon 2025-11-03 03:22:52 UTC; 18min ago

Docs: man:php-fpm8.1(8)

Process: 1022 ExecStartPost=/usr/lib/php/php-fpm-socket-helper install /run/php/php-fpm.sock /etc/php/8.1/fpm/pool.d/www.>

Main PID: 898 (php-fpm8.1)

Status: "Processes active: 0, idle: 2, Requests: 0, slow: 0, Traffic: 0req/sec"

Tasks: 3 (limit: 4515)

Memory: 15.2M

CPU: 373ms

CGroup: /system.slice/php8.1-fpm.service

├─ 898 "php-fpm: master process (/etc/php/8.1/fpm/php-fpm.conf)" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "">

├─1020 "php-fpm: pool www" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" ">

└─1021 "php-fpm: pool www" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" "" ">

Nov 03 03:22:41 ubuntu2204 systemd[1]: Starting The PHP 8.1 FastCGI Process Manager...

Nov 03 03:22:52 ubuntu2204 systemd[1]: Started The PHP 8.1 FastCGI Process Manager.

#Ubuntu2004安装php-fpm

[root@ubuntu2004 ~]#apt -y install php-fpm

[root@ubuntu2004 ~]#php-fpm7.4 -v

PHP 7.4.3 (fpm-fcgi) (built: Nov 2 2022 09:53:44)

Copyright (c) The PHP Group

Zend Engine v3.4.0, Copyright (c) Zend Technologies

with Zend OPcache v7.4.3, Copyright (c), by Zend Technologies

[root@ubuntu2004 ~]#systemctl status php7.4-fpm.service

● php7.4-fpm.service - The PHP 7.4 FastCGI Process Manager

Loaded: loaded (/lib/systemd/system/php7.4-fpm.service; enabled; vendor preset: enabled)

Active: active (running) since Wed 2022-11-30 18:23:09 CST; 28s ago

Docs: man:php-fpm7.4(8)

Process: 19905 ExecStartPost=/usr/lib/php/php-fpm-socket-helper install /run/php/php-fpm.sock /etc/php/7.4/fpm/pool.d/www.conf >

Main PID: 19887 (php-fpm7.4)

Status: "Processes active: 0, idle: 2, Requests: 0, slow: 0, Traffic: 0req/sec"

Tasks: 3 (limit: 2236)

Memory: 7.2M

CGroup: /system.slice/php7.4-fpm.service

├─19887 php-fpm: master process (/etc/php/7.4/fpm/php-fpm.conf)

├─19903 php-fpm: pool www

└─19904 php-fpm: pool www

11月 30 18:23:09 ubuntu2004 systemd[1]: Starting The PHP 7.4 FastCGI Process Manager...

11月 30 18:23:09 ubuntu2004 systemd[1]: Started The PHP 7.4 FastCGI Process Manager.

[root@ubuntu2204 ~]#ll /run/php/php-fpm.sock

lrwxrwxrwx 1 root root 30 Nov 3 03:22 /run/php/php-fpm.sock -> /etc/alternatives/php-fpm.sock=

#如果nginx使用socket文件和PHP进行通信,需要修改nginx服务和PHP-fpm使用相同的用户,比如:www-data,否则会出现502错误

#如果nginx通过9000端口和PHP进行通信,则无需修改用户身份

[root@ubuntu2204 ~]#ll /run/php/php8.1-fpm.sock

srw-rw---- 1 www-data www-data 0 Nov 3 03:22 /run/php/php8.1-fpm.sock=

[root@ubuntu2204 ~]#ls /run/php/php-fpm.sock -l

lrwxrwxrwx 1 root root 30 Nov 3 03:22 /run/php/php-fpm.sock -> /etc/alternatives/php-fpm.sock

#默认不支持远程连接,所以无回显

[root@ubuntu2204 ~]#ss -ntl | grep 9000范例: 红帽系统使用base源自带的php版本

#yum安装默认版本php和相关APP依赖的包

[root@centos8 ~]# yum -y install php-fpm php-mysqlnd php-json #默认版本

#或者安装清华的php源

[root@centos7 ~]# yum -y install https://mirrors.tuna.tsinghua.edu.cn/remi/enterprise/remi-release-7.rpm

[root@centos8 ~]# systemctl enable --now php-fpm

[root@centos8 ~]# ps -ef | grep php-fpm

root 4925 1 0 17:13 ? 00:00:00 php-fpm: master process

(/etc/php-fpm.conf)

apache 4927 4925 0 17:13 ? 00:00:00 php-fpm: pool www

apache 4928 4925 0 17:13 ? 00:00:00 php-fpm: pool www

apache 4929 4925 0 17:13 ? 00:00:00 php-fpm: pool www

apache 4930 4925 0 17:13 ? 00:00:00 php-fpm: pool www

apache 4931 4925 0 17:13 ? 00:00:00 php-fpm: pool www

root 4933 3235 0 17:13 pts/0 00:00:00 grep --color=auto php-fpm7.4.2 php 相关配置优化

范例: Ubuntu

[root@ubuntu2204 ~]#vim /etc/php/8.1/fpm/php.ini

date.timezone = Asia/Shanghai

post_max_size = 100M #限制整个 POST 请求的总数据量

upload_max_filesize = 100M #仅限制单个上传文件的大小

[root@ubuntu2204 ~]#vim /etc/php/8.1/fpm/pool.d/www.conf

listen = 127.0.0.1:9000

;listen = /run/php/php8.1-fpm.sock

pm.status_path = /pm_status

ping.path = /ping

[root@ubuntu2204 ~]#systemctl restart php8.1-fpm.service范例: 红帽系统

[root@centos8 ~]# grep "^[a-Z]" /etc/php-fpm.conf

include=/etc/php-fpm.d/*.conf

pid = /run/php-fpm/php-fpm.pid

error_log = /var/log/php-fpm/error.log

daemonize = yes #是否后台启动

[root@centos8 ~]#grep -Ev '^;.*$|^ *$' /etc/php-fpm.d/www.conf

[www]

user = nginx

group = nginx

listen = /run/php-fpm/www.sock #指定使用UDS,或者使用下面形式,需要注意文件权限

;listen = 127.0.0.1:9000 #监听地址及IP

listen.acl_users = apache,nginx

listen.allowed_clients = 127.0.0.1

pm = dynamic

pm.max_children = 50

pm.start_servers = 5

pm.min_spare_servers = 5

pm.max_spare_servers = 35

pm.status_path = /pm_status #修改此行

ping.path = /ping #修改此行

ping.response = ping-pong #修改此行

slowlog = /var/log/php-fpm/www-slow.log #慢日志路径

php_admin_value[error_log] = /var/log/php-fpm/www-error.log #错误日志

php_admin_flag[log_errors] = on

php_value[session.save_handler] = files #phpsession保存方式及路径

php_value[session.save_path] = /var/lib/php/session #当时使用file保存session的文件路径

#文件最后修改下面两行

php_value[session.save_handler] = redis

php_value[session.save_path] = "tcp://redis-server:6379"

php_value[soap.wsdl_cache_dir] = /var/lib/php/wsdlcache

php_value[upload_max_filesize] = 20m

php_value[post_max_size] = 20m

php_value[date.timezone] = Asia/Shanghai

#修改配置文件后记得重启php-fpm

[root@centos8 ~]# systemctl restart php-fpm7.4.3 准备php测试页面

[root@ubuntu2204 ~]#mkdir -p /data/php

[root@ubuntu2204 ~]#vim /data/php/index.php #php测试页面

<?php

phpinfo();

?>

#测试连接数据库

[root@ubuntu2204 ~]#vim /data/php/mysql.php

<?php

$servername = "localhost";

$username = "root";

$password = "123456";

// 创建连接

$conn = mysqli_connect($servername,$username, $password);

// 检测连接

if (!$conn) {

die("php连接MySQL数据库失败: " . mysqli_connect_error());

}

echo "php连接MySQL数据库成功!";

?>

[root@ubuntu2204 ~]#apt install mysql-server -y

[root@ubuntu2204 ~]#systemctl start mysql

[root@ubuntu2204 ~]#mysql

mysql> create user root@"%" identified by '123';

Query OK, 0 rows affected (0.02 sec)

mysql> grant all on *.* to root@"%";

Query OK, 0 rows affected (0.00 sec)

mysql> flush privileges;

Query OK, 0 rows affected (0.00 sec)

[root@ubuntu2204 ~]#vi /etc/mysql/mysql.conf.d/mysqld.cnf

bind-address = 0.0.0.0

#mysqlx-bind-address = 127.0.0.1

[root@ubuntu2204 ~]#systemctl restart mysql

#运行测式脚本

[root@ubuntu2204 ~]#apt install php8.1-mysqli -y

[root@ubuntu2204 ~]#php /data/php/mysql.php

php连接MySQL数据库成功!7.4.4 Nginx配置转发

Nginx安装完成之后默认生成了与fastcgi的相关配置文件,一般保存在nginx的安装路径的conf目录当中

比如: /apps/nginx/conf/fastcgi.conf、/apps/nginx/conf/fastcgi_params、/etc/nginx/fastcgi_params

[root@ubuntu2204 ~]#apt install nginx -y

[root@ubuntu2204 ~]#vim /etc/nginx/conf.d/pc.conf

[root@ubuntu2204 ~]#mkdir -p /data/php

[root@ubuntu2204 ~]#vim /etc/nginx/conf.d/pc.conf

server {

listen 80;

server_name www.ops.net;

index index.php index.html;

location ~ \.php$|pm_status|ping {

root /data/php; #下面的$document_root调用此行的root指令指定的目录

#fastcgi_pass unix:/run/php-fpm/www.sock; #指定使用UDS,或者使用下面形式,需要注意文件权限

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

#fastcgi_param SCRIPT_FILENAME /data/php$fastcgi_script_name;

#如果SCRIPT_FILENAME是上面的绝对路径则可以省略root /data/php;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

include fastcgi_params;

fastcgi_param HTTPS $https if_not_empty; #有些应用支持https需要此项,否则会造成页面不正常

}

}

[root@ubuntu2204 ~]#nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

#重启Nginx并访问web测试

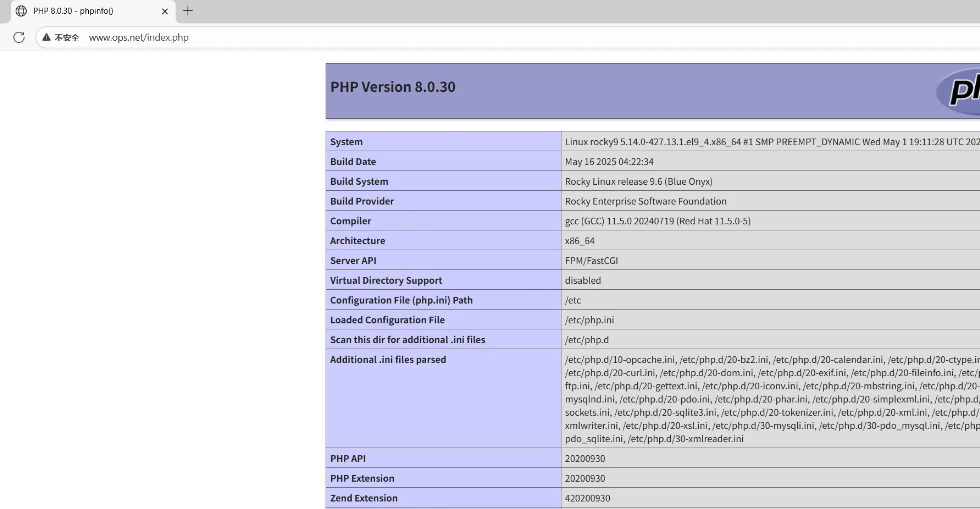

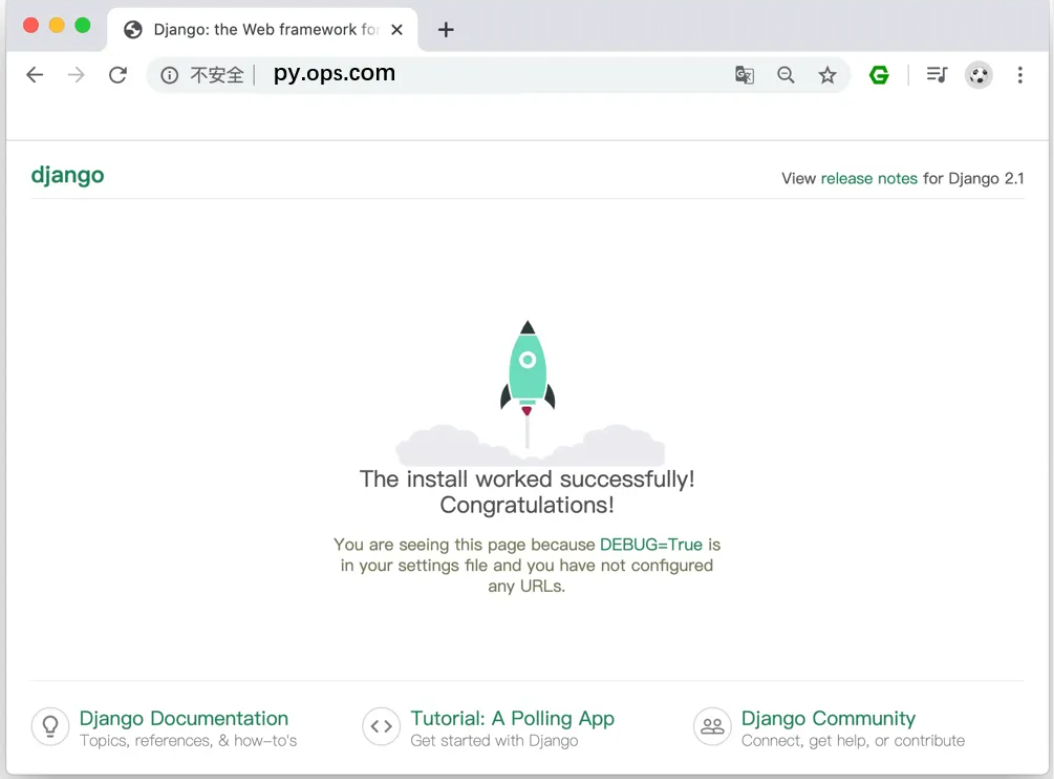

[root@ubuntu2204 ~]#systemctl restart nginx7.5.5 访问验证php测试页面

访问: http://www.ops.net/index.php 显示下面页面

#常见的错误:

File not found. #路径不对

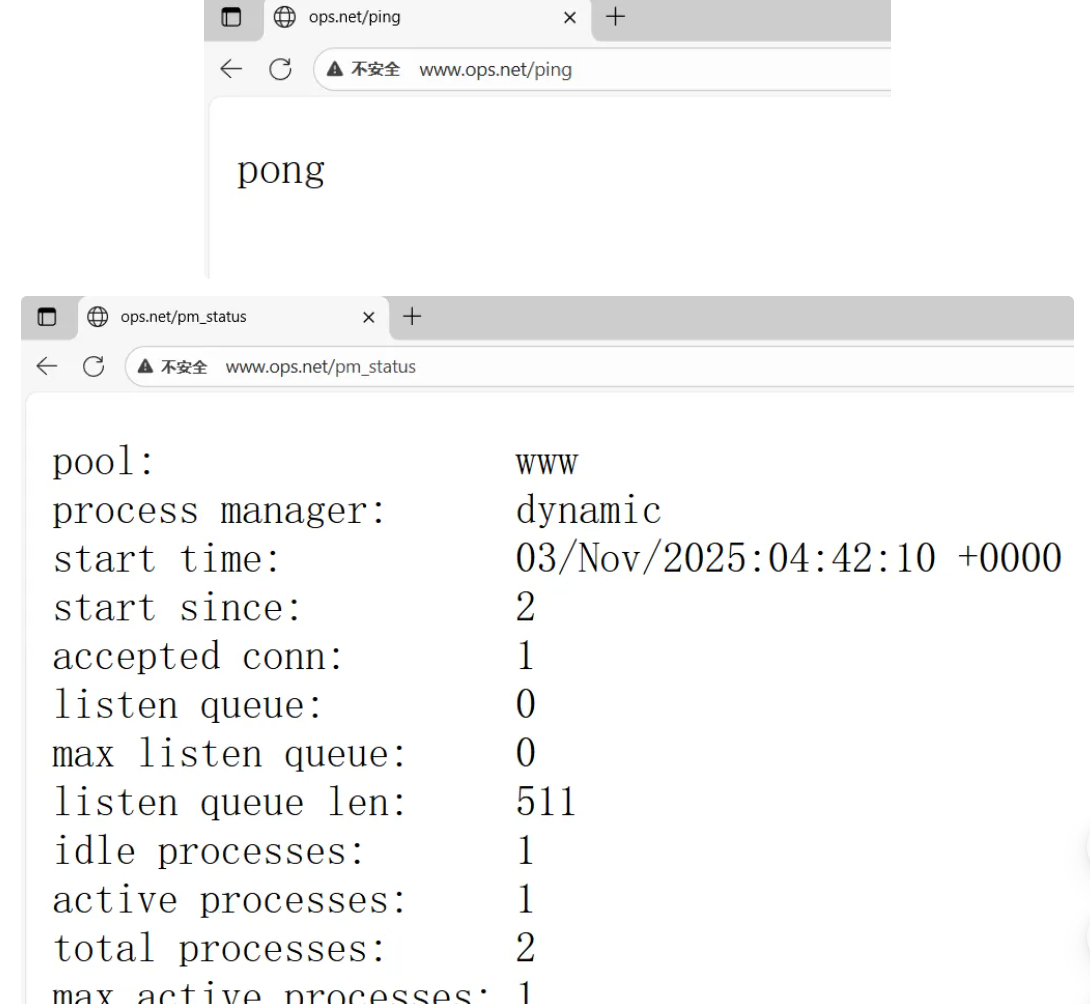

502 #php-fpm处理超时、服务停止运行等原因导致的无法连接或请求超时7.5.6 php-fpm 的运行状态页面

访问配置文件里面指定的路径,会返回php-fpm的当前运行状态。

Nginx配置:

location ~ ^/(ping|pm_status)$ {

fastcgi_pass unix:/run/php-fpm/www.sock;

#fastcgi_pass 127.0.0.1:9000;

fastcgi_param PATH_TRANSLATED $document_root$fastcgi_script_name;

include fastcgi_params;

}

#重启Nginx并测试:

[root@ubuntu2204 ~]#curl www.ops.net/ping

pong

[root@ubuntu2204 ~]#curl www.ops.net/pm_status

pool: www

process manager: dynamic

start time: 03/Nov/2025:04:42:10 +0000

start since: 88

accepted conn: 3

listen queue: 0

max listen queue: 0

listen queue len: 511

idle processes: 1

active processes: 1

total processes: 2

max active processes: 1

max children reached: 0

slow requests: 0

[root@ubuntu2204 ~]#curl www.ops.net/pm_status?full

[root@ubuntu2204 ~]#curl www.ops.net/pm_status?html

[root@ubuntu2204 ~]#curl www.ops.net/pm_status?json7.5.7 配置 php 开启 opcache 加速(默认已开启)

[root@ubuntu2204 ~]#dpkg -L php8.1-opcache

/.

/etc

/etc/php

/etc/php/8.1

/etc/php/8.1/mods-available

[root@ubuntu2204 ~]#cat /etc/php/8.1/mods-available/opcache.ini

; configuration for php opcache module

; priority=10

zend_extension=opcache.so

[root@web01 ~]# yum -y install httpd-tools

#压测

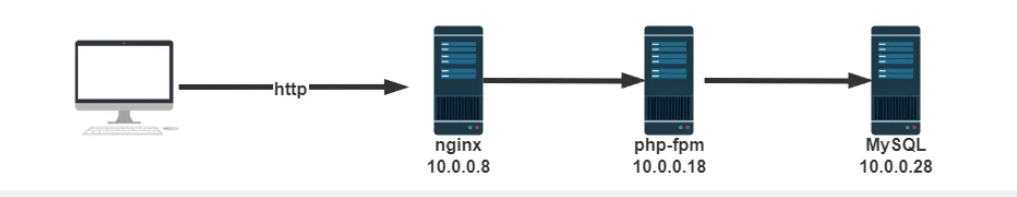

[root@web01 ~]# ab -c 100 -n 1000 http://www.ops.net/index.php7.5 FastCGI实战案例 : Nginx与php不在同一个服务器

7.5.1 yum安装较新版本php-fpm

[root@rocky9 ~]# dnf -y install php-fpm php-mysqlnd php-json php

[root@rocky9 ~]# php -v

PHP 8.0.30 (cli) (built: May 16 2025 04:22:34) ( NTS gcc x86_64 )

Copyright (c) The PHP Group

Zend Engine v4.0.30, Copyright (c) Zend Technologies

with Zend OPcache v8.0.30, Copyright (c), by Zend Technologies

#验证安装路径:

[root@rocky9 ~]# php-fpm -v

PHP 8.0.30 (fpm-fcgi) (built: May 16 2025 04:22:34)

Copyright (c) The PHP Group

Zend Engine v4.0.30, Copyright (c) Zend Technologies

[root@rocky9 ~]# rpm -ql php-fpm

/etc/httpd/conf.d/php.conf

/etc/logrotate.d/php-fpm

/etc/nginx/conf.d/php-fpm.conf

/etc/nginx/default.d/php.conf

/etc/php-fpm.conf

/etc/php-fpm.d

/etc/php-fpm.d/www.conf

/etc/systemd/system/php-fpm.service.d

/run/php-fpm

/usr/lib/.build-id

/usr/lib/.build-id/f5

/usr/lib/.build-id/f5/7e3528401da695c3ef396427bfedca66e365df

/usr/lib/systemd/system/httpd.service.d/php-fpm.conf

/usr/lib/systemd/system/nginx.service.d/php-fpm.conf

/usr/lib/systemd/system/php-fpm.service

/usr/sbin/php-fpm

/usr/share/doc/php-fpm

/usr/share/doc/php-fpm/php-fpm.conf.default

/usr/share/doc/php-fpm/www.conf.default

/usr/share/fpm

/usr/share/fpm/status.html

/usr/share/licenses/php-fpm

/usr/share/licenses/php-fpm/fpm_LICENSE

/usr/share/man/man8/php-fpm.8.gz

/var/lib/php/opcache

/var/lib/php/session

/var/lib/php/wsdlcache

/var/log/php-fpm7.5.2 修改php-fpm监听配置

php-fpm默认监听在127.0.0.1的9000端口,也就是无法远程连接,因此要做相应的修改。

;listen = /run/php-fpm/www.sock #注释此行

listen = 9000 #修改此行,指定监听端口

;listen.allowed_clients = 127.0.0.1 #注释此行7.5.3 准备php测试页面

#准备php数据目录

[root@rocky9 ~]# mkdir -p /data/php

#准备php数据目录

[root@rocky9 ~]# vi /data/php/index.php

<?php

phpinfo();

?>

#测试连接数据库

[root@rocky9 ~]# vi /data/php/mysql.php

<?php

$servername = "10.0.0.90";

$username = "root";

$password = "123";

// 创建连接

$conn = mysqli_connect($servername,$username, $password);

// 检测连接

if (!$conn) {

die("php连接MySQL数据库失败: " . mysqli_connect_error());

}

echo "php连接MySQL数据库成功!";

?>

#运行测式脚本

[root@rocky9 ~]# php /data/php/mysql.php

php连接MySQL数据库成功!7.5.4 启动并验证php-fpm

#启动php-fpm

[root@rocky9 ~]# systemctl enable --now php-fpm.service

#验证php-fpm进程及端口:

[root@rocky9 ~]# ps -ef | grep php-fpm

root 11835 1 0 13:35 ? 00:00:00 php-fpm: master process (/etc/php-fpm.conf)

apache 11836 11835 0 13:35 ? 00:00:00 php-fpm: pool www

apache 11837 11835 0 13:35 ? 00:00:00 php-fpm: pool www

apache 11838 11835 0 13:35 ? 00:00:00 php-fpm: pool www

apache 11839 11835 0 13:35 ? 00:00:00 php-fpm: pool www

apache 11840 11835 0 13:35 ? 00:00:00 php-fpm: pool www

root 11842 11458 0 13:35 pts/0 00:00:00 grep --color=auto php-fpm

[root@rocky9 ~]# ss -ntl | grep 9000

LISTEN 0 511 *:9000 *:*

[root@rocky9 ~]# dnf -y install lsof

[root@rocky9 ~]# lsof -i :9000

COMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME

php-fpm 11835 root 8u IPv6 39291 0t0 TCP *:cslistener (LISTEN)

php-fpm 11836 apache 10u IPv6 39291 0t0 TCP *:cslistener (LISTEN)

php-fpm 11837 apache 10u IPv6 39291 0t0 TCP *:cslistener (LISTEN)

php-fpm 11838 apache 10u IPv6 39291 0t0 TCP *:cslistener (LISTEN)

php-fpm 11839 apache 10u IPv6 39291 0t0 TCP *:cslistener (LISTEN)

php-fpm 11840 apache 10u IPv6 39291 0t0 TCP *:cslistener (LISTEN)

7.5.5 Nginx配置转发

[root@ubuntu2204 ~]#vi /etc/nginx/conf.d/pc.conf

server {

listen 80;

server_name www.ops.net;

index index.php index.html;

location ~ \.php$ {

root /data/php;

fastcgi_pass 10.0.0.9:9000;

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME /data/php$fastcgi_script_name;

#fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

include fastcgi_params;

}

location ~ ^/(ping|pm_status)$ {

fastcgi_pass 10.0.0.9:9000;

fastcgi_param PATH_TRANSLATED $document_root$fastcgi_script_name;

include fastcgi_params;

}

}

#重启nginx

[root@ubuntu2204 ~]#systemctl restart nginx[root@ubuntu2204 ~]#php -v

PHP 8.1.2-1ubuntu2.22 (cli) (built: Jul 15 2025 12:11:22) (NTS)

Copyright (c) The PHP Group

Zend Engine v4.1.2, Copyright (c) Zend Technologies

with Zend OPcache v8.1.2-1ubuntu2.22, Copyright (c), by Zend Technologies

[root@rocky9 ~]# php -v

PHP 8.0.30 (cli) (built: May 16 2025 04:22:34) ( NTS gcc x86_64 )

Copyright (c) The PHP Group

Zend Engine v4.0.30, Copyright (c) Zend Technologies

with Zend OPcache v8.0.30, Copyright (c), by Zend Technologies7.5.6 访问验证php测试页面

6、Nginx七层负载均衡

1. Nginx负载均衡基本概述

1.1 什么是负载均衡

负载均衡 Load Balance,指的是将用户访问请求所产生的流量,进行平衡,分摊到多个应用节点处理。

负载均衡扩展了应用的服务能力,增强了应用的可用性。

SLB;

CLB;

ULB;

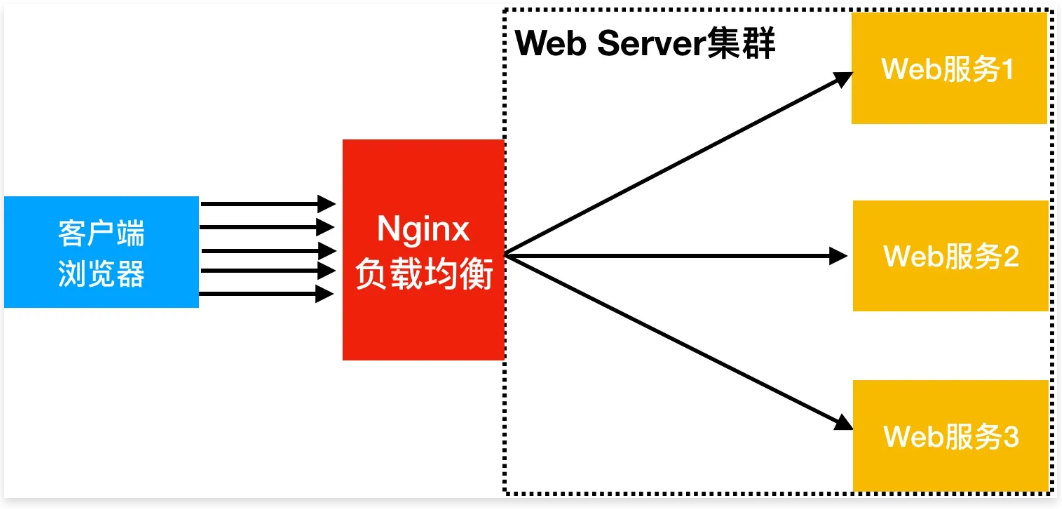

1.2 为什么需要负载均衡

当我们的 Web服务器直接面向用户,往往要承载大量并发请求,单台服务器难以负荷,我使用多台 WEB 服务器组成集群,前端使用 Nginx 负载均衡,将请求分散的打到我们的后端服务器集群中,实现负载的流量分发。从而提升整体性能、以及系统的容灾能力。

1.3 负载均衡与代理区别

Nginx负载均衡与Nginx反向代理不同地方在于:

Nginx代理仅代理一台服务器基于URI来调度,调度到不同功能的应用节点处理。Nginx负载均衡则是将客户端请求通过proxy_pass代理至一组upstream资源池。

2. Nginx负载均衡应用场景

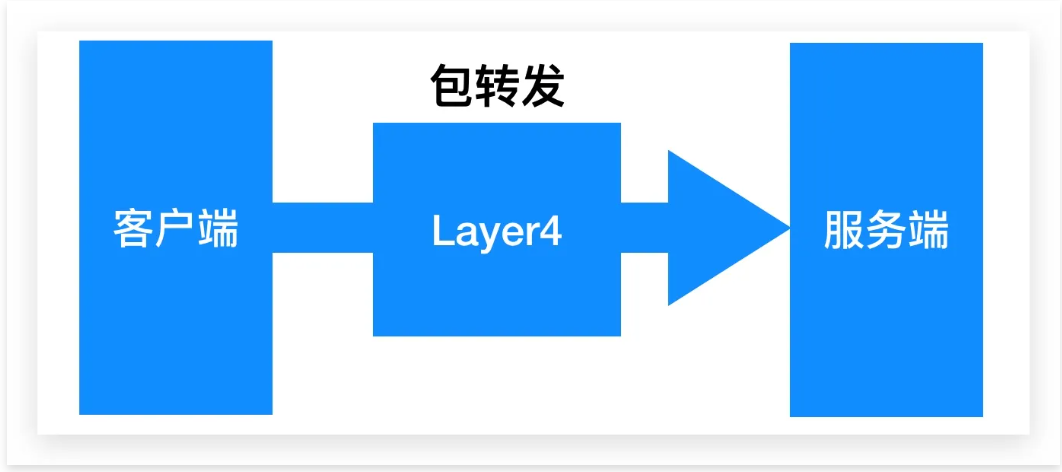

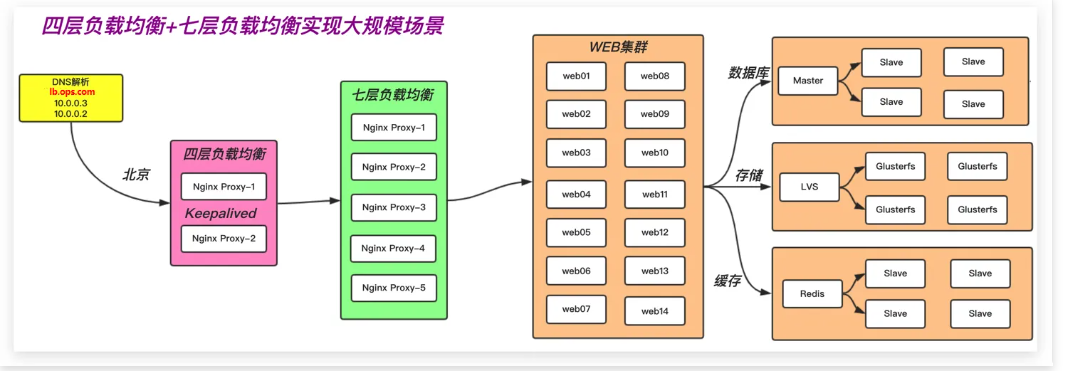

2.1 四层负载均衡

四层负载均衡指的是 OSI 七层模型中的传输层,四层仅需要对客户端的请求进行TCP/IP协议的包代理就可以实现负载均衡。IP+Port

四层负载均衡的性能极好、因为只需要底层进行转发处理,而不需要进行一些复杂的逻辑。

2.2 七层负载均衡

七层负载均衡工作在应用层,它可以完成很多应用方面的协议请求,比如我们说的 http 应用负载均衡,它可以实现 http 头信息的改写、安全应用规则控制、URI 匹配规则控制、及 rewrite 等功能,所以在应用层里面可以做的内容就更多了。

2.3 四层与七层区别

四层负载均衡:传输层

优点:性能高,数据包在底层就进行了转发

缺点:仅支持

ip:prot转发,无法完成复杂的业务逻辑应用。MySQL TCP 3306,Redis、SSH、等;

七层负载均衡:应用层

优点:贴近业务,支持

URI路径匹配、Header改写、Rewrite等缺点:性能低,数据包需要拆解到顶层才进行调度,消耗随机端口;

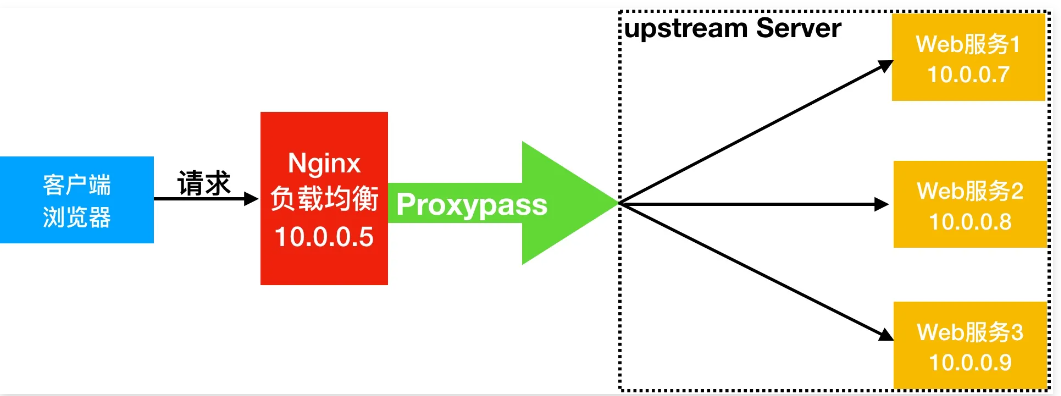

3. Nginx负载均衡配置场景

Nginx 实现负载均衡需要两个模块:

proxy_pass代理模块proxy_modulesupstream虚拟资源池模块proxy_upstream_module

Syntax: upstream name { ... }

Default: -

Context: http

#upstream例

upstream backend {

server backend1.example.com weight=5;

server backend2.example.com:8080;

server unix:/tmp/backend3;

server backup1.example.com:8080 backup;

}

server {

location / {

proxy_pass http://backend;

}

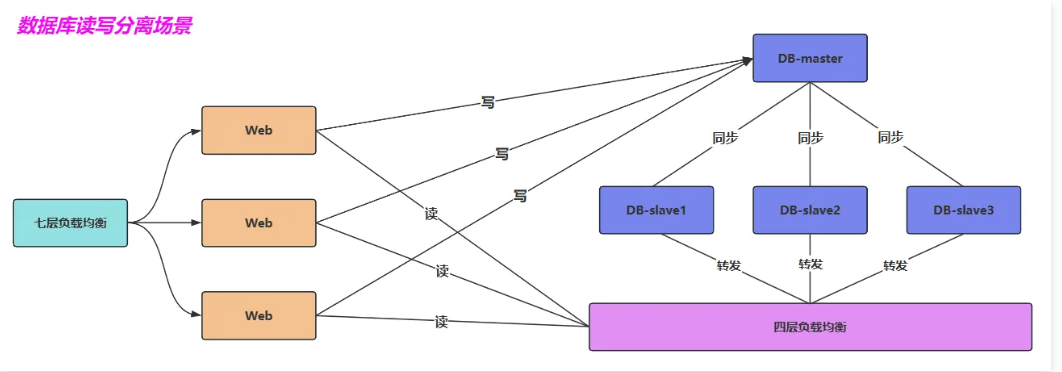

}3.1 负载均衡场景环境规划

负载均衡场景架构图规划

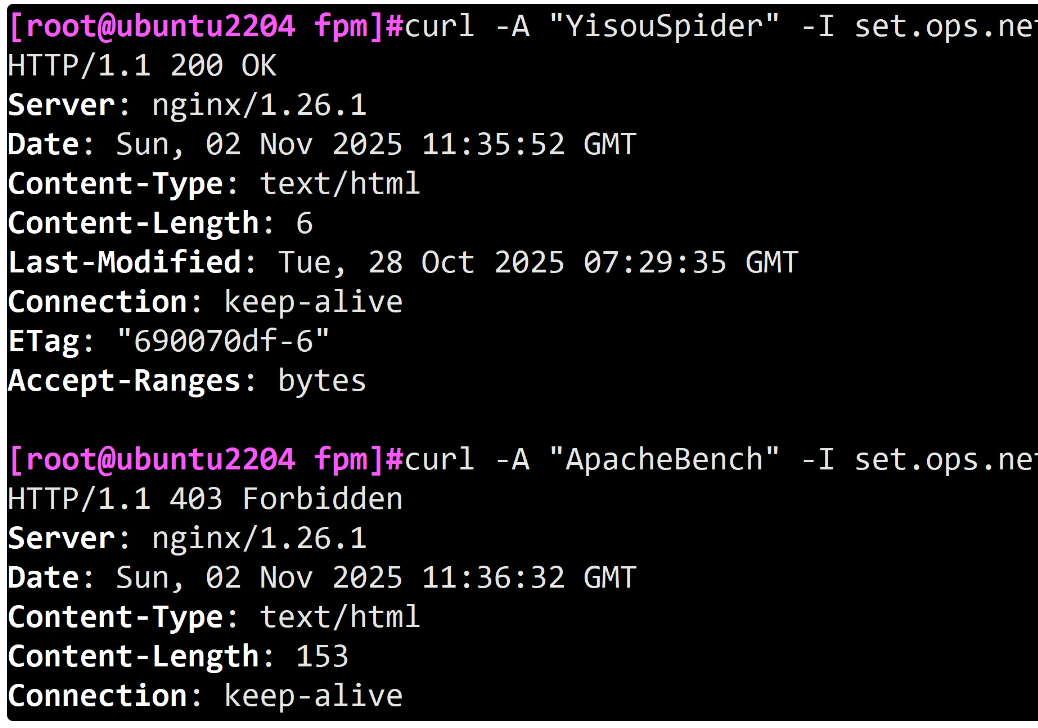

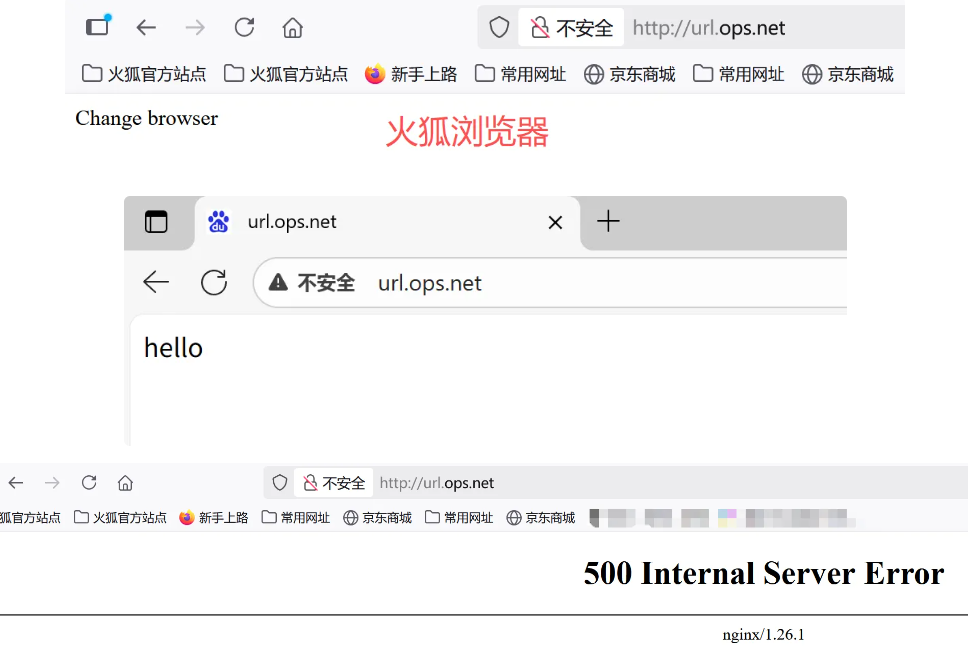

负载均衡场景地址规划

3.2 后端Web节点配置实例

Web01服务器上配置为应用服务节点, 创建对应html文件

[root@web01 ~]# vim /etc/nginx/conf.d/web.ops.com.conf

server {

listen 80;

server_name web.ops.com;

root /web;

location / {

index index.html;

}

}

[root@web01 conf.d]# mkdir /web

[root@web01 conf.d]# echo "Web01..." > /web/index.html

[root@web01 conf.d]# systemctl restart nginxWeb02 服务器上配置为应用服务节点, 创建对应

html文件

[root@web02 ~]# vim /etc/nginx/conf.d/web.ops.com.conf

server {

listen 80;

server_name web.ops.com;

root /web;

location / {

index index.html;

}

}

[root@web02 conf.d]# mkdir /web

[root@web02 conf.d]# echo "Web02..." > /web/index.html

[root@web02 conf.d]# systemctl restart nginx3.3 前端接入Nginx负载均衡

将

lb01配置为负载均衡,将所有请求代理至虚拟资源池

[root@lb01 ~]# vim /etc/nginx/conf.d/proxy_web.ops.com.conf

upstream web {

server 172.16.1.7:80;

server 172.16.1.8:80;

}

server {

listen 80;

server_name web.ops.com;

location / {

proxy_pass http://web;

include proxy_params;

}

}

[root@lb01 conf.d]# systemctl restart nginx2.准备 Nginx 负载均衡需要使用的 proxy_params 文件

[root@Nginx ~]# vim /etc/nginx/proxy_params

proxy_set_header Host $http_host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 30;

proxy_send_timeout 60;

proxy_read_timeout 60;

proxy_buffering on;

proxy_buffer_size 64k;

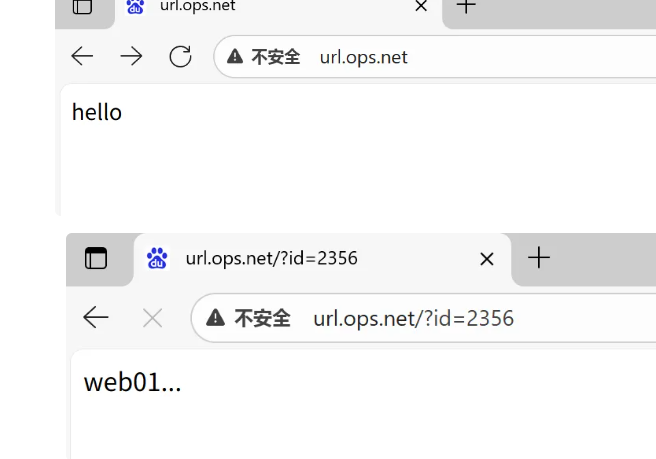

proxy_buffers 4 64k;3.4 浏览器访问测试负载效果

使用浏览器访问 web.ops.com,然后进行刷新测试

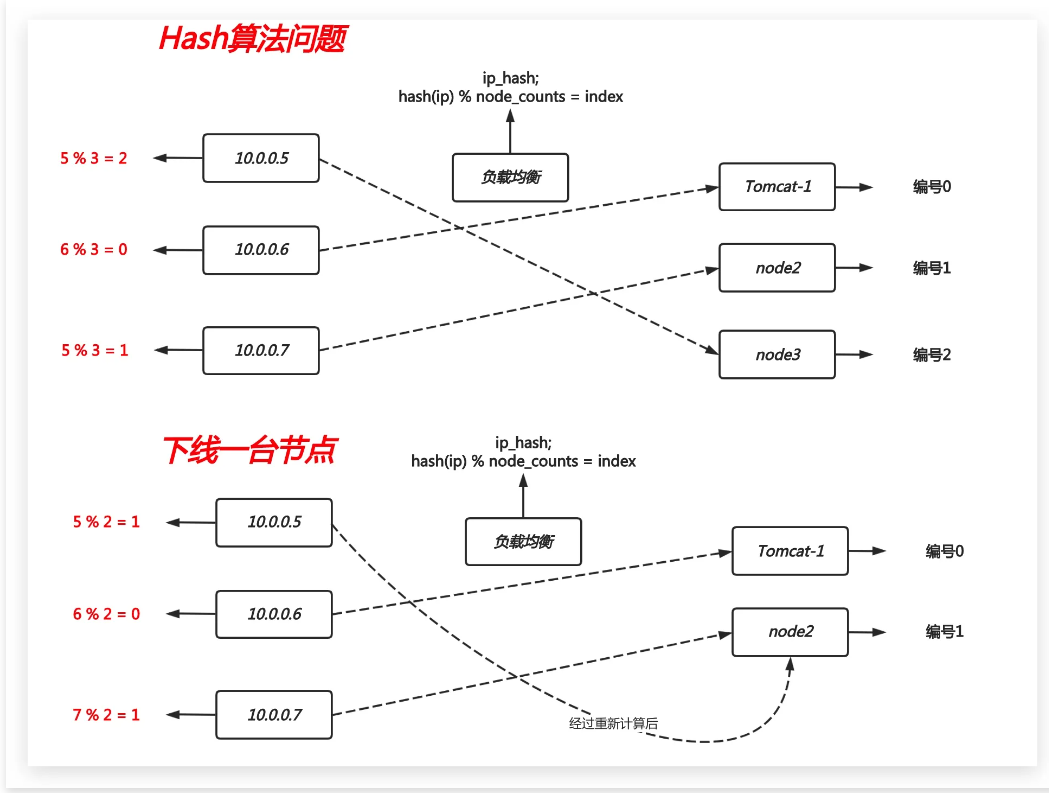

4. Nginx负载均衡调度算法

4.1 轮询调度算法

轮询调度算法的原理是将每一次用户的请求,轮流分配给内部中的服务器。

轮询算法的优点是其简洁性,它无需记录当前所有连接的状态,所以它是一种无状态调度。

upstream load_pass {

server 172.16.1.7:80;

server 172.16.1.8:80;

}

server {

listen 80;

server_name web.ops.com;

location / {

proxy_pass http://load_pass;

include proxy_params;

}4.2 加权轮询调度算法

轮询调度算法没有考虑每台服务器的处理能力,在实际情况中,由于每台服务器的配置、安装的业务应用等不同,其处理能力会不一样。所以,我们根据服务器的不同处理能力,给每个服务器分配不同的权值,使其能够接受相应权值数的服务请求。

upstream load_pass {

server 172.16.1.7:80 weight=5;

server 172.16.1.8:80 weight=1;

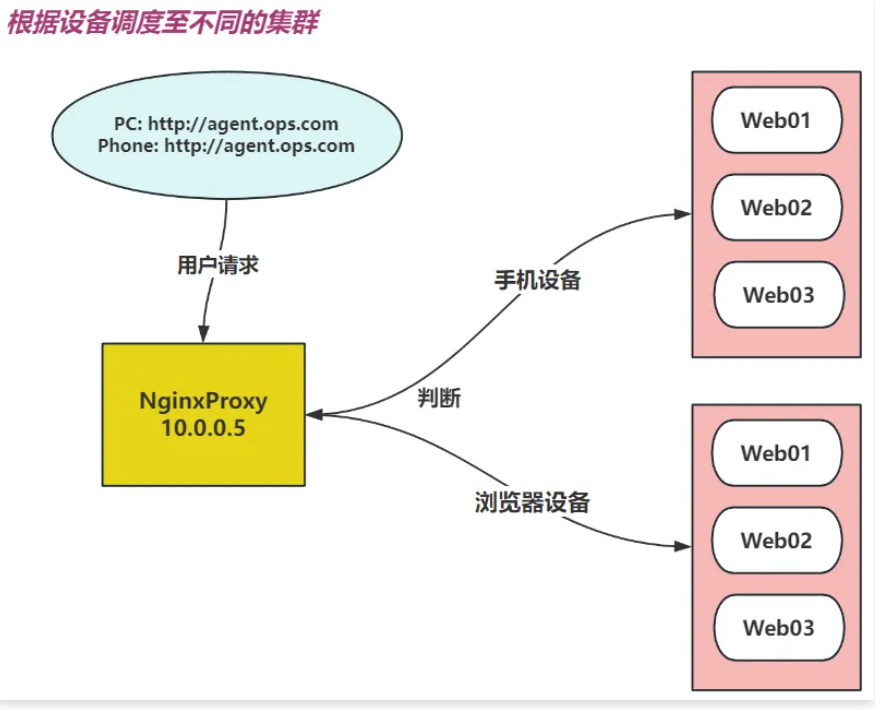

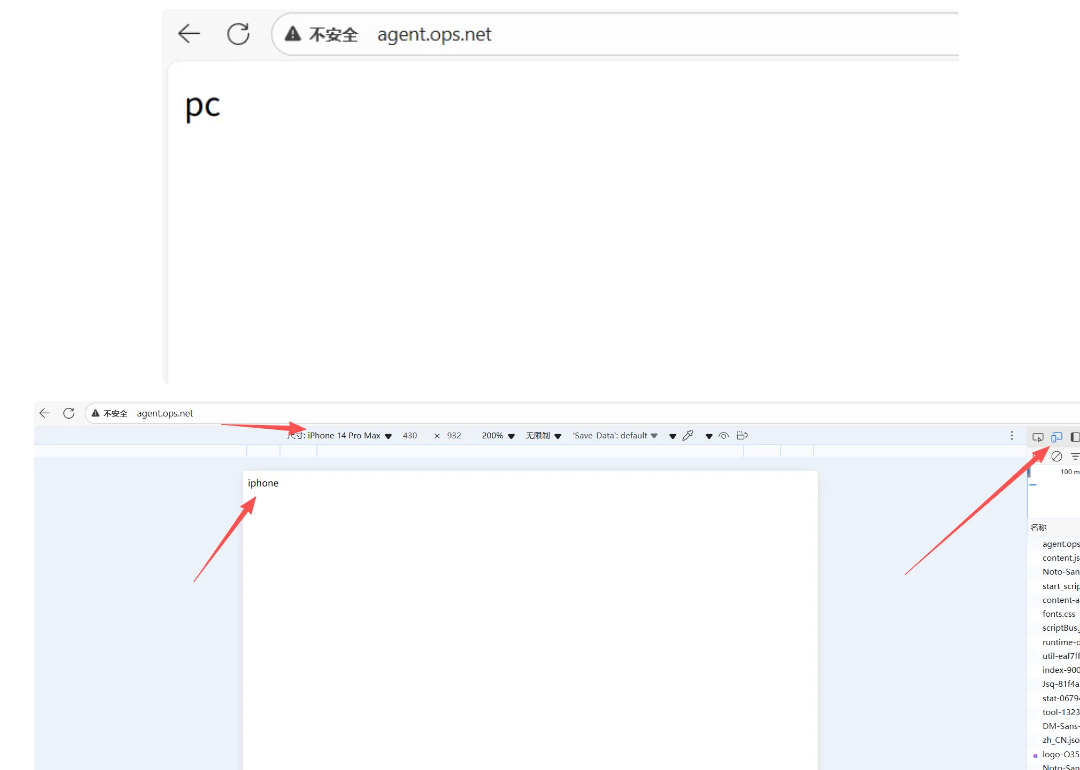

}